Noam Chomsky, por si no lo conoces, es un lingüista estadounidense. Aunque más bien podríamos llamarlo un intelectual: alguien que puede opinar de varios temas contingentes. Muchos lo consideran el padre de la lingüística moderna, otros un científico cognitivo y no faltan los que siguen con fervor sus visiones políticas e históricas. Un intelectual a la vieja usanza, que se para en la plaza pública y puede meter la cuchara en (casi) cualquier tema.

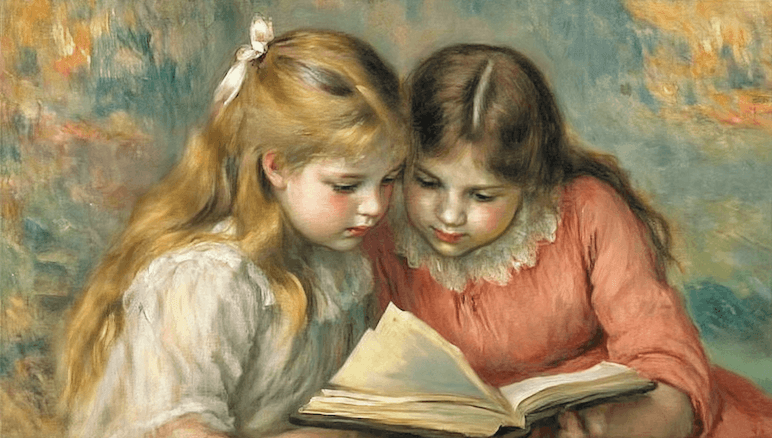

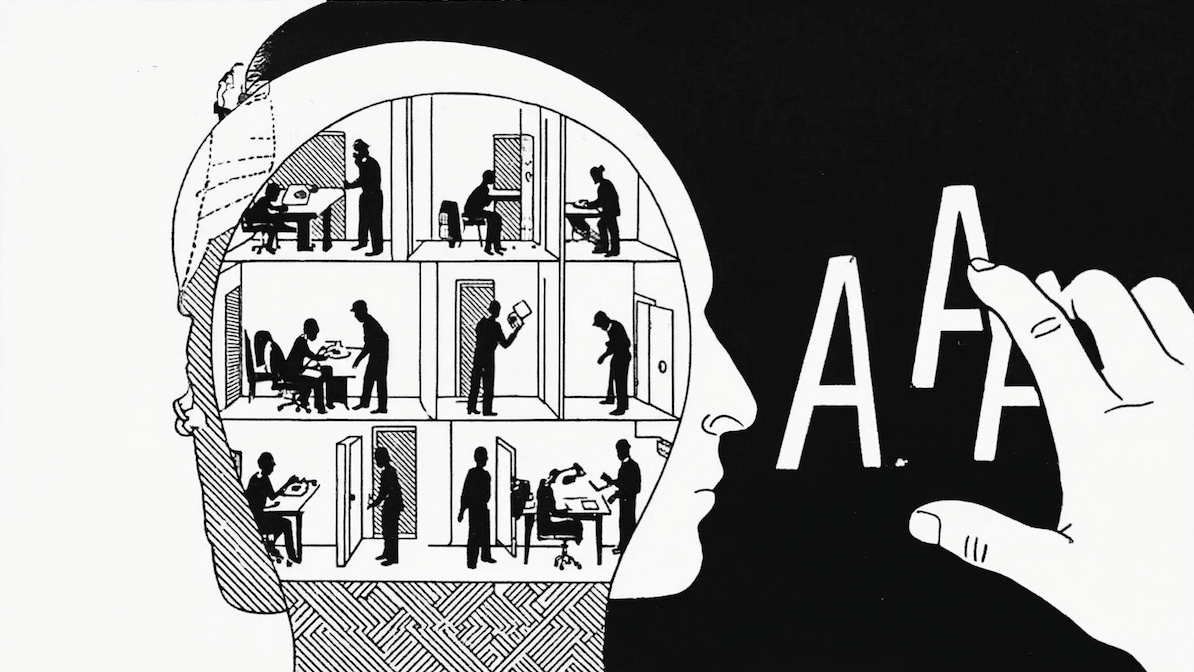

Su mayor prestigio viene de ser uno de los fundadores de la Teoría de la Gramática Universal, que dice, en términos simples, que nuestro cerebro viene pre-programado para adquirir y desarrollar el lenguaje: está diseñado para aprenderlo. Esto se basa en que, según Noam, todas las lenguas tienen determinados principios comunes compartidos, que ayudan a los niños a incorporar el lenguaje.

Por eso, era de esperar que tuviera una opinión fuerte con respecto al tema de moda: la inteligencia artificial y los chatbots (GPT, Bard o Sidney, elija el de su preferencia). Y su opinión es, por lo bajo, controversial.

¿Qué dijo Chomsky?

Mientras todos estamos un poco embelesados por la capacidad de GPT de producir texto que parece escrito por una persona, Chomsky hace de aguafiestas profesional: la inteligencia artificial no está ni cerca de igualar las capacidades humanas.

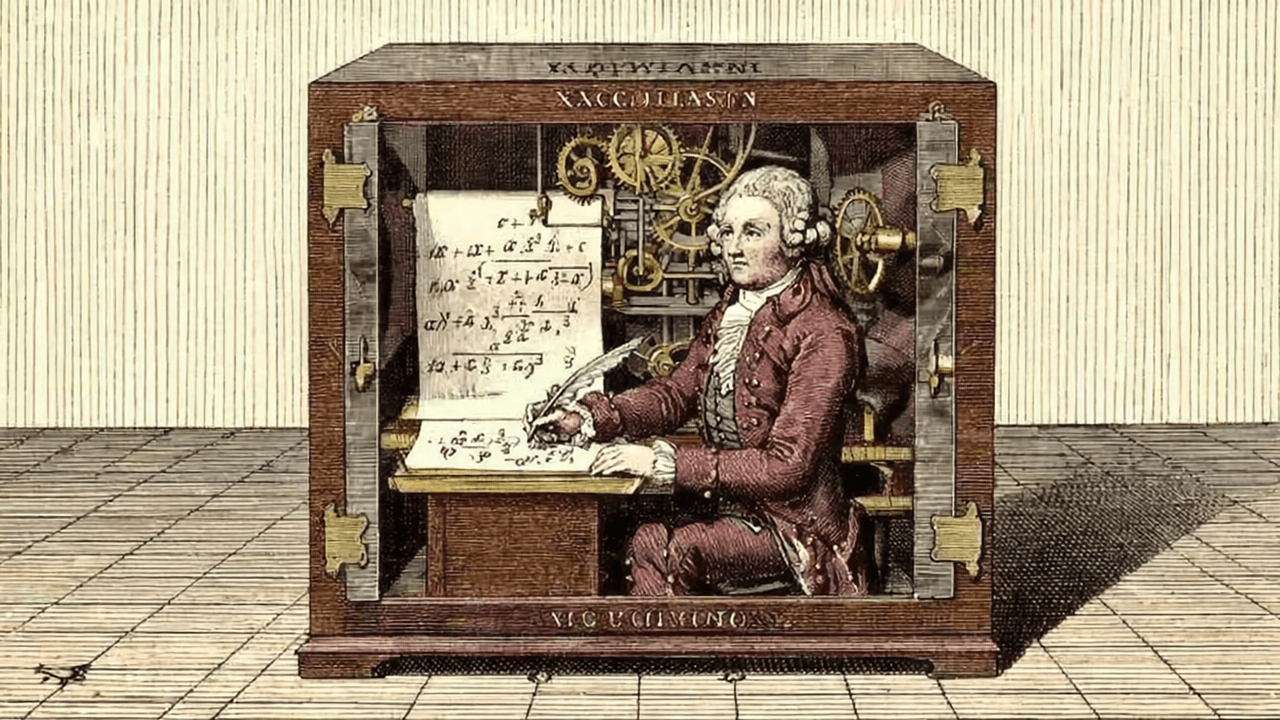

Según Chomsky, si bien la inteligencia artificial puede producir texto que parezca humano, tiene varios límites. Mientras que las IA se sustentan en procesar muchas cantidades de información para producir textos e ideas, el ser humano hace mucho con poco. La mente humana busca explicaciones para las cosas, no correlaciones, dice el lingüista. La IA puede predecir y describir, pero no crear explicaciones que antes no existían.

“Su falla más profunda es la ausencia de la capacidad más crítica de cualquier inteligencia: decir no solo cuál es el caso, cuál fue el caso y cuál será el caso, eso es descripción y predicción, sino también qué no es el caso y qué podría y no podría ser el caso. Esos son los ingredientes de la explicación, la marca de la verdadera inteligencia.”

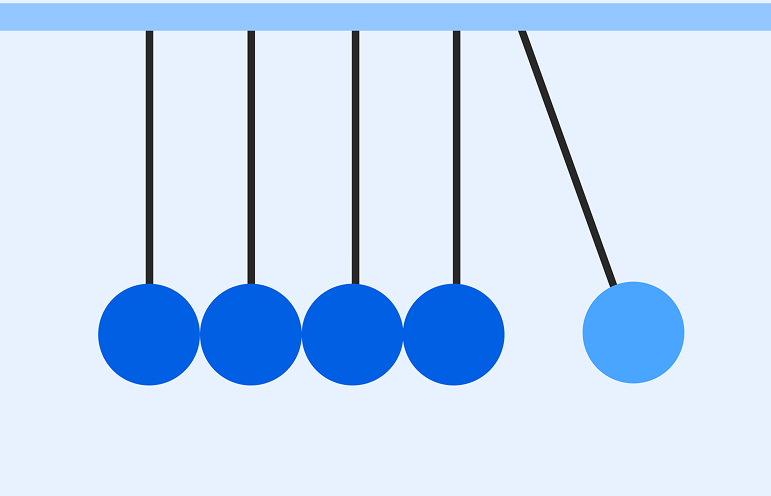

Complejo, lo sabemos. Pero queda más claro con un ejemplo: tienes una manzana en la mano. La sueltas y ves que se cae al piso. “Se cayó”, dices. Eso es una descripción. Una predicción sería “si la suelto, la manzana caerá”. Una explicación es algo más: incluye predicciones y descripciones, pero también conjeturas contrafactuales (“cualquier objeto caería”) y cláusulas adicionales: “debido a la fuerza de gravedad”. Eso es dar una explicación causal, dice Chomsky. Y poder afirmar “la manzana no se habría caído si no fuera por la fuerza de gravedad”: eso es pensar.

Pensar también es equivocarse, recordar mal, inventar explicaciones totalmente irracionales o imposibles, ser creativo. Ahora bien, llama la atención que Chomsky diga que equivocarse es una diferencia entre el pensamiento humano y el de una inteligencia artificial cuando de las características que se han estudiado de ChatGTP es su capacidad de alucinar: inventar cosas que no son fieles a la fuente de datos de la que se alimenta.

En el foro Hacker News de Y Combinator dan un muy buen ejemplo de alucinación, que se parece bastante a la mentira que haría un escolar en una tarea:

Pero la crítica que hace Chomsky a ChatGPT no profundiza en la diferencia entre la equivocación humana y las alucinaciones de la inteligencia artificial. Prefiere pasar rápido al siguiente argumento: pensar con el lenguaje es también constreñir miles de explicaciones usando una serie de principios morales. Algo que la IA no puede hacer según el lingüista, salvo repitiendo los prejuicios que sus propios set de datos contienen.

Bien aguafiestas Chomsky, hay que decirlo. Tal vez, el hype que se vive en estos días por la inteligencia artificial capaz de escribir como un humano, no tiene tanto que ver con que sean inteligentes como humanos, sino más bien que son inteligentes con los humanos. Algo así explicó Agustín Feuerhake, uno de los fundadores de Fintual, en esta columna. En resumen, que la próxima generación debería aprender a escribir prompts, esto es, a comunicarse y darle instrucciones precisas a los chatbots. Con, no versus.

Y la importancia de saber escribir un prompt es un buen punto: una de las críticas que se le hace a Chomsky es que no supo o no quiso escribir los prompts para comprobar si las críticas que le hacía a la inteligencia artificial eran correctas. Más bien especuló con los errores posibles, sin comprobarlos.

Adele Golberg, la científica computacional que fue parte del equipo que inventó el lenguaje de programación Small Talk-80, lo destacó rápido y sencillo en su Twitter:

Asserts that the model 'may well' misinterpret

— Adele Goldberg (@adelegoldberg1) March 9, 2023

“john is too stubborn to talk to”

2 second test indicates it does just fine: pic.twitter.com/xTcTGlwkaM

En todo caso, la misma Adele recibió en ese hilo la insinuación de que su crítica al ensayo del lingüista era bien superficial y parecía adolescente:

Como ven, la columna causó revuelo. La teoría de la Gramática Universal de Chomsky, si bien es bastante aceptada, data de los años cincuenta, y harto se ha avanzado en lingüística desde entonces.

También nos encontramos con otro clásico argumento en Twitter: ninguna de las críticas que plantea Chomsky son nuevas:

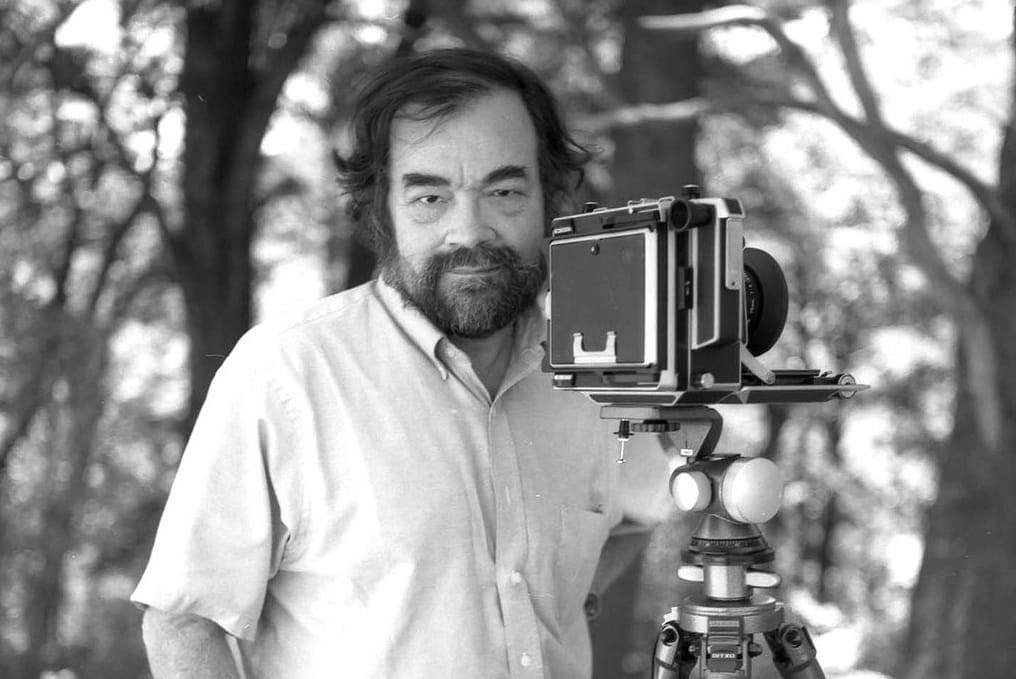

Nosotros aprovechamos de preguntarle a Gonzalo Mena, uno de nuestros autores expertos en estadística y machine learning. Mena coincide en varias de las críticas que se le hacen a Chomsky: repitió cosas que ya sabíamos hace tiempo (los modelos son buenos prediciendo, no tanto infiriendo causalidad, aunque la disciplina ya está trabajando en mejorar las inferencias causales hace años); Chomsky no supo armar bien los prompts para GPT; y ve con malos ojos al machine learning, lo que a Mena le parece un juicio destemplado: “ataca una disciplina entera (machine learning), al decir que está corrompiendo la ciencia. Creo que no corresponde manchar todo un campo por estar en desacuerdo con solo un ejemplo de ese campo (en este caso ChatGPT)”.

Su teoría de por qué Chomksy se atreve a hacer esa crítica con tanta soltura es que el lingüista tiende a criticar a las corporaciones, y el machine learning se ha convertido en una disciplina muy ligada a las empresas: “no son cosas que uno pueda hacer en la universidad–dice Mena–, requiere un nivel de cómputo que solamente está en la industria. Y esto genera el entendimiento, que yo creo que es erróneo o incompleto, de que machine learning es la ciencia de las corporaciones tech, y no es así”.

Por otro lado Gonzalo sí reconoce que la falta de moralidad o capacidad ética de los bots es un problema espinudo.

Ricardo Martínez en cambio, desde el frente de la lingüística (es doctor en lingüística y profesor lingüística computacional), tiene una opinión muy diferente. Dice que el argumento de Chomsky es el mismo hace años y simplemente está siendo consistente con sus propias teorías: lo que aparece en la columna es lo mismo que se puede ver en 1959 en su clásico artículo contra el conductismo del libro de Skinner Verbal Behiavior. En ese libro Skinner dice que el lenguaje es una colección de hábitos que se puede aprender: cuando un niño dice bien una palabra se refuerza y premia, y por eso adquiere el conocimiento. En cambio, Chomsky dice que el lenguaje es un sistema complejo innato.

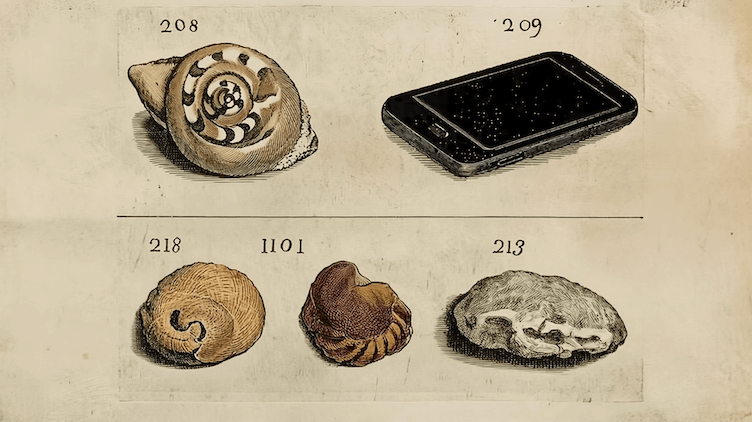

“En el fondo Chomsky siempre ha dicho que la inteligencia humana no es un aparato que está calculando probabilidades y optando por la mejor opción”, nos dice Martínez. “Yo creo que Chomsky tiene un punto, particularmente por el hecho de que los niños efectivamente aprenden con muchos menos datos que lo que aprenden estas máquinas. Un niño escucha unas 20 mil 30 mil palabras diarias durante los primeros años de edad, y con 30 mil palabras diarias por 365 días, son como 32 millones de palabras en sus primeros tres años. En cambio ChatGPT se inició en el mundo del lenguaje con sobre 570 mil millones de tokens. En conclusión, estas máquinas están usando una fuerza bruta que ningún ser humano podría usar”.

Aunque Chomsky tiene puntos atendibles, va a tener que acostumbrarse a que su forma de entender el lenguaje no es la única y ya no es la dominante: corre en paralelo con grandes modelos de lenguaje que están teniendo un momento de mayor aceptación (y para qué negarlo, hay también algo de moda), y que niegan que la adquisición del lenguaje sea innata. Incluso ya están saliendo artículos académicos al respecto

Pero le guste o no a Chomsky, los chatbots dieron un salto cuantitativo y parecen haber revolucionado el mercado de la inteligencia artificial. Por mientras, de fondo suena el clásico de Queen “Don’t stop me now”: recién salió GTP-4.

Y el punto no es si pueden aprender como humanos o si estarán siempre limitados, ese es un tema secundario ahora, lo importante será aprender a usarlos.