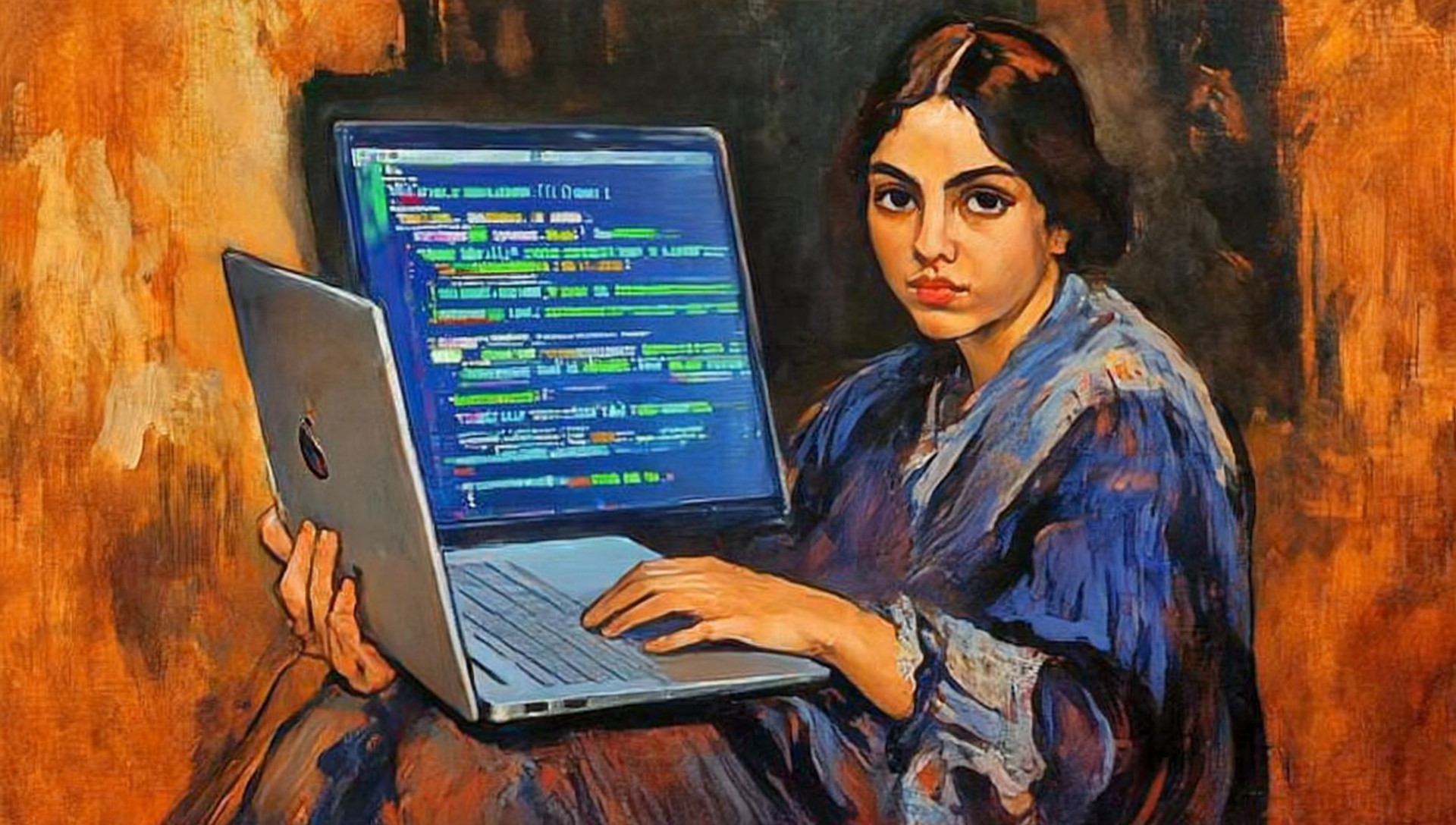

Mi primera aproximación a los computadores ocurrió en 1982, cuando cursaba séptimo básico. En aquellos días de finales de año de hace cuatro décadas, mis padres me inscribieron en un curso de BASIC, el lenguaje de programación que estaba de moda por aquel entonces y con el que se podía intrusear vía pequeñas consolas Sinclair –las viejas y queridas ZX81–.

A lo largo de todo ese mes de clases aprendí lo que era GOTO, RUN, IF-THEN; también aprendí los rudimentos de los diagramas de flujo y otras guarifaifas de la lógica que se escondían detrás de los códigos, que a menudo se escribían con saltos numerales de decenas o centenas al lado izquierdo de cada línea.

Pero lo más importante que me sucedió en aquella primavera-verano del ’82 no fue tanto iniciarme en la sintaxis de la programación, sino que la respuesta que me dio el profesor del curso, a una pregunta que le hice luego de finalizar una de sus clases:

“¿Y con BASIC puedo escribir música, o hacer dibujos, o crear mis propios videojuegos?”.

“Sí”, dijo el profe, “con los computadores se puede hacer de todo, se puede hacer cualquier cosa”.

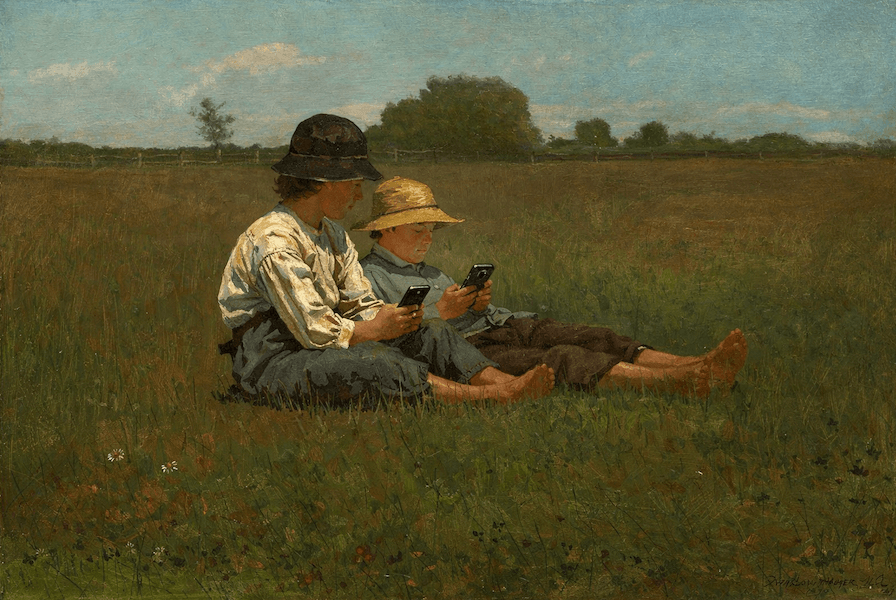

40 años después, en su carrera por el perfeccionamiento de la Inteligencia Artificial orientada a tareas de lenguaje, OpenAI lanzó, hace tan solo unos días, una nueva aplicación llamada ChatGPT, que, aunque no lo parezca, está en el mismo negocio de BASIC: hacer casi cualquier cosa con un computador.

¿Qué es ChatGPT?

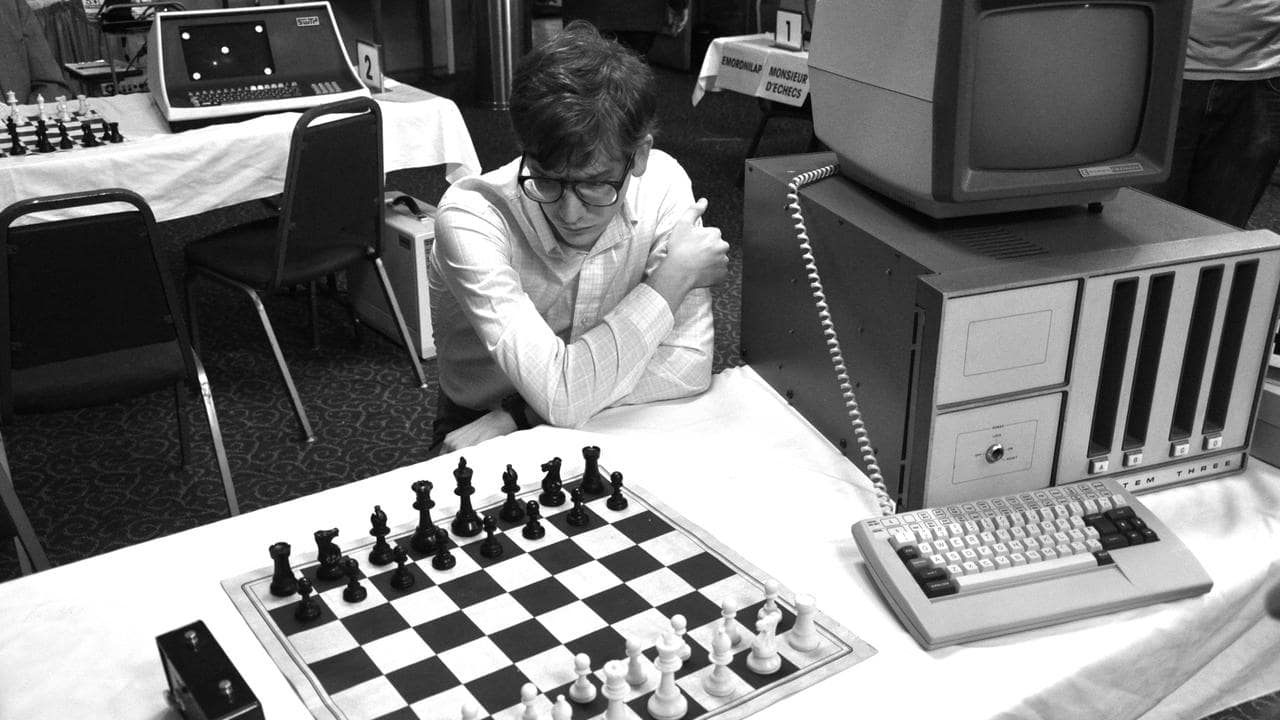

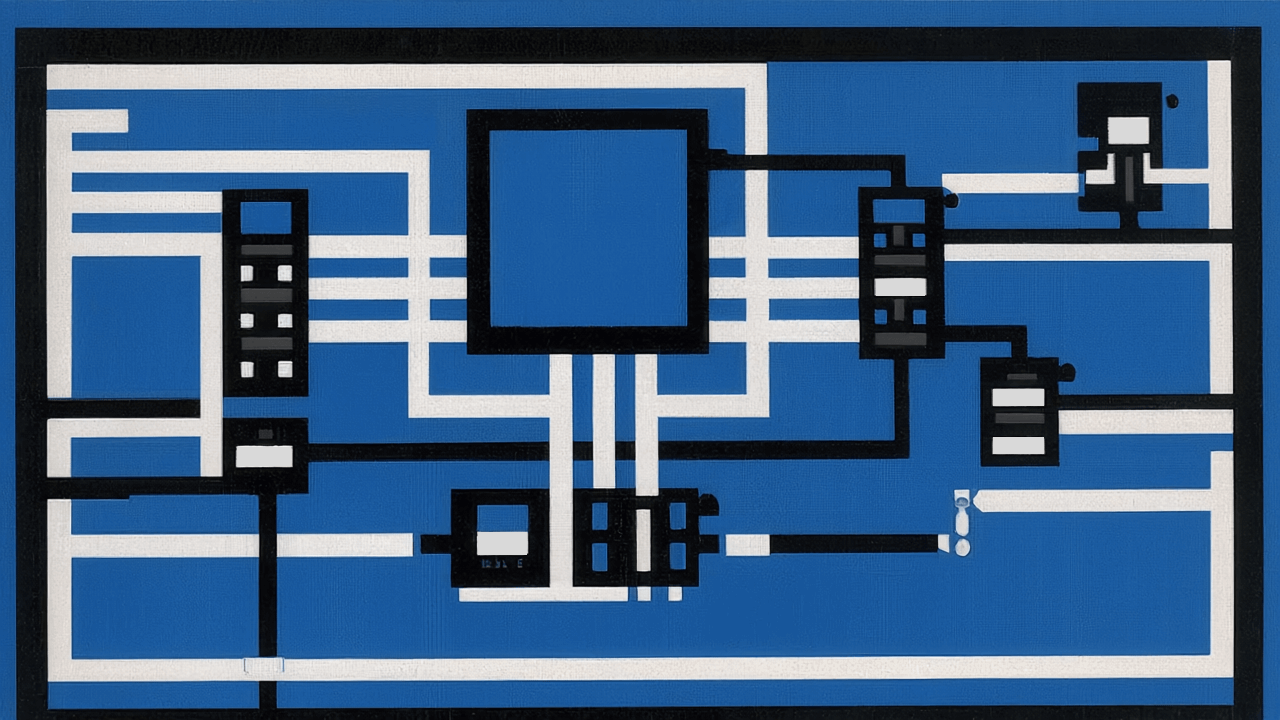

ChatGPT es un desarrollo a partir de GPT-3, el “Transformer” que interactuaba con personas en lenguaje natural vía un terminal de texto e imagen, y que realizaba una serie de actividades mediante un cuadro de diálogo. Desde crear artículos, escribir poesía, cuentos, reportajes, diálogos e incluso líneas de código; así como jugar ajedrez indicando las posiciones de las jugadas, tipo “P4R” (mueva el Peón a la casilla cuarta del Rey), sacar los acordes de una composición musical tipo “Dm7 – C9 – Cmaj7”; o cambiar de idioma en la interacción, cuando, por ejemplo, se le escribía “Pouvons-nous commencer à converser en français?”.

Mucha agua corrió bajo el puente luego de la irrupción de GPT-3, pero había algo que aún no estaba totalmente afinado o ajustado: el mantener un diálogo con quienes interactuaban con el modelo. Si bien GPT-3 avanzó bastante en esto, todavía deja mucho que desear.

Entiendo que esto te pueda parecer mucha información, así que para que entiendas mejor hasta dónde ha llegado la carrera por diseñar una inteligencia artificial que pueda hablar y entender igual que nosotros, voy a abordar tres preguntas sobre el impacto y las potencialidades de estas aplicaciones:

1) ¿Podrá ChatGPT o alguna de sus futuras versiones reemplazar a Google como servicio de consulta general?,

2) ¿Se acercarán en un horizonte de tiempo cercano a la poción mágica del entendimiento general del lenguaje?

3) ¿Puede ChatGPT superar la crítica de la habitación china de Searle? Esta sostiene que estos dispositivos no hacen otra cosa que manipular texto en términos de responder estereotipadamente sin atender a la semántica y que, en consecuencia, no son inteligencias, sino solamente aplicaciones muy elaboradas.

El mundo pre-Google

Vuelvo a 1989: figuraba como estudiante de ingeniería (aunque no seguiría mucho más tiempo en la carrera) Estaba en un helado y oscuro subterráneo del campus Beauchef de la Universidad de Chile, frente a uno de los terminales de computación usando la red Reuna, donde se podía acceder a archivos en computadores de otros lados, y que era uno de los primeros servicios de lo que luego sería en propiedad la Internet.

Y era asombroso: podía bajar imágenes, letras de canciones (recuerdo en particular haber descargado las letras del disco de Marillion, Misplaced Childhood) y tantas cosas más; al punto que modifiqué la pregunta hecha de niño al profe de BASIC: “¿Esto que estamos usando, tiene todas las respuestas?”.

La indagación era siempre la misma: ¿hay una respuesta para esto, y para esto otro, y para esto de más allá?

La llegada –ahora masiva– de Internet a Chile, avanzada la década de 1990, le puso paños fríos a la búsqueda de la respuesta a todas las preguntas. Porque navegar por Internet en aquellos días, fuera a través de Yahoo! o de Altavista, redundaba en pocos “guaus” y muchos “grrrs”.

Era una frustración tras otra, porque llegar a encontrar la respuesta a lo que se consultaba suponía avanzar páginas y páginas de resultados de estos buscadores ahora prehistóricos –y no estoy hablando de decenas, sino que de centenares de páginas-.

Solo con Google el escenario cambió. Y Google fue como volver a ese entusiasmo del BASIC y de aquella sala entumida de la Chile.

Y luego vino la Wikipedia, que realmente parecía que tenía, como el Multivac de Asimov, la respuesta para todas las preguntas. Al punto que hubo un momento en el que se acuñó el dicho “¿preguntémosle a la Wikipedia?”, cuando alguien sabía que debía haber una respuesta precisa para cosas como quién fue el goleador italiano del Mundial de 1934, o cómo se llamaba la actriz secundaria de aquella high school movie que vimos cuando eramos chicos.

Para que te hagas una idea de la diferencia que existía entre estos primeros buscadores y lo fácil que es encontrar algo hoy día, te dejo un ejemplo que daba hace dos décadas Ricardo Baeza-Yates:

“Supongamos que queremos encontrar a qué velocidad corre un jaguar buscando las siguientes palabras: jaguar speed (queramos o no, el idioma más usado en la Web es inglés y tal vez tengamos que convertir millas por hora a kilómetros por hora).

El resultado en 1998 de AltaVista es un montón de páginas acerca del auto Jaguar, un juego de video para Atari, un equipo de fútbol americano, un servidor de redes locales, etc. ¡La primera página acerca del animal está en el lugar 183 y es una fábula!

Si intentamos eliminar los documentos acerca del modelo de auto, igual encontraremos páginas acerca de él que no mencionan ni car, ni auto. Tratemos jaguar speed +cat, que indica que la palabra cat (felino) debe estar en el documento. Los dos primeros resultados son acerca de los clanes Nova Cat and Smoke Jaguar, luego, la empresa LMG, seguido de automóviles finos.

La número 25 es la primera con información de jaguares, pero tampoco tiene lo que necesitamos. Si miramos en Yahoo!, podemos buscar en Science:Biology:Zoology:Animals:Cats:Wild_Cats y en Science:Biology:Animal_Behavior, pero en ninguno encontramos una página acerca de jaguares”.

O sea, la consulta de la velocidad de un jaguar (el felino) debía hacerse de manera lo suficientemente precisa, acotada y orientada, para llegar a una respuesta satisfactoria. Y ese proceso suponía que el usuario debía desarrollar una cierta capacidad de interacción con la red que le supusiera finalmente espetar más “guaus” que “grrrs”.

Lo que GPT-3 y ChatGPT hacen es justamente seguir afinando la puntería de las respuestas hacia esa esperanza que prometían el BASIC de 1982 o la Reuna de 1989. Y luego el Google de inicios de los 2000, o la Wikipedia de algo más de un lustro más tarde: un avance fundamental hacia aquella poción mágica de respuesta a todas las preguntas, hacia un mundo de consultas y diálogo con los computadores y la Internet post-Google.

Primeras aproximaciones a un mundo post-Google

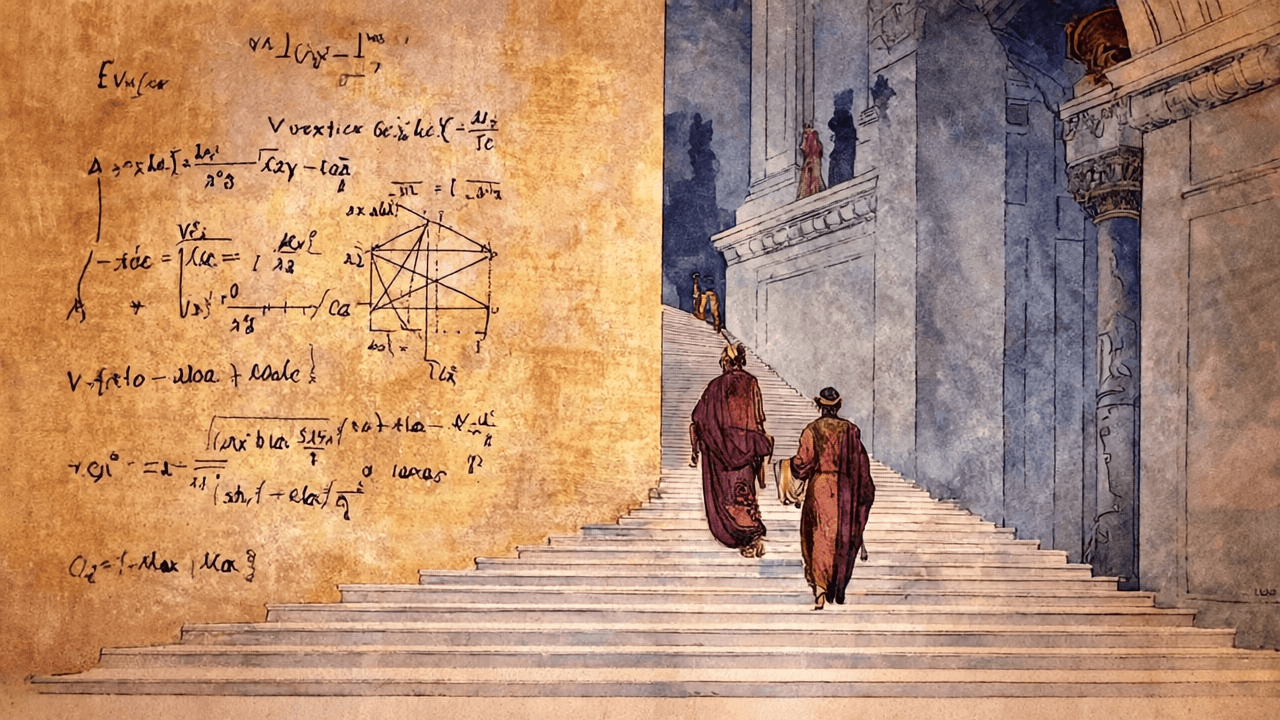

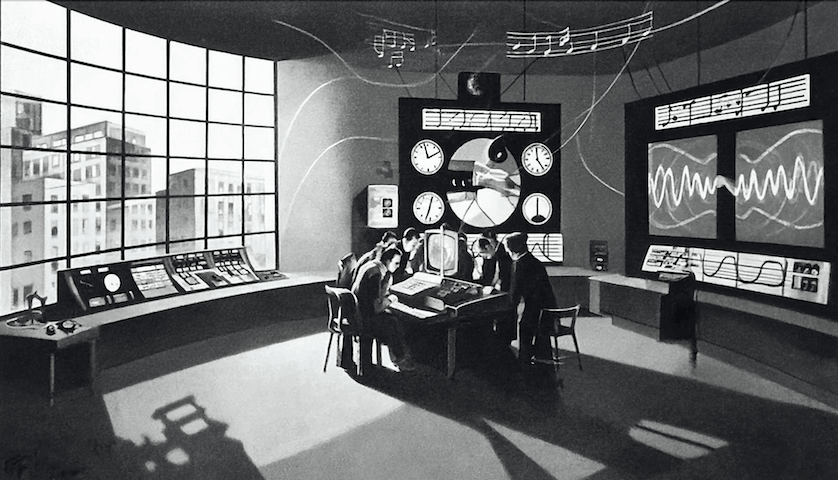

Suele decirse en los cursos de lingüística computacional que la disciplina ha pasado por tres fases: 1) la era Computacionalista Clásica (que va desde sus inicios en los años cincuenta hasta fines de la década de los noventa), 2) la era Estadística (que va desde el libro seminal de Manning & Schütze en 1999, hasta la primera década de los 2000), y 3) la era del Deep Learning (que comienza hace una década y se extiende hasta hoy).

En esta tercera ola de la lingüística computacional, el momento inaugural es la irrupción del Word2Vec en 2013: un sistema de matematización de las palabras que permitió distribuir vocablos en espacios vectoriales con valores numéricos de implicación semántica, y que se debió a la publicación de un paper esencial firmado por Tomas Mikolov de Google.

En sencillo: al disponer las palabras de un corpus (colección masiva de texto en lenguaje natural) en un espacio vectorial, se podían realizar análisis numéricos de las distancias entre dos palabras (distancia semántica) o llevar a cabo una rutina que parecía asimismo magia: realizar operaciones geométricas entre palabras, como el ahora clásico ejemplo de:

word2vec("king") - word2vec("man") + word2vec("woman") = word2vec("queen")

Esto es que si se toma el vector de “king” y se le resta el vector de “man” y a ese resultado se le suma el vector de “woman”, la máquina responde como resultado, “queen”. O sea, Rey-Hombre+Mujer=Reina.

El siguiente avance en esa línea –que ya usaba procesos de redes neuronales profundas , aka Deep Learning– fue ELMo (implementado en 2018), que no solo podía ubicar las palabras en espacios multidimensionales, además reconocía que una misma palabra podía tener diferentes acepciones, como por ejemplo “llave”, que puede bien ser la llave de una puerta o la llave del agua, o “banco”, que puede corresponder a un edificio o a un asiento.

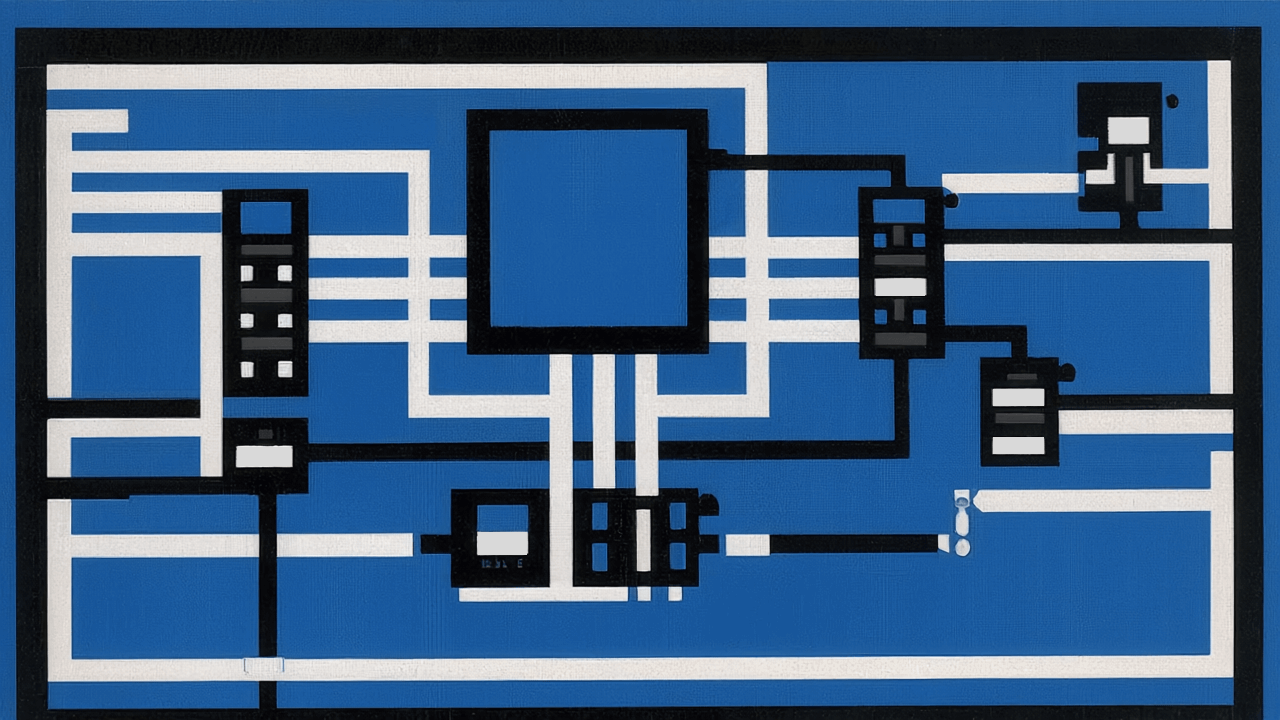

El tercer avance fue la irrupción de los “Transformers”, que básicamente corresponden a rutinas que interpretan textos y dan una respuesta, esto es, “decodifican” un texto que se les ingresa, a menudo en modo de consulta, y “codifican” un texto para responder a la consulta. Estas rutinas pueden responder a interrogantes o textos en lenguaje natural y parecen atender a todo tipo posible de intercambios, como los que mencionaba al principio.

Qué es al algoritmo BERT

El programa inicial que abrió la ruta a estos sistemas “Transformers” fue Bert (también de 2018), que, tal como ELMo, jugaba con nombres sacados de Plaza Sésamo. Bert tenía una habilidad sobre sus antecesores como Word2Vec o ELMo. No estaba diseñado para atender a ninguna tarea específica, sino que a un par de tareas generales: ser capaz de encontrar las palabras (o morfemas –segmentos de palabras–) faltantes –porque se han borrado– en un texto, como en el ejemplo, “Juan chuteó la X e hizo un gol”, donde Bert debía descubrir que la palabra faltante, reemplazada por la X, era “pelota”. Además, era capaz de reconocer cuando dos oraciones han sido puestas al revés: “Hizo un gol. Juan chuteó la pelota”, donde Bert debía descubrir que el orden convencional es en realidad, al revés.

Con un entrenamiento (pretraining) en estas dos tareas, Bert luego podía ser ajustado de manera fina (finetunning) en otras tareas.

¿Como cuáles?

Prácticamente todas las tareas de NLP (Natural Language Processing) a lo largo de las últimas tres décadas, como el análisis de sentimientos, el topic modeling, la atribución de autoría, la comparación de similitud de dos párrafos o preguntas, la clasificación de un texto según género, y toda otra enormidad de pruebas.

La hora del pegamento (GLUE)

A tanto llegó la diversificación de tareas en que Bert o sus sucesores fueron finetuneados, que pronto se hizo necesario contar con algún tipo de estándar para evaluar cuán bien funcionaban dichas rutinas. Había que hacer un test para poder compararlos.

Y aquí hace su entrada GLUE [el pegamento mágico].

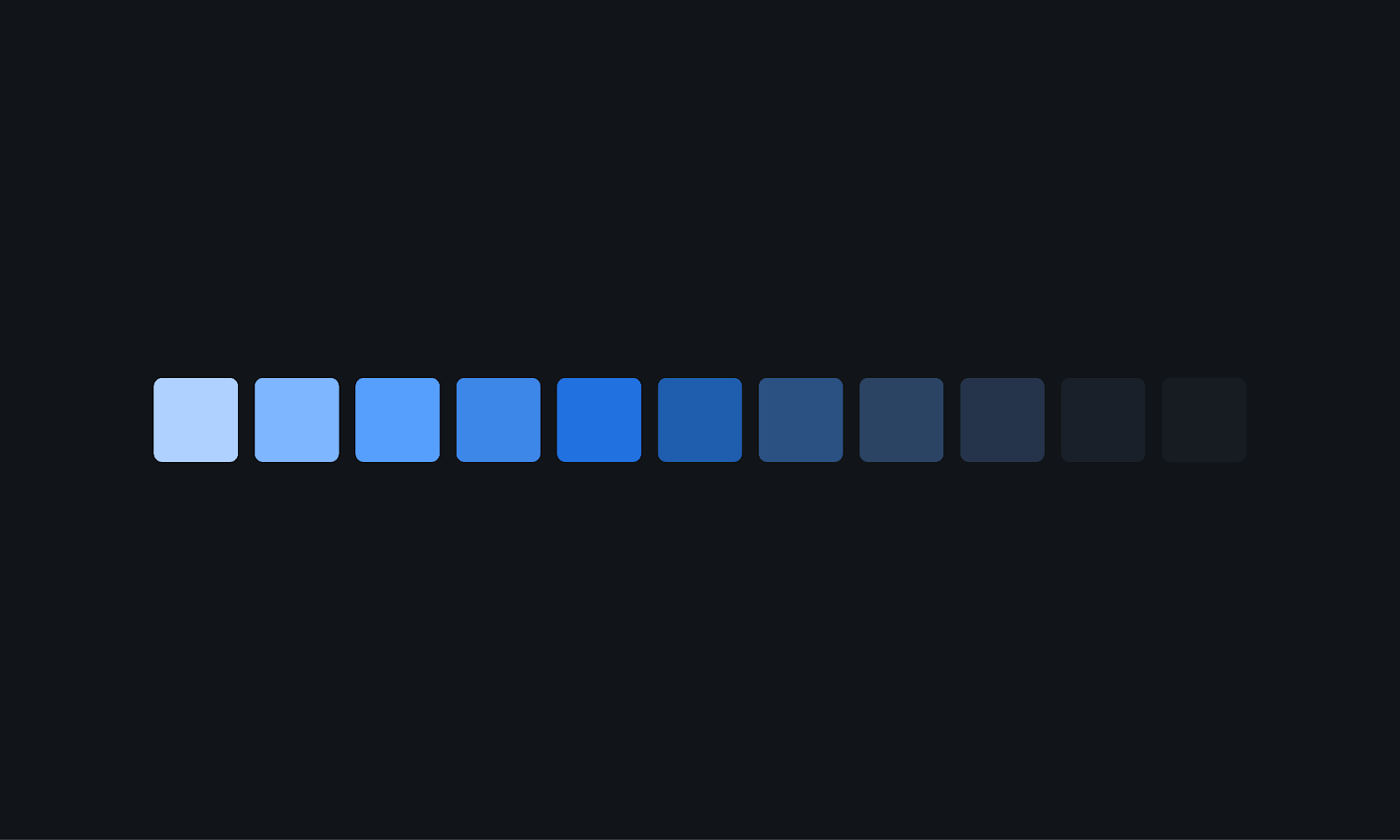

GLUE es la sigla para General Language Understanding Evaluation (“evaluación de la comprensión general del lenguaje”), que consiste en un dataset de nueve tareas generales acerca del procesamiento de lenguaje realizadas por programas computacionales y que fue presentado en 2019 por un equipo encabezado por Alex Wang del Courant Institute of Mathematical Sciences, de la New York University. Algo así como la PSU de lenguaje de los programas de IA.

La batería de tareas de GLUE incluye pruebas de clasificación de oraciones completas, como el análisis de sentimientos de las mismas, o determinar si se trata de una oración gramaticalmente aceptable o no; tareas de comparación entre oraciones o textos, como encontrar parejas de oraciones que corresponden a una misma pregunta en Quora; o relaciones entre un texto y una consulta, como por ejemplo, determinar en qué segmento de un párrafo se halla la respuesta a una consulta.

El objetivo es hacer una evaluación general de la destreza de los programas post-Bert para batírselas con una amplia gama de desafíos de comprensión y, obviamente, con la producción de lenguaje natural (en cualquier lengua, dado que los sistemas tipo Bert se han implementado en un sinnúmero de idiomas e incluso, en algunas ocasiones, de manera multilingüe).

ChatGPT está, de una u otra manera, en todas las líneas anteriormente descritas: es generalista pero también puede realizar tareas de tuneo fino, y sin duda juega en las mismas ligas que Google y Wikipedia.

Pero…

Los peligros de encerrarse en una habitación china

Quienes vieron por TV el Supertazón de 2010 quedaron absolutamente sorprendidos con una publicidad que comenzaba con un cursor parpadeando sobre una caja de consulta, y que luego se ampliaba para mostrar el buscador de Google y se llenaba, en una secuencia de tecleo, con la pregunta “study abroad paris”. La publicidad mostraba de manera simple y minimalista una historia de vida y amor solo sobre la base de interacciones con Google, desde la inquietud inicial de estudiar en París, hasta el momento de la boda, pasando por información sobre horarios de vuelos, datos de direcciones, solicitudes de traducción de frases en francés y así.

Esto que no solo parecía, una vez más, magia, sino que en menos de un minuto desplegaba las potencialidades del buscador creado por Sergei Brin y Larry Page, es lo que ChatGPT, y otras aplicaciones competidoras que de seguro irán apareciendo, están intentando superar.

Sin embargo, todavía queda una duda bastante básica: ¿cómo contestan las dudas que uno les hace?

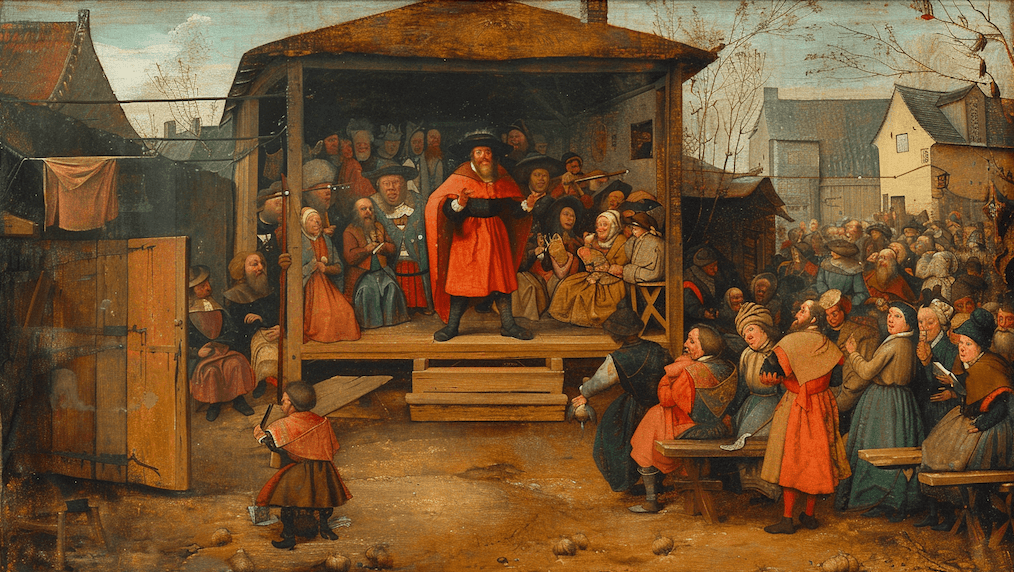

Porque obviamente siempre que se dan estos desarrollos vuelve al ruedo el tema de la inteligencia y se menciona el Test de Turing, y alguien empieza pronto a decir que, tal como Eliza o Parry en los sesenta, estos chatbots solo responden con fórmulas preformateadas.

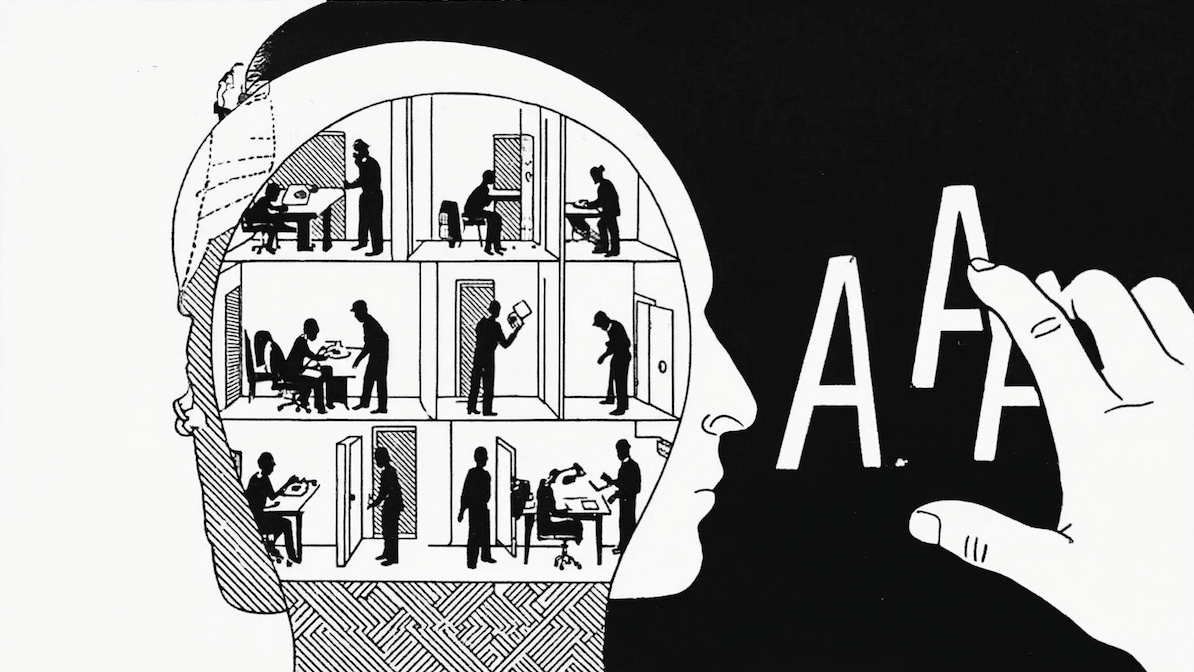

Así que, para explorar esto, le he preguntado al propio ChatGPT, mencionando la habitación china del filósofo del lenguaje John Searle.

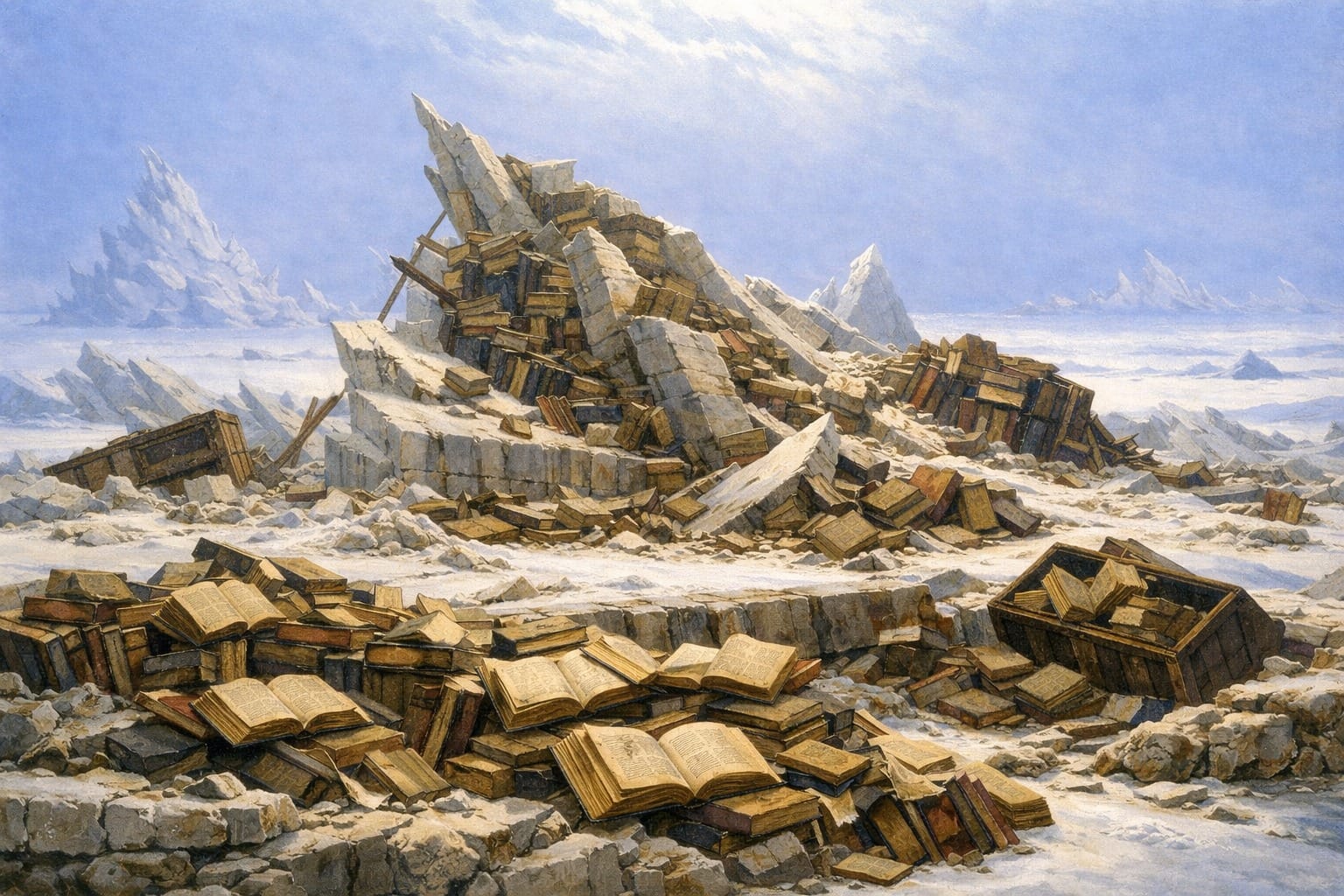

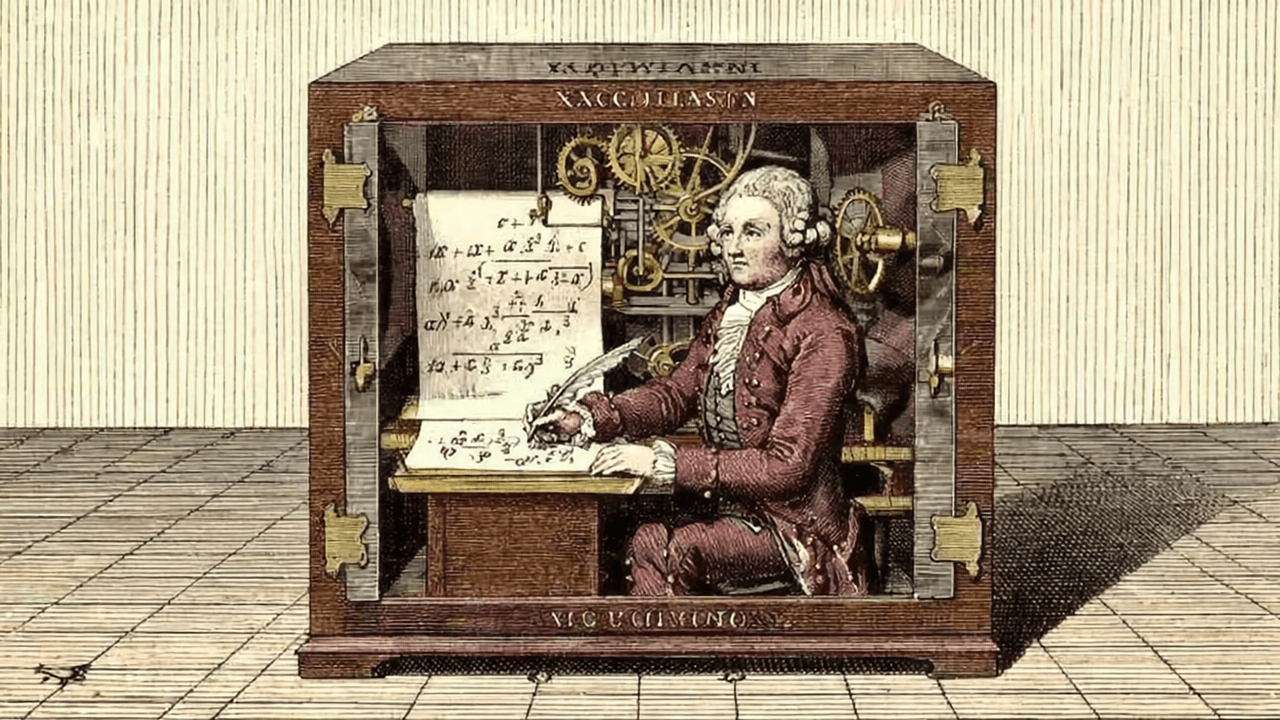

La habitación china dice que si a una persona la encierran dentro de una sala en que hay muchos libros con preguntas y respuestas en chino, y se le pasa una pregunta escrita en chino, esta persona puede finalmente dar con una respuesta dentro de la biblioteca, pero esta persona en realidad no sabrá nada de chino, es decir, no tendrá conocimiento semántico.

“Voy a precisar más la pregunta. Si el modelo de la habitación china descansa en que en ella hay respuestas escritas en chino para las preguntas que se le introducen, no hay capacidad de generación de respuestas, solo una especie de búsqueda de las mismas. Los Transformers similares a ti sí pueden generar. Así, la habitación china solo puede contestar las respuestas que tiene, pero no puede responder a preguntas que exijan elaborar una respuesta”.

Y Chat GPT contesta:

“Sí, eso es correcto. El argumento de la habitación china de Searle se basa en la idea de una persona que no conoce el idioma chino que está en una habitación con libros escritos en chino y una serie de reglas escritas en chino que le permiten responder a preguntas en chino. Según esta teoría, la persona en la habitación no tiene la capacidad de generar respuestas originales, sino solo de seguir las reglas para encontrar las respuestas apropiadas en los libros. Por lo tanto, la habitación china solo puede responder a preguntas para las que tiene respuestas pre-determinadas, pero no puede responder a preguntas que requieran una respuesta original o creativa. Los modelos de lenguaje como yo, que utilizan tecnología de transformadores, sí tienen la capacidad de generar respuestas originales basándose en una gran cantidad de datos y utilizando técnicas de aprendizaje profundo. Sin embargo, mi capacidad está limitada al conocimiento que se me ha proporcionado durante mi entrenamiento y no puedo responder a preguntas que excedan ese conocimiento”.

Esto último es sumamente cierto. La misma pantalla de inicio de ChatGPT señala como “Limitaciones”, que este “en ocasiones genera información incorrecta” o que “tiene conocimiento limitado acerca del mundo y los eventos posteriores a 2021”.

En otra consulta hecha para determinar la precisión de las respuestas de ChatGPT le pedí que me hablara de Alejandro Zambra.

Y ChatGPT contestó:

“Alejandro Zambra es un escritor chileno conocido por sus novelas y cuentos. Entre sus obras más conocidas se encuentran "Bonsái" (2006), "La vida privada de los árboles" (2010) y "Formas de volver a casa" (2011). También ha publicado varios poemas y ensayos. Zambra comenzó a escribir a temprana edad y su trabajo literario se caracteriza por su estilo simple y directo, y su interés en temas como la memoria, la identidad y la política. Ha recibido numerosos premios y reconocimientos por su trabajo, incluyendo el Premio Alberto Fuguet de Novela en 2006 y el Premio Herralde de Novela en 2011”.

El problema es que no hay un Premio Alberto Fuguet de Novela, ni Zambra ganó el Premio Herralde de Novela de 2011.

ChatGPT está chamullando.

A tanto llega el nivel ocasional de chamullo de ChatGPT que una de sus habilidades más celebradas en los últimos días, la elaboración de códigos computacionales, ha sido ahora fuertemente cuestionada. Según The Verge, “Stack Overflow, el sitio de preguntas y respuestas para codificadores y programadores, ha prohibido temporalmente que los usuarios compartan las respuestas generadas por el chatbot de IA ChatGPT”.

Es verdad que en su interacción verbal ChatGPT suele señalar que no cuenta con toda la información, que a veces no es capaz de encontrar una respuesta, etc., pero eso todavía no alcanza para que el mecanismo logre evaluar su propio desempeño antes de contestar.

Así que sintetizando y yendo a las ideas que se planteaban al inicio de este texto:

¿Reemplazará ChatGPT a Google?

En su versatilidad, sí, pero probablemente se requiere que el sistema atienda a información del momento, y no solo a la que se le ha cargado. ChatGPT no puede en estos momentos responder cuántos grados de calor harán hoy en Temuco.

¿Es ChatGPT una inteligencia general verbal?

Aunque el mismo ChatGPT me contestó en otra consulta que no había sido testeado por GLUE, lo más probable es que, si bien no es la inteligencia verbal más general, sí se trata de un enorme avance en este sentido.

¿Supera ChatGPT el problema de la habitación china de Searle?

A todas luces no, puesto que no es siempre consciente de su propio conocimiento y, si bien no es solo un repositorio de respuestas estereotipadas y puede elaborar textos muy complejos, su extraordinaria capacidad generativa no lo distancia todo lo suficiente que se quisiera de los chatbots del pasado.