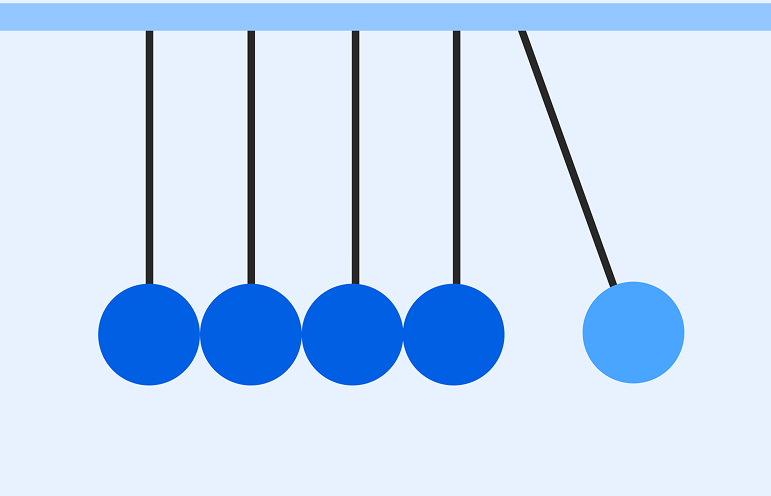

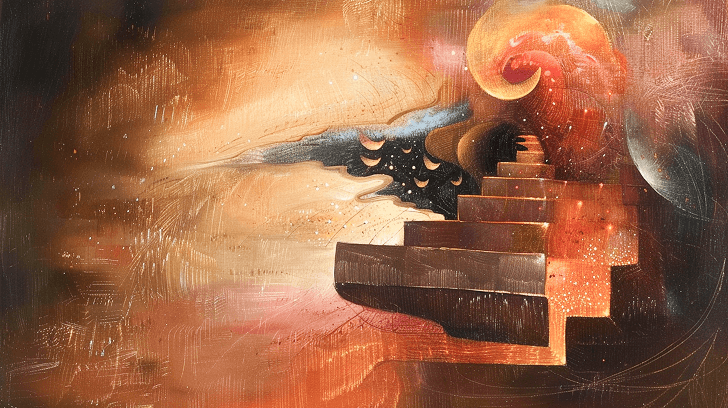

La historia de la IA para generar imágenes y videos es, en el fondo, la historia de dos curvas que se están acercando[1] en una carrera a toda velocidad. El avance de la investigación sigue una curva exponencial: cada descubrimiento se apoya en el anterior y multiplica las capacidades a un ritmo cada vez más rápido. La adopción en los productos, en cambio, pareciera seguir una función en forma de escalera: largos periodos que parecen estancados, interrumpidos por saltos dramáticos y repentinos.

Pero estas curvas están convergiendo. Y están convergiendo bien rápido. La distancia entre lo que es posible en investigación y lo que se está lanzando en productos se está achicando a gran velocidad. Falta poco para que los loops de productos no se puedan distinguir de los loops de investigación. Esta convergencia cambia absolutamente todo sobre cómo deberíamos pensar la construcción, inversión y evaluación que hacemos sobre los cambios que la IA está teniendo en los medios que creamos y queremos crear (spoiler: van a ser los mismos medios).

Pero lo más importante, es que dependiendo de cuál crees que es la verdad sobre esta convergencia y qué tan adelante en el futuro se va a dar, vas a apostar por distintas cosas. Tu tipo de optimización, lo que elijas maximizar cuando eres una organización creativa, empresa de entretenimiento, estudio de videojuegos, agencia de publicidad, o como persona que en su día a día crea algún tipo de contenido o videos… será fundamentalmente diferente.

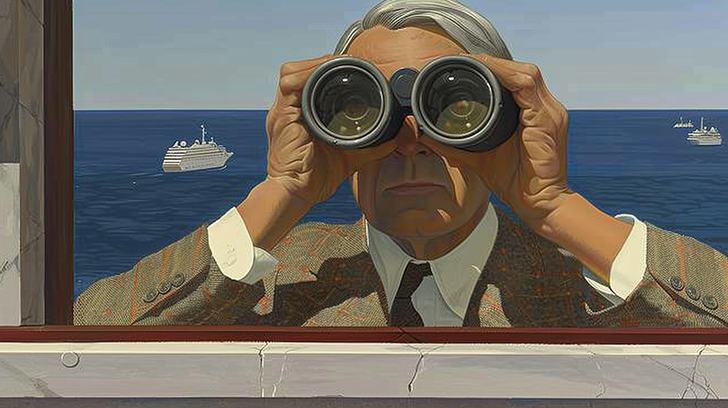

En la última década existe un patrón común en las organizaciones que no hacen investigación en IA: subestiman drásticamente el corto plazo (lo que el modelo de una imagen puede hacer en una semana) y al mismo tiempo subestiman el progreso a largo plazo (lo que parece que está muy lejos de cumplirse). Es un patrón que vemos en el lenguaje con LLM y ahora en video, imágenes y juegos. Se nos olvida lo rápido que lo imposible se vuelve inevitable.

La economía del pixel

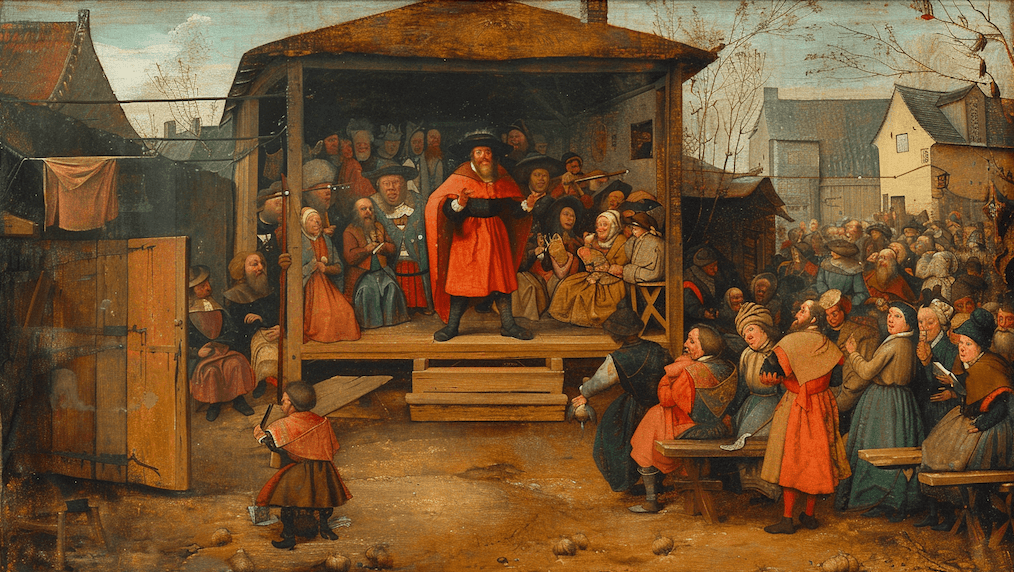

Runway crea tecnología que crea pixeles. Así que, una gran parte de mi tiempo la gasto con empresas que están en la industria de crear y vender pixeles. Pixeles que se mueven en una pantalla grande o chica. Crear pixeles en movimiento que te entretienen y te enseñan algo. Yo personalmente amo los pixeles. Estudios de películas, agencias de publicidad, desarrolladores de videojuegos, empresas de redes sociales, creadores independientes, instituciones educacionales y prácticamente cualquier persona que crea videos e imágenes, están en el negocio de crear y vender pixeles, y deberían poner atención sobre cómo se están creando ahora y en el futuro.

La economía del pixel no trata solo sobre la creación de contenido, más bien tiene que ver con toda la infraestructura donde esos pixeles se generan, distribuyen, consumen y son monetizados.

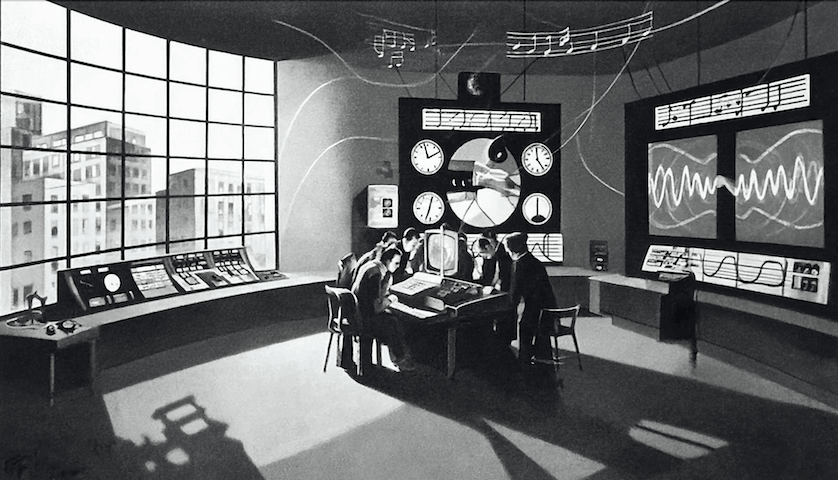

Hoy día la economía de los pixeles está construida sobre la escasez: cámaras caras, software especializado, equipos de editores, granjas de renders y networks de distribución. Cada paso requiere mucho capital y expertiz. Esta escasez crea valor, pero también arma barreras. En este mundo, los creadores son los que lideran estos sistemas.

La generación de contenido con IA está colapsando completamente estas barreras. El valor de crear pixeles está teniendo una tendencia hacia cero. Cuando cualquiera puede generar cualquier cosa visual sin software o equipo especializado, las economías se dan vuelta. El valor pasa de la ejecución técnica a la visión creativa, de la capacidad de producción al alcance de la distribución, de hacer píxeles a hacer píxeles que valgan la pena. Para todos los que son parte de la economía de los pixeles. No solo Hollywood. En este mundo, los creadores son los que pueden entender la colaboración humana + IA. Eventualmente, esto va a llevar a la convergencia de segundos consumidos y segundos generados. Ahora, hay mucho más contenido que se consume que el que se produce. Millones de personas pueden ver un solo video de Youtube, pero solo una persona (o un equipo chico) lo hizo. El ratio de consumo-creación está altamente desequilibrado hacia el consumo. A medida que los modelos de IA se vuelvan más sofisticados, la generación de contenido pasará a ser hecha en tiempo real, lo que quiere decir que las personas podrán crear contenido tan rápido como lo consumen. En vez de pasar una hora viendo videos que alguien más hizo, podrás pasar esa misma hora viendo videos de IA personalizados, historias, juegos o entretenimiento creados especialmente según tus gustos. Eventualmente, los segundos que se gasten consumiendo contenido serán prácticamente los mismos que los segundos que se gastaron para crearlos.

Tus queridas herramientas y sistemas para crear pixeles no funcionarán en el futuro. Este nuevo mundo probablemente requerirá que dejes atrás casi todo lo que has usado hasta ahora para crear y distribuir pixeles. Tu stack de software actual, tus flujos de trabajo ya establecidos, todo tu modelo mental sobre cómo los medios se crean. No estamos renderizando pixeles, los estamos generando. Estamos abandonando la idea de que la forma en que siempre has creado pixeles es la forma que siempre se crearán (puedes leer más sobre las consecuencias culturales, económicas y sociales de este cambio, acá)

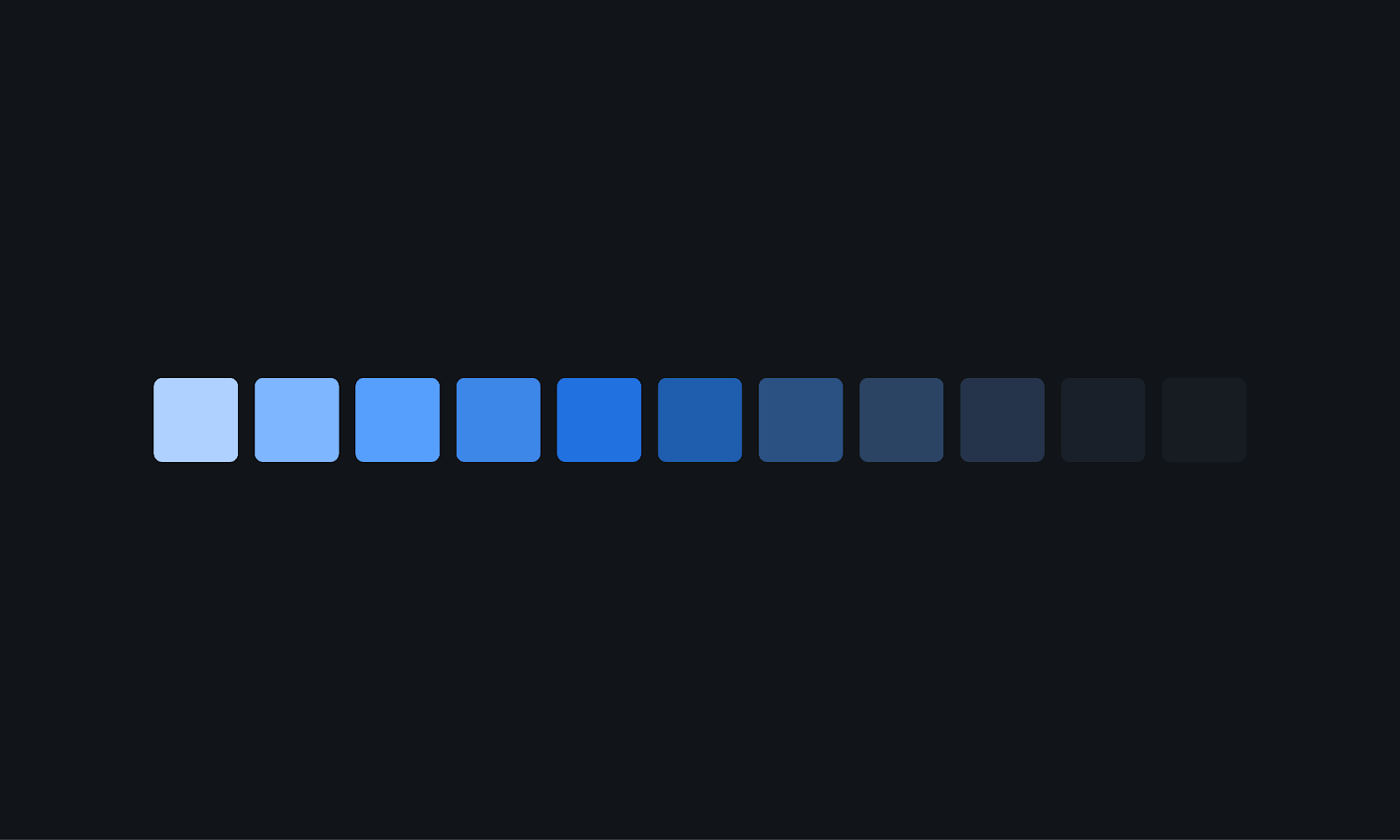

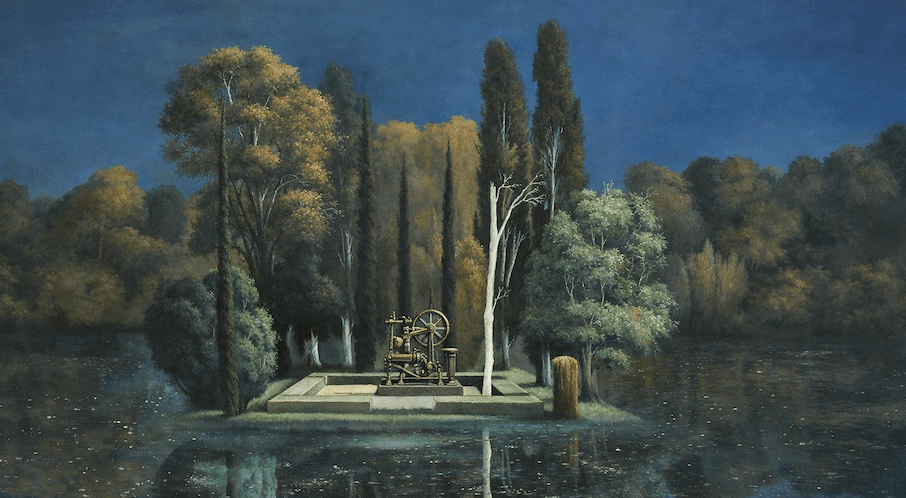

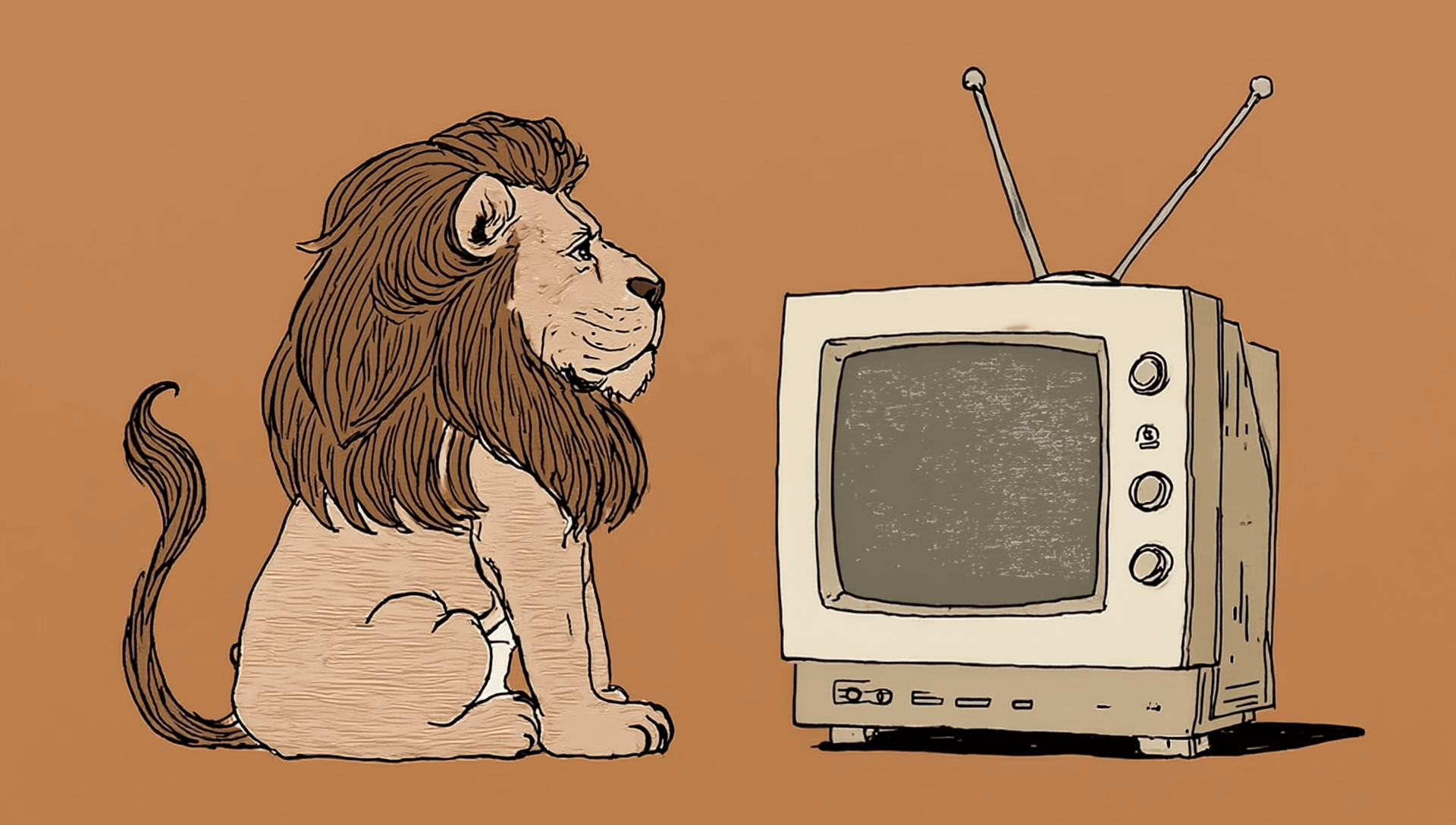

Esta es la gran y única trampa en la que caen los que están en la economía del pixel. Estancarse en el óptimo local. Mirar la línea azul por mucho tiempo. Considerar que la forma en que tú has creado y consumido pixeles será siempre la única manera por default. No lo será. Pon atención a la línea verde.

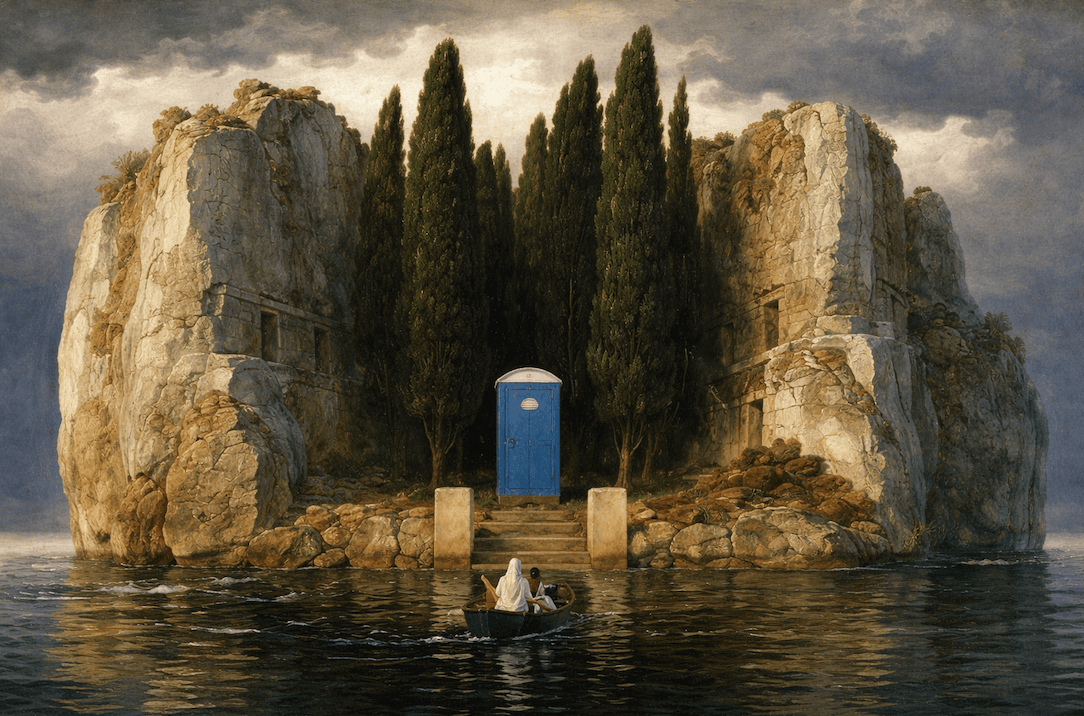

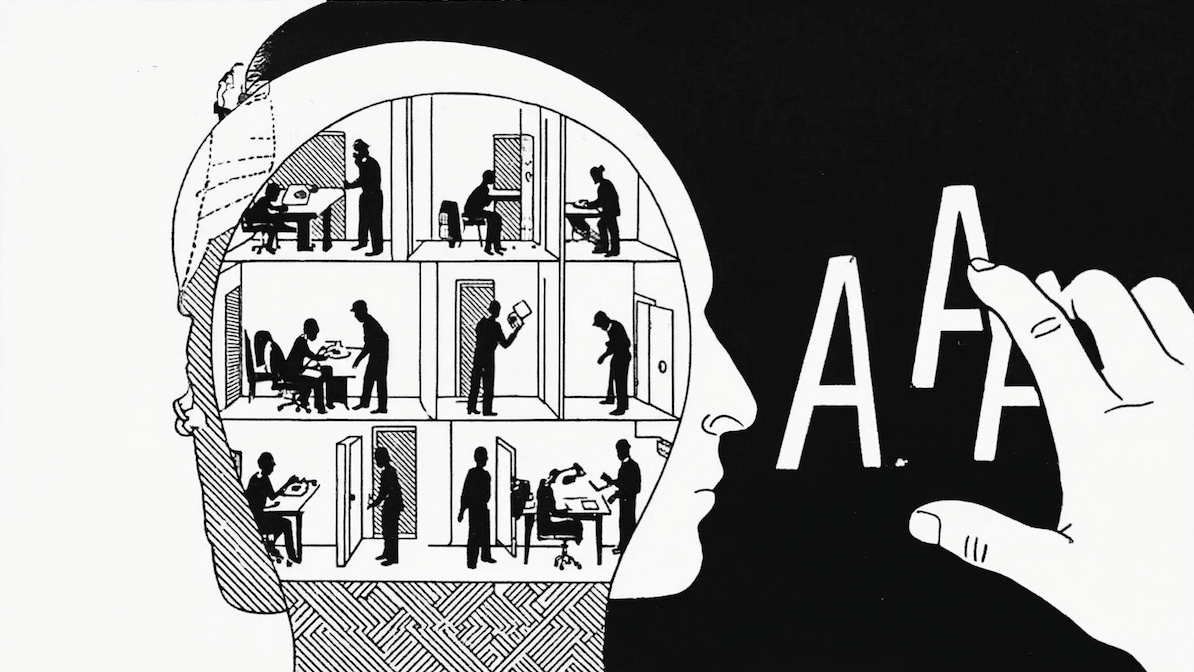

Considera una tarea no-generativa simple: segmentación de pixeles. La primera aproximación era manual. Capas, máscaras y herramientas especializadas en Photoshop. Una recreación digital de las técnicas de la sala oscura. La segunda aproximación fueron plugins de IA. O un progreso incremental potenciado por IA. Esto era lo que ofrecía Runway en 2019 para potenciar flujos de trabajos, haciendo que fueran más rápidos, pero sin cambiarlos fundamentalmente. Hacer esto en el 2025 es editar con un solo paso usando lenguaje. No se necesita Interfaz Gráfica. Solo describe qué quieres. No hay capas, no hay máscaras, no hay jerarquías de herramientas complejas.

Usuarios de Photoshop veían los Plugins de IA como herramientas útiles, no como amenazas existenciales. Pero desde la perspectiva del usuario, cada herramienta era reimaginar completamente lo que era posible. La distancia entre intención y ejecución colapsó. El camino más corto al output gana. Siempre. (El mismo patrón se repite en arquitectura, juegos y cualquier otro dominio creativo).

Productos con interfaces complejas que requieren invertir tiempo para manejarlas, o Interfaces Gráficas con demasiados botones, menús, toggles y opciones, ya representan una desventaja porque no se pueden ajustar a la aproximación de lograr resultados con un solo intento.

Están estancados en la línea azul local. Por defecto, los productos tienden a meter más botones. Mi apuesta actual es que prácticamente la mitad de empresas públicas de software no van a sobrevivir en los próximos 5 años, por esta trampa de la línea azul. Y no estoy solo en esta afirmación. El lugar hacia el que nos dirigimos no requiere que aprendamos una interfaz. La interfaz se adapta a tus necesidades. La economía del pixel se está moviendo desde “aprende de nuestras herramientas” hacia “dinos lo que quieres”.

Products with extensive/rich UIs lots of sliders, switches, menus, with no scripting support, and built on opaque, custom, binary formats are ngmi in the era of heavy human+AI collaboration.

— Andrej Karpathy (@karpathy) June 4, 2025

If an LLM can't read the underlying representations and manipulate them and all of the…

Hay un matiz en este argumento. Por supuesto. Todo esto es válido dependiendo de lo que crees que es verdad y qué tan optimista eres sobre el progreso actual de la IA. Al final vas a hacer distintas apuestas, dependiendo de lo que realmente crees sobre esta convergencia entre productos e investigación, y qué tan rápido está acelerando.

Si crees que la generación de medios va a seguir siendo un área especializada, vas a tender hacia el óptimo local. La línea azul. Mejores versiones de lo que ya existe. “IA Incremental”. Los workflows complejos te harán sentir una comodidad familiar por mientras. Si crees que crear contenido de medios se convertirá en una interfaz fundamental de la interacción humano‑máquina, vas a optimizar hacia la velocidad, la naturalidad y las capacidades emergentes. El óptimo global. Nuevas formas de crear y distribuir píxeles. Una nueva economía del pixel. La línea verde.

Yo optimizo para la línea verde.

[1] La generación de medios con IA abarca cualquier forma de creación de contenido donde los sistemas de inteligencia artificial producen experiencias multimedia consumibles. Esto incluye formatos lineales tradicionales como películas, anuncios y contenido de video, pero se extiende mucho más allá, a formatos multimedia interactivos y adaptativos.

En esencia, hablamos de modelos que pueden generar experiencias audiovisuales tanto de forma lineal (películas que se desarrollan de principio a fin) como no lineales (juegos, mundos virtuales y entornos responsivos que se adaptan a la interacción del usuario). Sin embargo, esta definición se está expandiendo rápidamente.

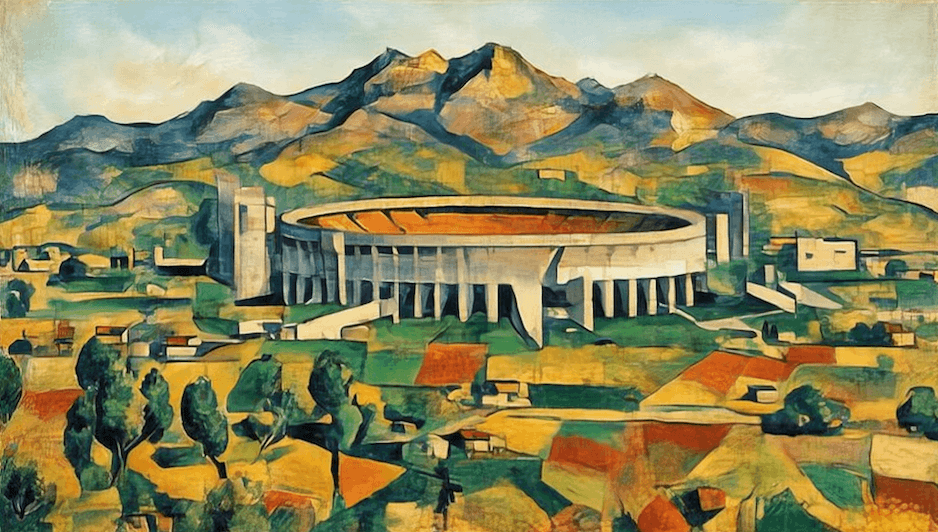

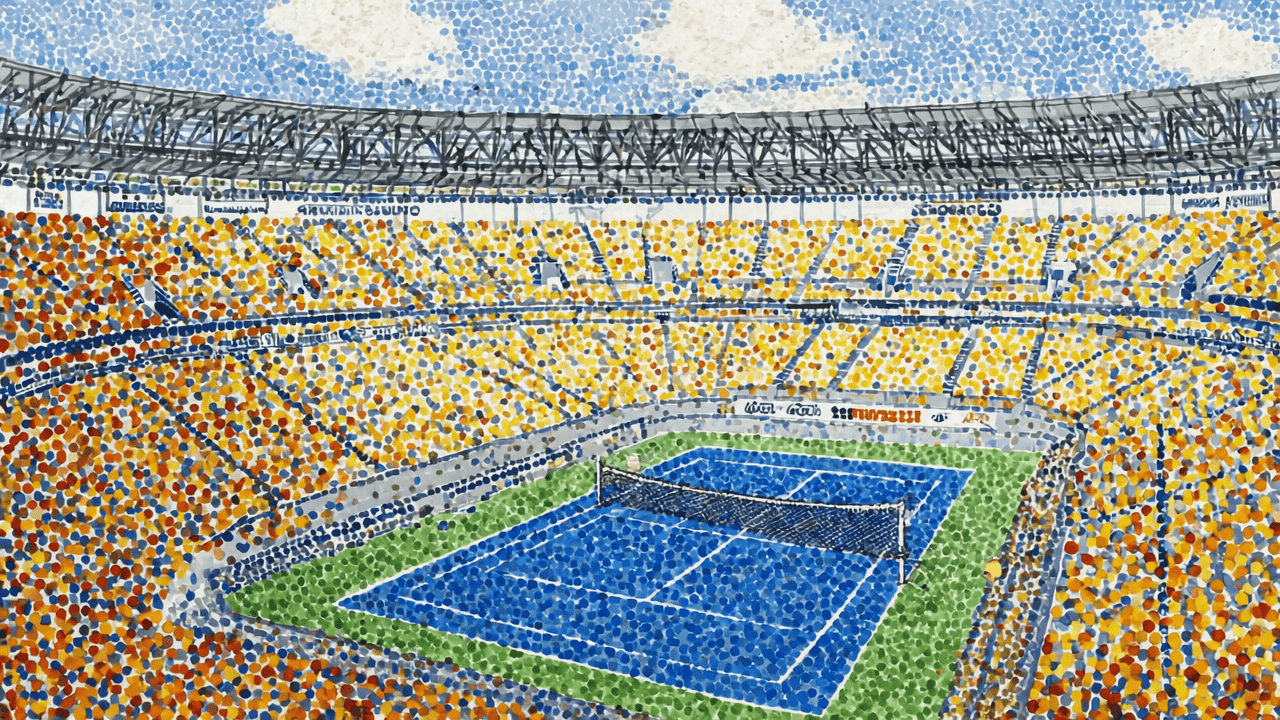

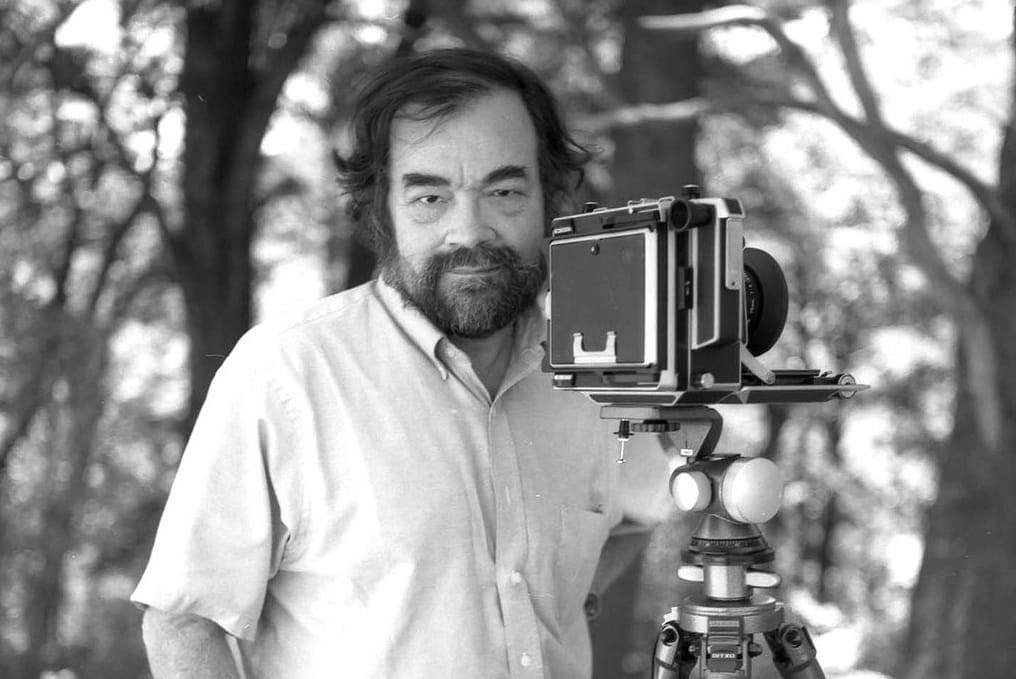

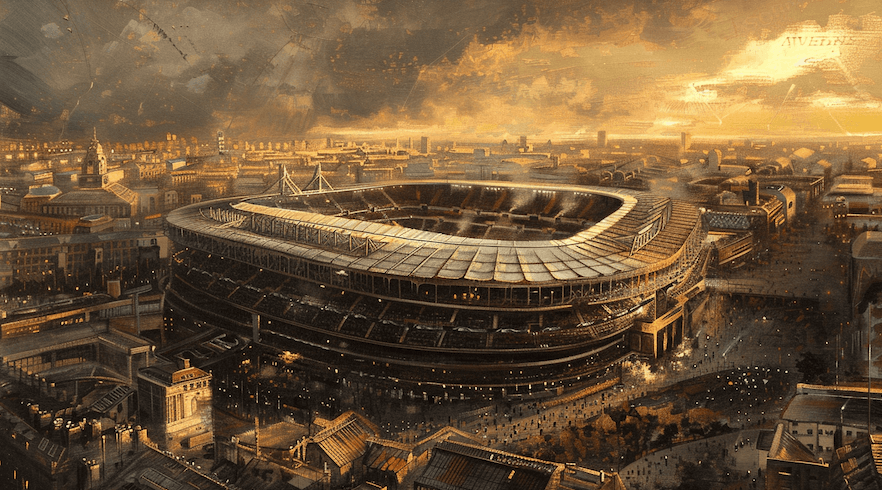

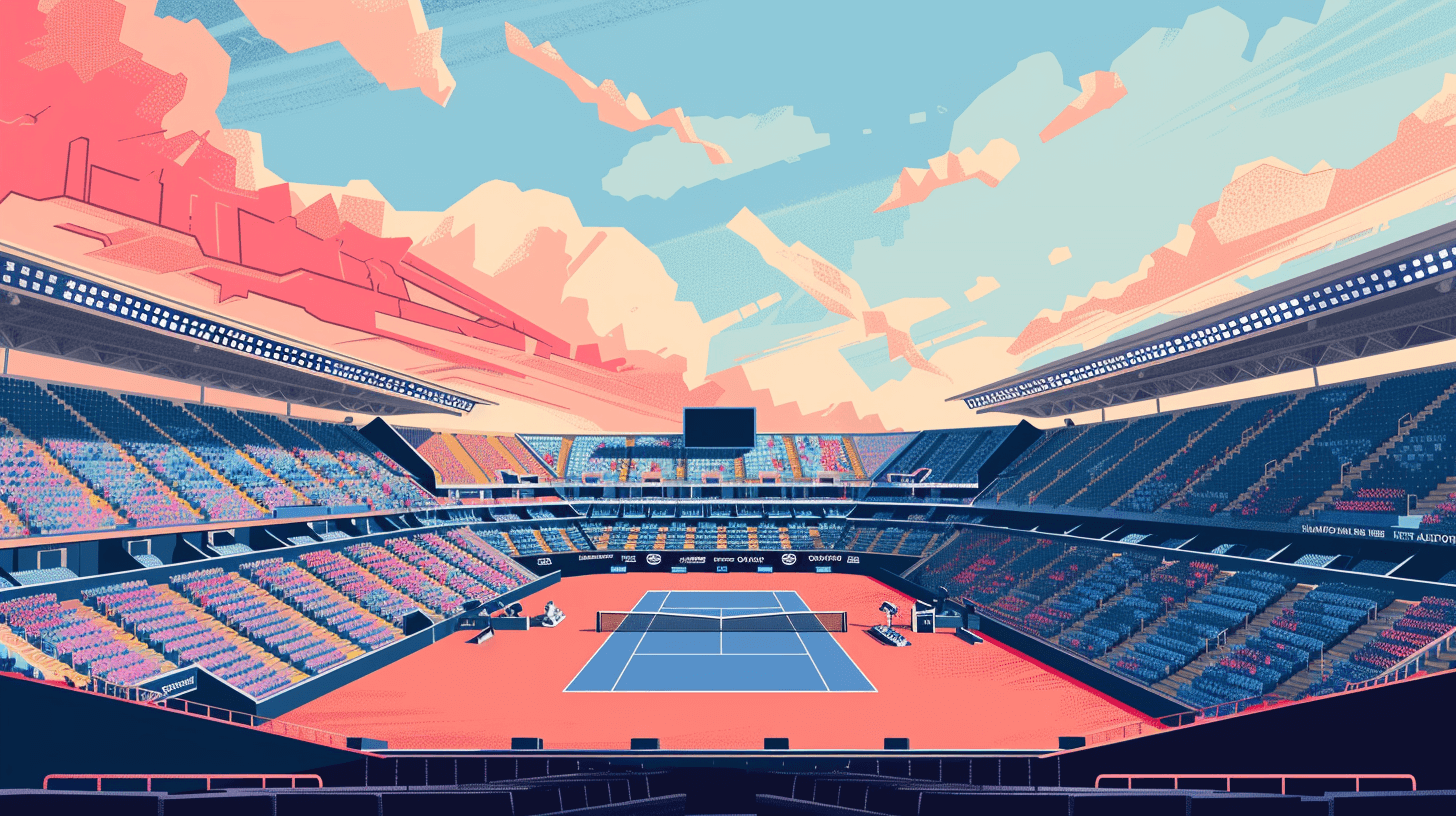

Nota de los Editores: este ensayo de Cristóbal Valenzuela salió originalmente acá y nos autorizó traducirlo. Decidimos publicarlo ahora porque agarra un peso especial con el nuevo lanzamiento que Runway hizo ayer, 28 de julio: Aleph es una herramienta para hacer ediciones sutiles en videos existentes. Por ejemplo, si grabaste un video en un estadio vacío, puedes pedirle a Runway que el ponga público, o que le cambie la iluminación a una toma, o incluso el ángulo de la cámara. Pero queda mejor en las palabras de Cristóbal: