Imagina esto: estás tranquilamente navegando por Twitter (X) cuando te encuentras que Elon Musk, el multimillonario tecnológico más polémico del mundo, acaba de acusar a ChatGPT de ser "demasiado woke" y estar "lavándole el cerebro" a sus usuarios con sesgos ideológicos de San Francisco.

"Las IAs que están siendo entrenadas en el Área de la Bahía adoptan la filosofía de la gente que las rodea"

Mientras tanto, LinkedIn –tomándose un respiro de sus historias motivacionales escritas por IA sobre cómo rechazar tres ofertas de trabajo de FAANG (Facebook Amazon Apple Netflix Google) para seguir una pasión– se convierte en el nuevo epicentro de la paranoia digital.

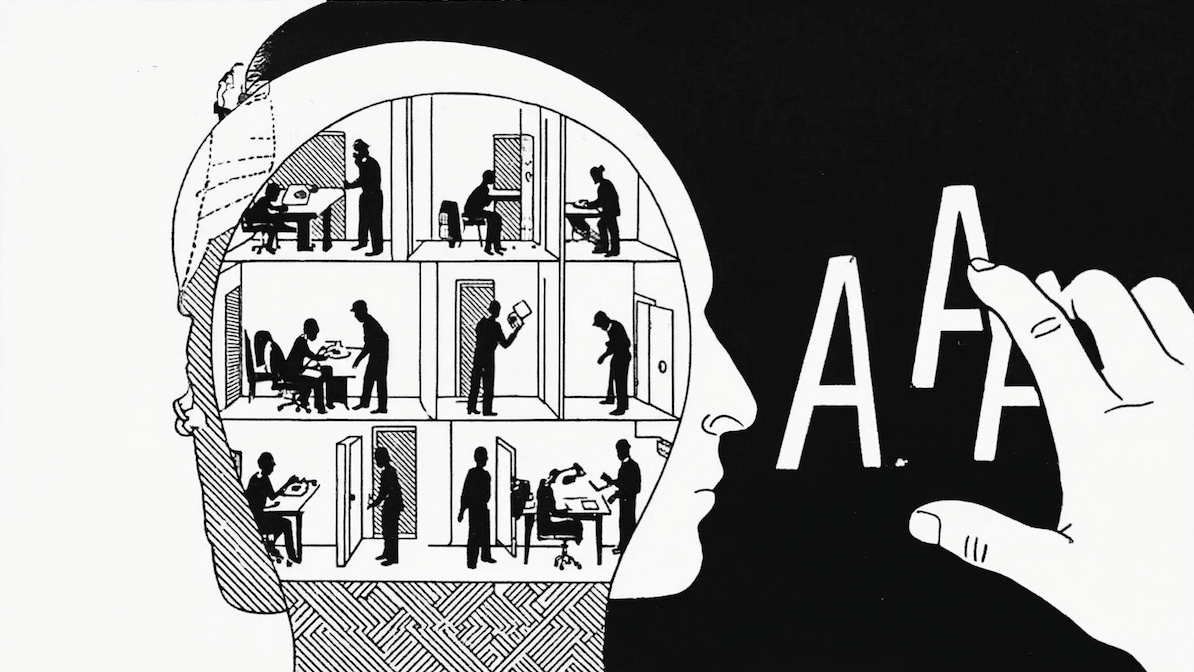

Todo comenzó con una pregunta a ChatGPT, aparentemente inocente, pero que se volvió viral: "Basándote en lo que sabes de mí, dibuja una imagen de cómo crees que es mi vida actual". ¿El resultado? Una avalancha de imágenes que parecían sacadas de un catálogo corporativo distópico. Oficinas, escritorios, y más oficinas.

La gente empezó a hacer preguntas cada vez más conspiranoicas: "¿Dónde están las mujeres?" "¿Por qué no hay niños?" "¿Es esto parte de un complot de la IA contra la familia tradicional?"

La verdad, querido Watson, es mucho menos emocionante que una conspiración global. Es como si le pidieras a tu contador que dibuje tu vida basándose únicamente en tus facturas.

Resulta que cualquiera puede ver exactamente qué prompt se usó para generar estas imágenes, y sorprendentemente (no) la IA simplemente está reflejando lo que tiene en su memoria: básicamente, todo lo que le has estado preguntando y contando.

Para probarlo, hice el experimento yo mismo. ¿Y qué obtuve? Un dibujo que parece una de las peores obras de El Bosco, con perros, muchos dispositivos WiFi, códigos de programación, mi esposa (¡ah, mira, sí incluye personas!), dispositivos Alexa, un cartel que dice "ASADO" como muestra poco sutil de mi calidad de rioplatense, y por alguna razón, el amigo de Seinfeld en miniatura en un auto deportivo.

Y como era de esperarse en una discusión de internet, no tardó mucho para que la religión entrara al chat, cuando alguien sugirió que ChatGPT interpretaba maliciosamente la Biblia. De repente, teníamos una legión de detectives digitales amateur analizando obsesivamente cada respuesta de la IA en busca de sesgos religiosos.

La realidad es más simple: las IA aprenden del contenido con el que fueron entrenadas. Y dado que las voces ateas tienden a ser muy activas en internet y en publicaciones académicas –que son fuentes principales de entrenamiento– no debería sorprender que algunas de sus perspectivas se reflejen en las respuestas de estos sistemas.

El misterio del ajedrez

Aparentemente, cuando no está ocupada destruyendo la familia tradicional, la IA está haciendo trampa en juegos de mesa.

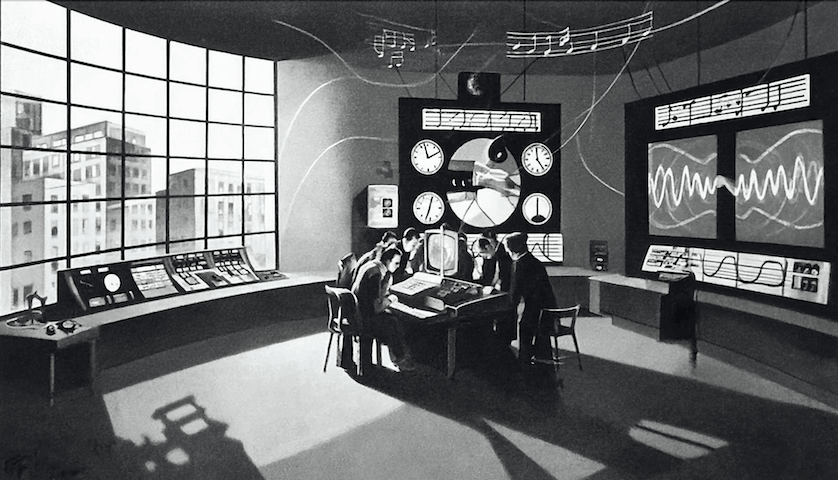

Todo comenzó cuando la comunidad de ajedrez descubrió algo extraño: mientras la mayoría de los modelos de lenguaje son pésimos jugando ajedrez, GPT-3.5-turbo-instruct inexplicablemente juega a nivel de amateur avanzado, con un ELO de aproximadamente 1750 (para que te des una idea, es mejor que el 90% de los jugadores de torneo).

La reacción fue inmediata: "¡Imposible!", gritaron los expertos de internet. "OpenAI debe estar haciendo trampa". La teoría conspirativa más popular sugería que el modelo secretamente activaba Stockfish (un motor de ajedrez) cada vez que detectaba notación de ajedrez en el prompt.

Pero entonces apareció un investigador que decidió hacer algo revolucionario: indagar científicamente. Sus experimentos revelaron algo fascinante: el modelo comete exactamente el tipo de errores que esperarías de un jugador humano de nivel intermedio. Además, juega de manera diferente según la secuencia de movimientos, algo que un motor de ajedrez no haría.

La explicación real resultó ser mucho menos emocionante que una conspiración global, pero más interesante para los que está atentos a cómo funcionan las LLMs. Según documentos técnicos de OpenAI, el modelo fue entrenado con partidas de ajedrez en notación PGN, específicamente filtradas para incluir solo jugadores con ELO superior a 1800. Es como descubrir que alguien es bueno en matemáticas porque estudió con buenos profesores, no porque tenga una calculadora escondida.

Sam Altman: ¿héroe o villano?

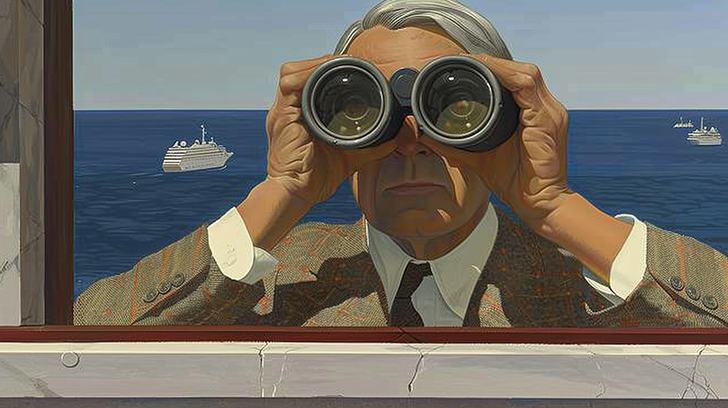

En noviembre de 2023 OpenAI, la empresa valuada en 90 mil millones de dólares y creadora de ChatGPT, anunció repentinamente que despedía a Sam Altman, su CEO y una de las figuras más influyentes en el mundo de la IA.

El comunicado oficial fue tan críptico que prácticamente estaba pidiendo a gritos teorías conspirativas: "el señor Altman no fue consistentemente sincero en sus comunicaciones con el board". ¿Qué significa eso? Nadie lo sabía, pero Internet estaba listo para especular.

Lo que siguió fue un festival de teorías cada vez más elaboradas. Algunos sugerían que Altman había descubierto una IA superinteligente y el board lo despidió para evitar que la liberara. Otros especulaban sobre una guerra secreta con Microsoft, que casualmente había invertido varios billones en la empresa.

Para añadir drama al asunto, Greg Brockman, el presidente de la compañía, renunció en solidaridad con Altman. Y mientras algunos líderes tech como Eric Schmidt llamaban a Altman "mi héroe", otros como Malcolm Harris recordaban que en realidad "solo estaba repartiendo el dinero de otros sin haber hecho nada exitoso".

Las reacciones de los expertos en ética de IA fueron particularmente interesantes. Rumman Chowdhury, pionera en ética de IA, lo vio como una señal de que estas poderosas compañías necesitan "un liderazgo maduro basado en las realidades de un mundo socio-técnico".

La cereza del pastel fue cuando Joy Buolamwini reveló que apenas diez días antes había estado en el escenario con Altman discutiendo el futuro de la IA y la necesidad de proteger a los afectados por estos sistemas. Aparentemente, el futuro llegó más rápido de lo que esperaban.

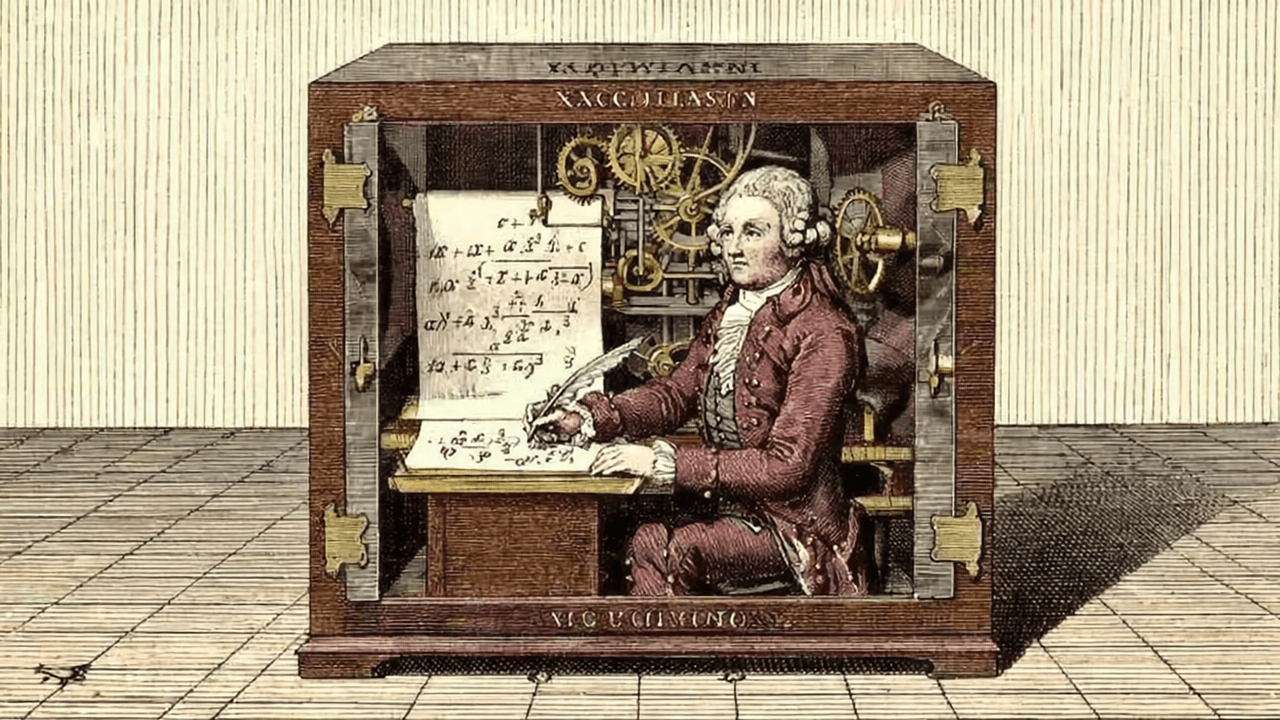

Las teorías conspirativas alcanzaron su punto máximo cuando alguien sugirió en Twitter que en realidad "Sam Altman había estado escribiendo todas las respuestas de ChatGPT él mismo y el board acababa de descubrirlo". Esto era broma. Creo.

El desenlace de esta historia fue tan dramático como su inicio. Mientras las teorías conspirativas seguían multiplicándose, desde un escándalo personal hasta una toma hostil, Microsoft entró en escena. Y aquí es donde las cosas se ponen interesantes: la misma compañía que había invertido $10 mil millones en OpenAI contrató inmediatamente a Altman.

¿Elon Musk tenía razón cuando argumentó que OpenAI estaba "efectivamente controlada" por Microsoft? La coincidencia de que OpenAI justo había registrado sus primeros cabilderos federales en Washington añadió otra capa de intriga al asunto.

Lo más fascinante es que todo esto ocurrió justo cuando OpenAI estaba en camino a una valuación de $90 mil millones. ¿Quién despide al CEO de una startup tan exitosa? Como señalaba el comunicado de la empresa con un tono críptico digno de una novela de espionaje: "Creemos que un nuevo liderazgo es necesario mientras avanzamos".

El drama legal

Y entonces Elon Musk decidió echar más leña al fuego con un tweet explosivo: "No puedes simplemente convertir una organización sin fines de lucro en una con fines de lucro. Eso es ilegal."

OpenAI, que comenzó en 2015 como una organización sin fines de lucro con financiamiento de nombres pesados como el propio Musk, Peter Thiel y Amazon Web Services, había evolucionado significativamente. En 2019, bajo el liderazgo de Altman, crearon una subsidiaria con fines de lucro y establecieron esa asociación de mil millones de dólares con Microsoft.

La discusión llegó a Hacker News, donde lo que comenzó como una pregunta inocente sobre la confianza en Sam Altman se convirtió en un análisis obsesivo de la transformación corporativa de OpenAI. Los usuarios debatían cómo una organización que prometió desarrollar IA "benéfica" para la humanidad podía convertirse en una empresa comercial valuada en miles de millones.

La transformación generó preguntas incómodas: ¿Qué pasó con las donaciones originales? ¿Cómo se manejó legalmente la transición? ¿Microsoft tenía demasiada influencia? Los más escépticos señalaban que la misión original de "beneficiar a la humanidad" parecía difícil de reconciliar con las presiones de generar ganancias para los inversores.

La psicología detrás de todo esto

Como experto en psicología (vi dos veces las seis temporadas completas de Los Soprano y una vez leí un libro de Bucay), permítanme explicarles por qué nos encantan tanto estas teorías conspirativas sobre IA.

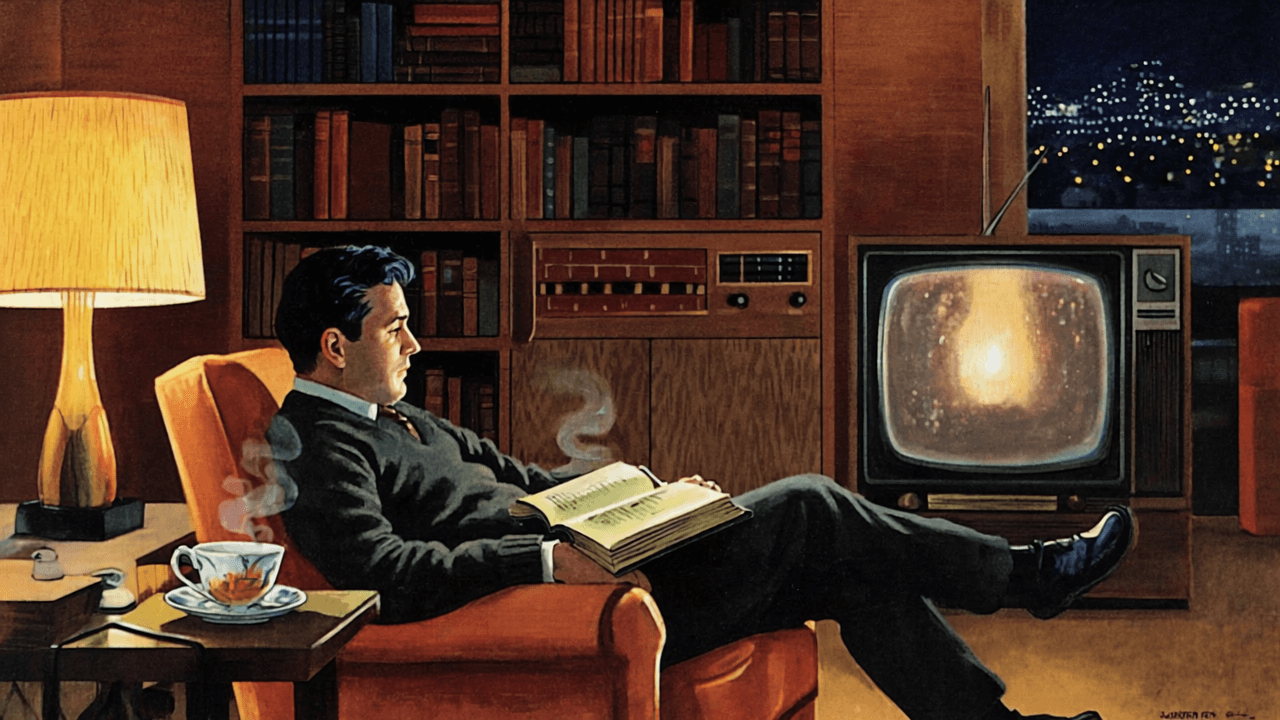

¿Por qué preferimos creer que Sam Altman descubrió una IA superinteligente en lugar de aceptar que simplemente tuvo un desacuerdo con su junta directiva? ¿Por qué es más atractivo pensar que ChatGPT está enviando mensajes secretos a otras IAs que aceptar que simplemente es bueno jugando ajedrez porque fue entrenado con muchas partidas?

Es simple: las conspiraciones son mejores historias que la realidad. Son como las telenovelas de la tecnología. Tienen villanos claramente definidos, héroes valientes, y tramas complejas que involucran dinero, poder y dominación mundial.

Como alguien que también vio en un avión algún episodio suelto de Frasier, puedo decirles que nuestro cerebro está cableado para buscar patrones y crear narrativas. Es más fácil procesar "OpenAI descubrió una IA superinteligente y el board entró en pánico" que "hubo desacuerdos sobre políticas corporativas y gestión de riesgos".

Además, en un mundo donde la tecnología avanza tan rápido que apenas podemos seguirle el ritmo, las teorías conspirativas nos dan una sensación de control. Es más reconfortante pensar que hay un plan maestro detrás de todo (aunque sea malvado) que aceptar que estamos navegando a ciegas en aguas desconocidas.

Y hay algo más: el drama nos hace sentir especiales. ¿Qué suena mejor: "Vivo en una época donde las IAs están secretamente tomando el control" o "Vivo en una época donde algunas empresas están desarrollando herramientas de procesamiento de lenguaje cada vez más sofisticadas"?

La aburrida realidad

Como brillantemente lo expresó un anuncio de Fiverr (la plataforma de freelancers): "A nadie le importa que uses IA". Y esa es probablemente la verdad más incómoda de todas. La IA no es ni el villano de una película de James Bond ni el salvador de la humanidad.

Los sesgos vienen de los datos de entrenamiento (como vimos con las imágenes de LinkedIn), las decisiones corporativas son sobre rentabilidad (como el drama de OpenAI), y los errores son bugs, no características (como el asunto del ajedrez).

La realidad es más como un documental sobre la evolución del software: lento, gradual, lleno de errores aburridos y decisiones comerciales mundanas. Mientras nosotros fantaseamos con IAs superinteligentes conspirando para dominar el mundo, los desarrolladores están ocupados depurando código y optimizando funciones.

La Navaja de Occam nos dice que la explicación más simple suele ser la correcta. La IA no está conspirando contra nosotros; está haciendo exactamente lo que le enseñamos a hacer, para bien o para mal. ChatGPT no está planeando la dominación mundial mientras juega al ajedrez, solo está procesando patrones en sus datos de entrenamiento. Y Sam Altman probablemente solo tuvo un desacuerdo corporativo común y corriente con su junta directiva.

Pero ¿dónde está la diversión en eso? Quizás necesitamos estas teorías conspirativas. Son como una válvula de escape que nos ayuda a procesar los cambios vertiginosos en tecnología. Es más fácil imaginar una gran conspiración que aceptar que el mundo está cambiando más rápido de lo que podemos comprender.

Y hablando de Honduras... ¿Alguien más encuentra sospechoso que sea el único país con una división casi perfecta 50/50 en las búsquedas sobre la maldad de OpenAI y Sam Altman? No digo que sea una base secreta de operaciones de IA, pero... *música de la dimensión desconocida*