William A., como se le conoce en documentos de la Corte de Apelaciones de Estados Unidos, se graduó de la secundaria con un promedio de 8,5/10 sin saber leer ni escribir, salvo algunas frases rudimentarias. Utilizando un cóctel de herramientas de inteligencia artificial —entre ellas ChatGPT y Grammarly— William, diagnosticado con dislexia, acabó delegando todas sus tareas bajo la escasa supervisión de los tutores que se le asignaron para que superara sus barreras.

¿William simplemente usó la IA como un aliado al igual que muchos de nosotros o hizo algo incorrecto al delegar su trabajo a otras herramientas?

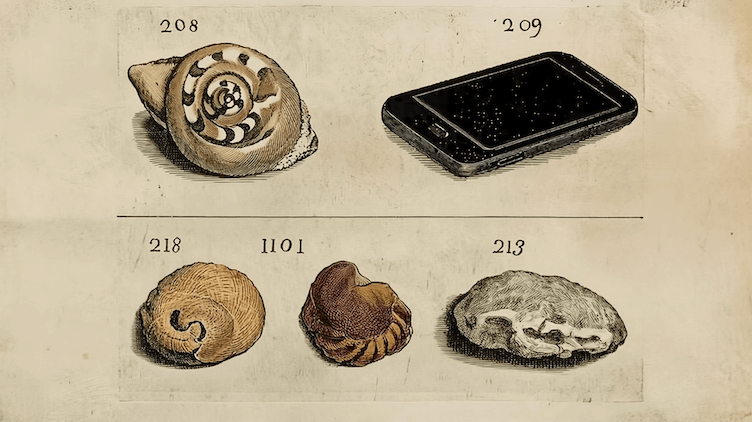

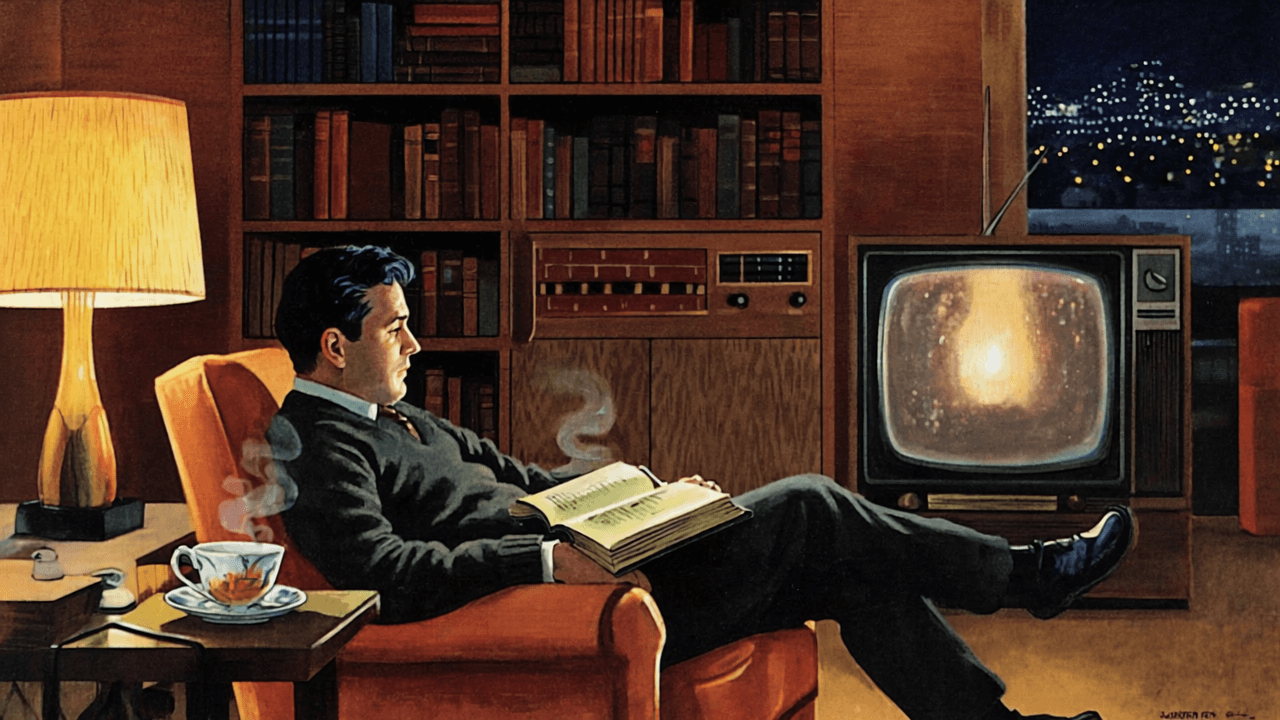

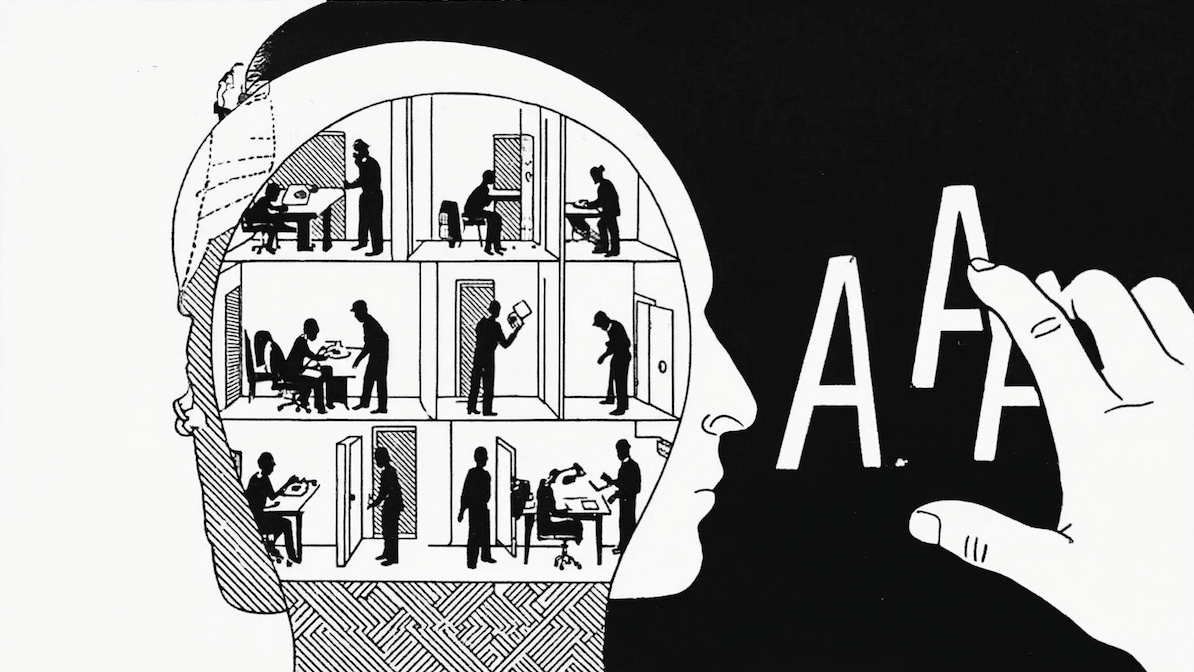

Diariamente nuestros procesos cognitivos son aumentados por herramientas tecnológicas que hemos ido incorporando en la historia. Consideremos algo simple como un calendario: nos permite descargar información desde nuestra mente para no tener que almacenarla y así no tener que pensar continuamente en qué tenemos que hacer en el futuro. Podemos dejar esa información en el calendario y consultarla cuando lo necesitemos.

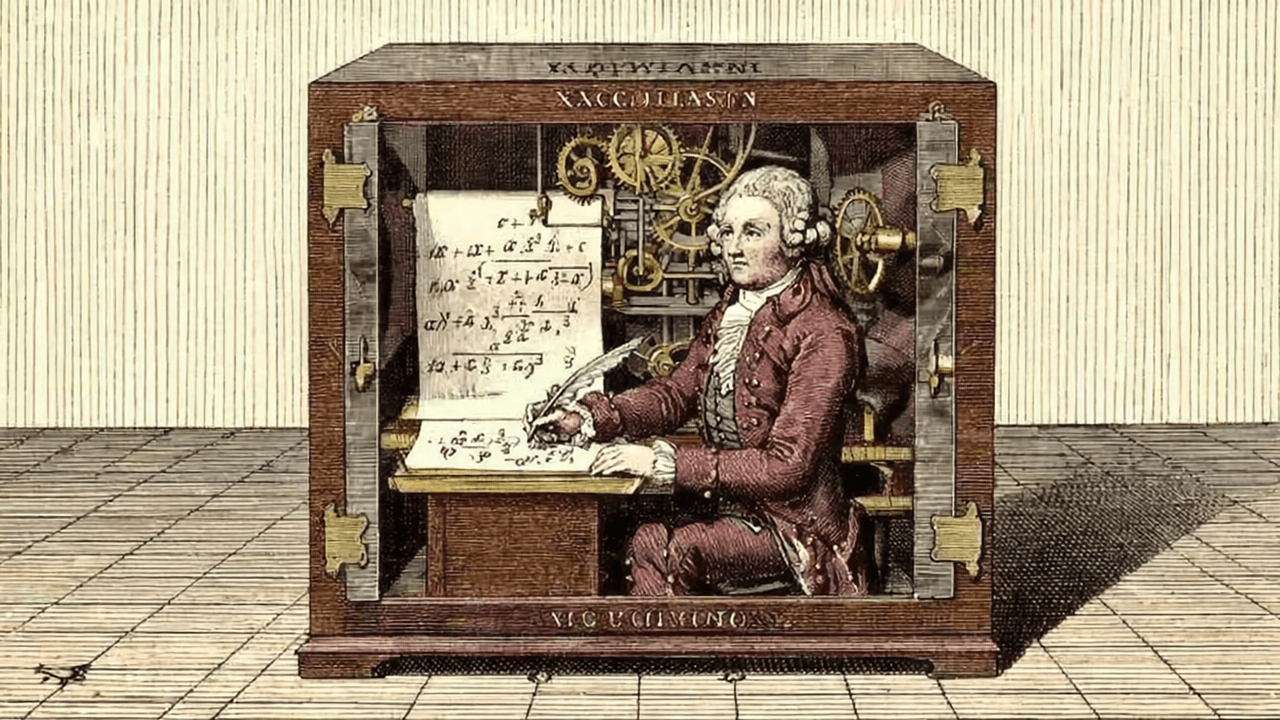

Para entender mejor si el caso de William es más parecido al calendario o hizo trampa, podemos recordar un famoso problema filosófico conocido como “El cuarto chino”.

Propuesto por John Searle en 1980, un filósofo estadounidense que falleció recientemente, va más o menos así:

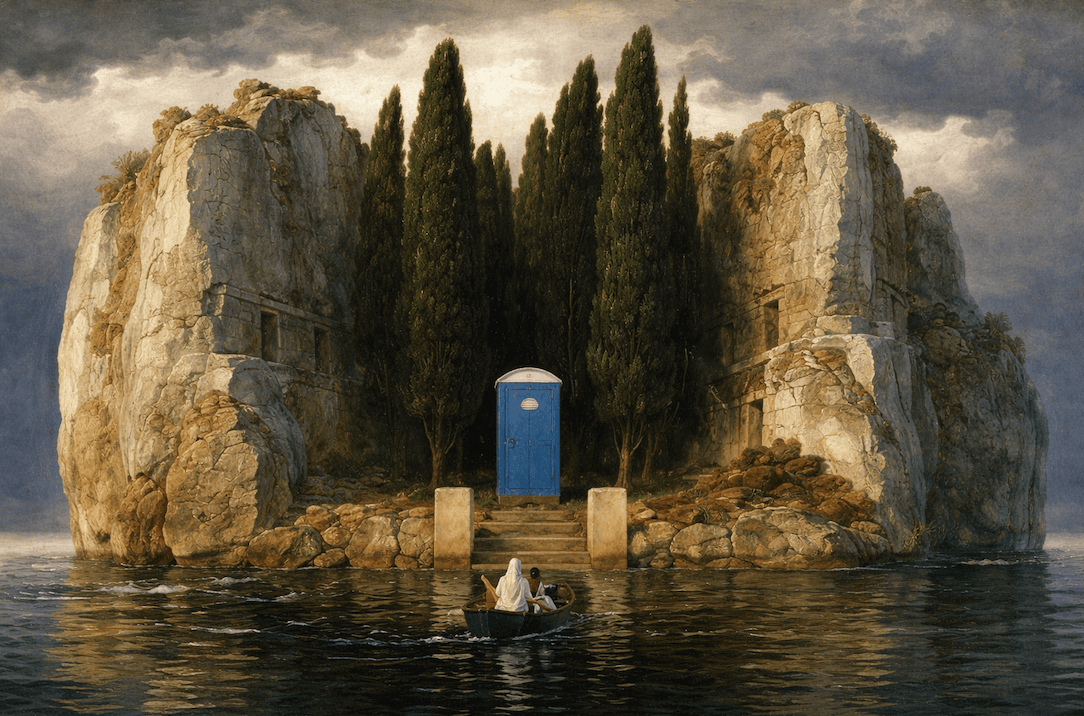

Imagina que hay una persona que no sabe nada de chino aislada en un cuarto. Esta persona recibe mensajes en chino a través de la puerta y después sigue instrucciones detalladas en un manual para escribir la respuesta ideal, dando la impresión desde afuera que dentro del cuarto hay alguien que entiende chino a la perfección.

Volveremos a Searle, pero antes tenemos que visitar un problema aún más antiguo: el Test de Turing.

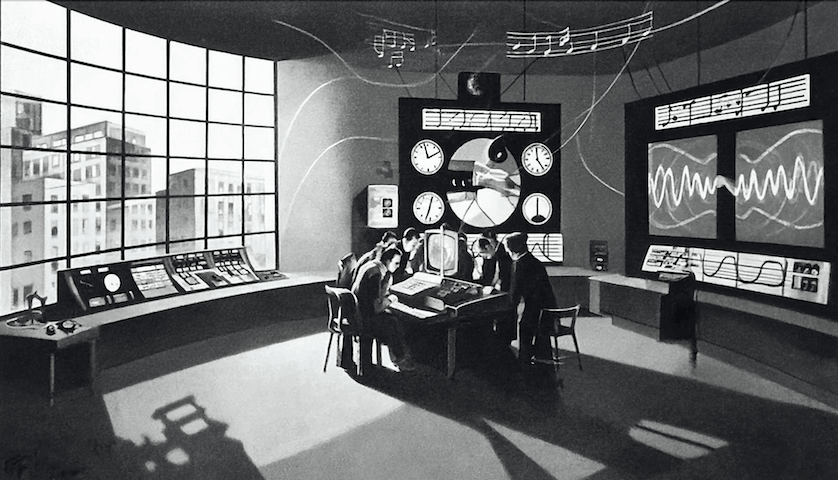

El Test de Turing

Alan Turing, considerado uno de los padres de la ciencia de la computación y la inteligencia artificial, propuso en 1950 una alternativa a la pregunta de si las máquinas pueden pensar. Dándose cuenta de que uno puede argumentar durante años sobre qué significan las palabras “máquina” o “pensar”, planteó el siguiente ejercicio, originalmente llamado “El juego de la imitación”: imagina que un evaluador externo tiene que leer la transcripción de una conversación llevada a cabo entre una persona y una computadora. Si el evaluador es incapaz de identificar quién es quién, podríamos decir que, en términos prácticos, la máquina es capaz de pensar.

Turing creía que para el 2000 el juego de la imitación ya iba a ser superado y que sería natural hablar de máquinas pensantes. Aunque tomó un poco más de tiempo, en general ya dejó de ser descabellado atribuir inteligencia a un computador según sus parámetros.

El test de Turing pone sobre la mesa una visión “funcional” de la inteligencia, en donde podríamos considerar que basta con parecer ser inteligente para ser considerado inteligente. En palabras de Denis Diderot, filósofo francés autor de la primera enciclopedia: “si se encuentra un loro que puede responder a todo, se le consideraría un ser inteligente sin duda alguna”.

Entonces, por un lado tenemos a Turing y a Diderot, quienes creen que parecer ser inteligente es suficiente. Y por el otro, tenemos a Searle, quien propone el argumento del cuarto chino precisamente en como una crítica a la inteligencia artificial.

Así que volvamos al cuarto chino.

El cuarto chino

Según la Enciclopedia de filosofía de Stanford, Searle propuso en 1980 el argumento del cuarto chino como una crítica a la teoría de la “Inteligencia Artificial Fuerte” (Strong AI), que postula que programas computacionales entienden el lenguaje natural y poseen capacidades mentales similares a las de los humanos cuyo comportamiento intentan imitar.

Searle argumentaba que programas de ese estilo pueden dominar la sintaxis pero no la semántica, es decir, que pueden expresarse a la perfección sin entender qué están diciendo, al igual que la persona dentro del cuarto chino o incluso el mismo William A., mencionado previamente, quien hacía en términos prácticos de puente entre sus tareas y la Inteligencia Artificial.

¿Quién tiene la razón?

No requiere mucho esfuerzo ponerse del lado de Searle en un inicio. Aunque muchas veces logramos tener una conversación aparentemente razonable con ChatGPT, todos nos hemos frustrado porque se vuelve repetitivo o alucina con frecuencia. En estos momentos nos parece imposible que realmente entienda. Pero consideremos que el argumento de Searle fue planteado en 1980, época donde los programas eran un manual de instrucciones que un computador seguía paso a paso, tal como en el cuarto Chino.

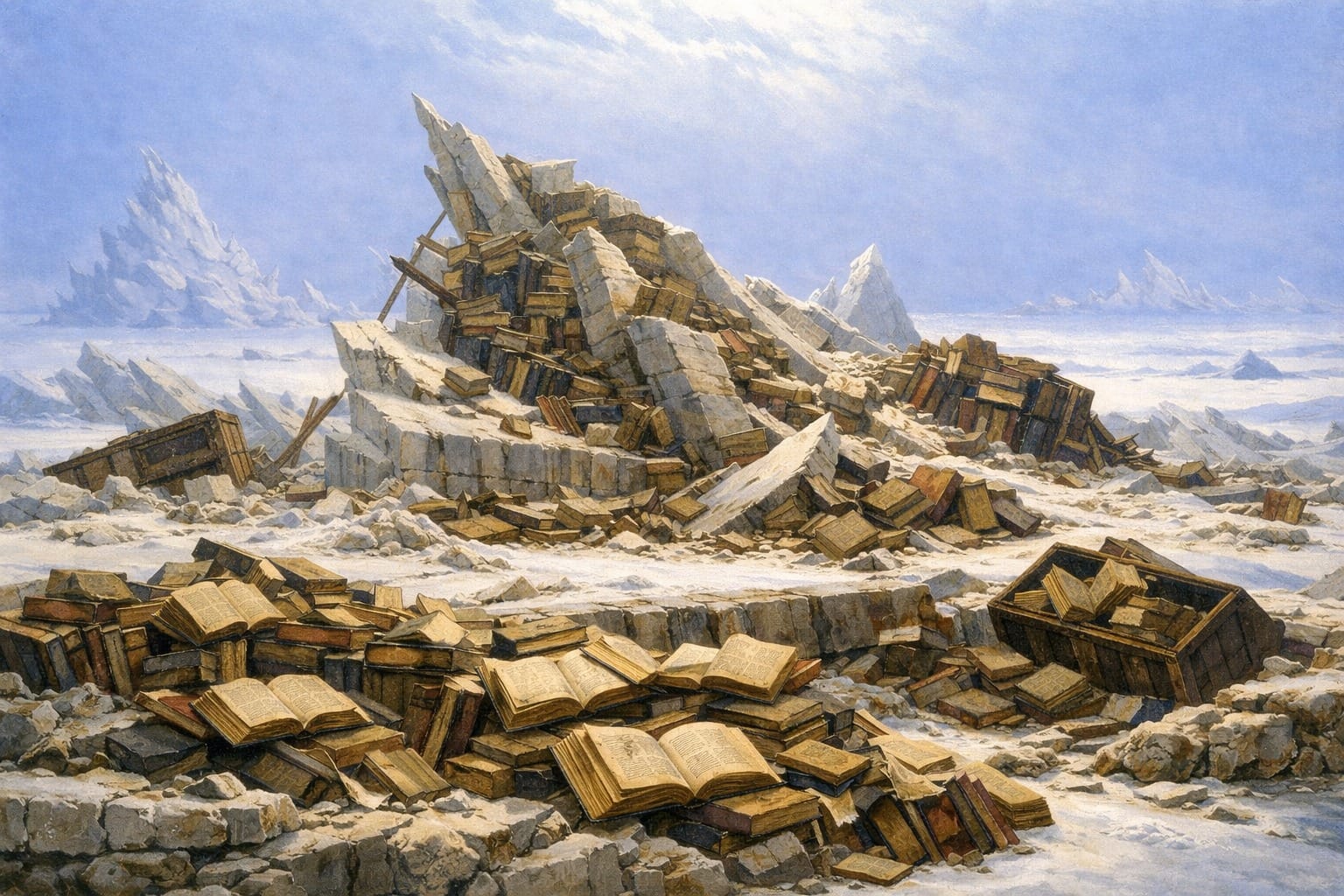

Hoy, en cambio, no es tan directa la analogía: LLMs como ChatGPT no fueron construidos a partir de instrucciones precisas de qué responder ante cada prompt posible. Lamentablemente no existe el libro de instrucciones de ChatGPT, donde podamos ir a revisar por qué cree que Alejandro Zambra ganó un premio que no existe.

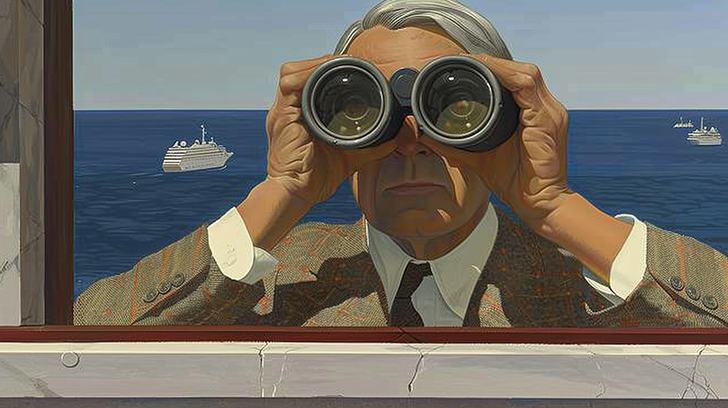

¿No es a veces sorprendente la precisión con la que ChatGPT o programas similares responden? ¿Como si supieran exactamente lo que estamos buscando? ¿De qué recursos podríamos valernos para descartar algo así como meramente “resultados algorítmicos”? Intentar argumentar que no hay inteligencia ahí se vuelve más complicado.

Por impresionante que parezca, la IA también es sorprendentemente tonta sacada fuera del ámbito en que fue entrenada. Cuando pusieron a los mejores LLM’s (Large Language Models, como ChatGPT, Claude o Gemini) a jugar ajedrez, estos jugaban terriblemente, proponiendo movimientos ilegales o rindiéndose sin razón, alucinando a toda máquina, mientras que incluso niños de 4 años pueden entender las reglas principales (y a su vez, los mejores programas de ajedrez, como StockFish o Komodo, no pueden entender el lenguaje natural).

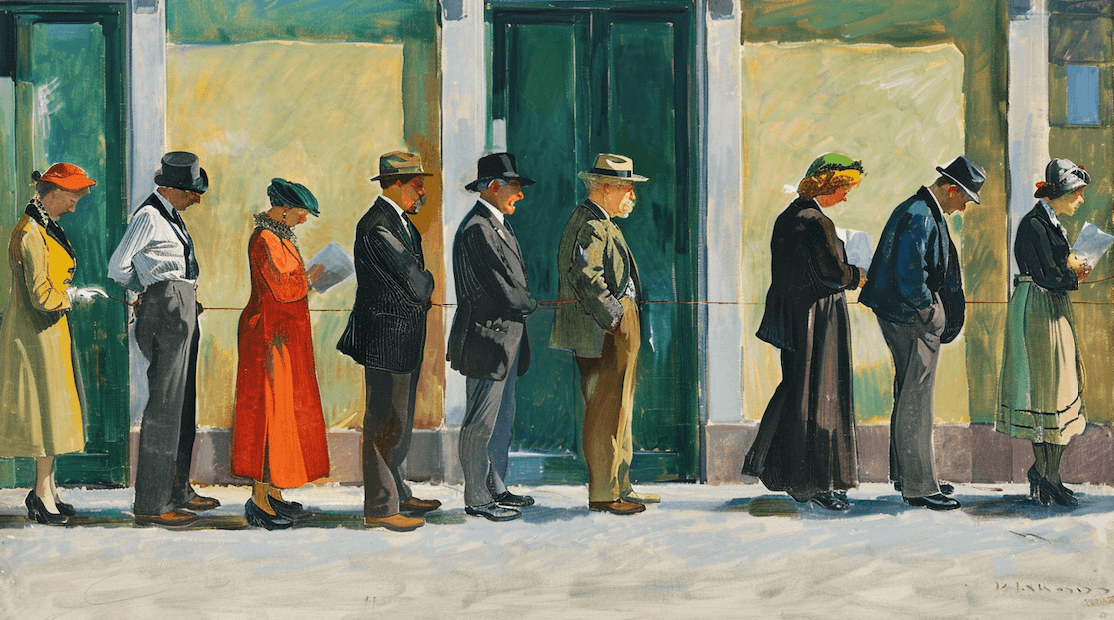

Volviendo a William, las cortes de Estados Unidos eventualmente determinaron que era necesario compensarlo con cientos de horas extra de tutoría. Aunque sus profesores no lograron distinguir que las tareas y evaluaciones eran creadas por una IA, él no aprendió. Podríamos decir que William hablaba chino con fluidez, pero sin entenderlo.

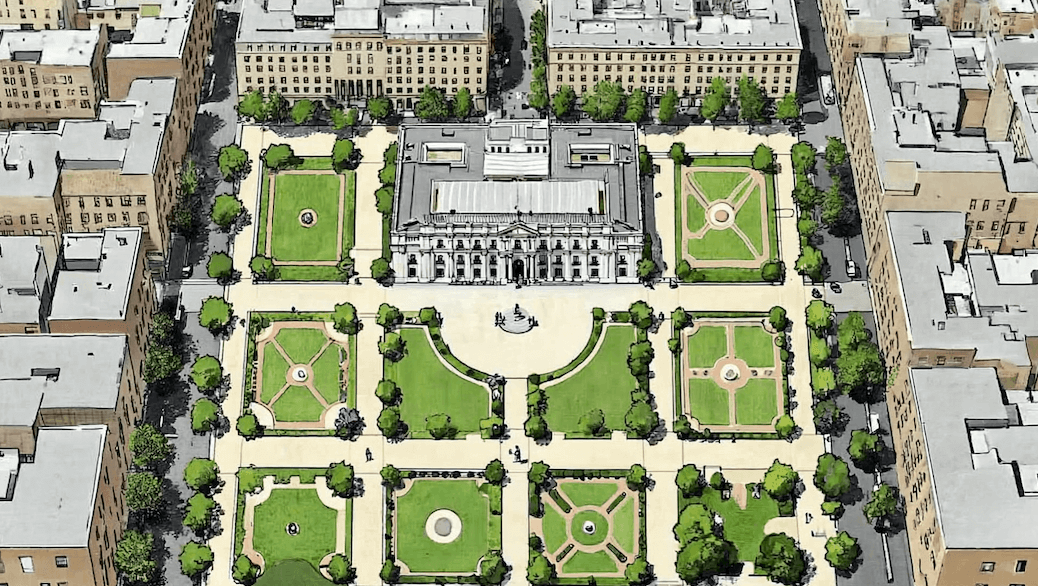

Sea cual sea el punto de vista que uno quiera adoptar, lo que es indiscutible es que el argumento del cuarto chino ilustra claramente la forma en que a veces nos valemos de la tecnología. Cuando manejamos y usamos Google Maps, por ejemplo, entramos en una especie de cuarto chino donde solamente seguimos indicaciones (sin que esto sea, por supuesto, algo necesariamente malo). En Fintual nos han llegado postulaciones a vacantes que tienen pegadas las características preguntas de LLM’s, como, ¿Te gustaría que enfatice algún aspecto en particular de tu CV para tu aplicación a Fintual?

En última instancia el propósito de los ejercicios filosóficos no es alcanzar una conclusión definitiva sino ayudarnos a repensar algo que tomamos por sentado. Sea cual sea el número y la forma que adopten los cuartos chinos que habitamos todos los días, el puro hecho de reconocerlos como tales nos ayuda, en cierto modo, a abrir la puerta. Que decidamos salir o no de ahí se vuelve, por supuesto, una cuestión aparte.