Para el común de los mortales, proyectar las condiciones meteorológicas del futuro inmediato es una mera comodidad. Nos ayuda a planificar qué día parrillamos con los amigotes o cuándo partimos a la playa, pero rara vez más que eso. Para ciertos engranajes económicos, por el contrario, es mucho lo que está en juego. Permite, por ejemplo, aumentar la generación de las centrales de embalse previo a las tormentas severas soltando más agua por las turbinas. Si no contáramos pronósticos y no supiéramos la que se nos viene encima, parte de esa agua se vertería sin pasar por las turbinas, despilfarrando energía limpia y a costo marginal cero. Sobre eso, se agravarían las inundaciones, porque esa entrega previa de agua extra libera volumen precioso en el embalse que permite contener parte de la crecida. De no ser por el efecto amortiguador de los embalses del centro sur y su aumento de disponibilidad en respuesta a los pronósticos, los ríos atmosféricos que azotaron la zona en junio y agosto del ‘23 habrían sido aún más catastróficos.

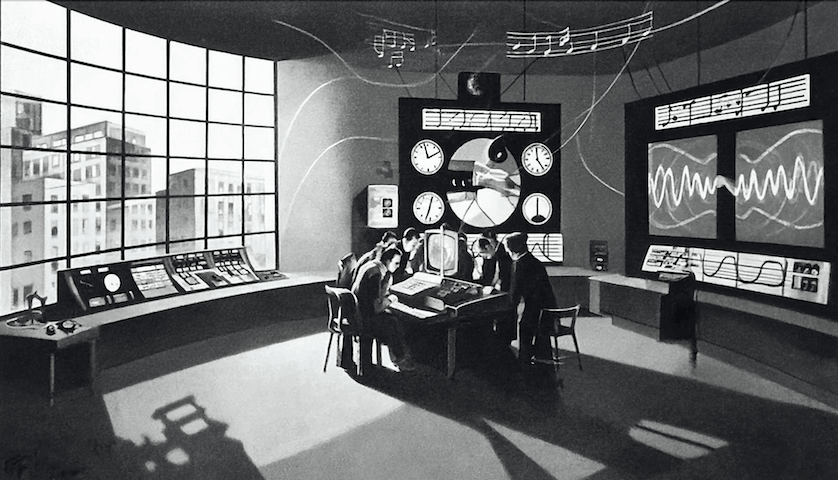

Atrás quedaron ya los años en que el pronóstico se hacía solo con interpretaciones visuales (y telefonazos al archipiélago Juan Fernández, la primitiva ventana al futuro de entonces, solo porque queda más al este y los sistemas frontales suelen moverse desde el suroeste hacia el noreste). Hoy el espacio ha sido colonizado por modelos computacionales que dividen el planeta en grillas, cual tablero de ajedrez, y procesan miles de variables. Entre más pequeños sean los cuadrantes de la grilla más nos acercamos a la caótica realidad microscópica, pero más cálculos hay que hacer. Por eso es que para tramitar estos asuntos se emplean algunos de los supercomputadores más potentes que haya conocido la humanidad.

Aunque hay varias familias de modelos, los principales son el Global Forecast System (GFS, alias “modelo gringo”) y el European Centre for Medium-Range Weather Forecasts (ECMWF, alias “modelo europeo”).

El GFS es el heredero del Modelo Espectral Global del Centro Meteorológico Nacional de EE.UU., creado en 1980. Hoy es administrado por la Administración Nacional Oceánica y Atmosférica (NOAA). Si alguna vez ha oído alguna proyección de Niño o Niña, es por la sarta de boyas, satélites y parafernalia meteorológica de este mastodonte científico. Son los contribuyentes estadounidenses quienes lo financian para beneficio de la humanidad toda (tal como ocurre con el GPS, en que cada uno paga 2,6 US$/año por aquella constelación satelital que los demás terrícolas aprovechamos gratis: ¡gracias cabros!). Hasta se pueden descargar los datos crudos en forma gratuita para masajearlos a gusto.

El ECMWF, a su turno, nació en 1985, y hoy es dirigido por una entidad intergubernamental independiente respaldada por 34 naciones europeas. Sobre este opera, por ejemplo, el popular servicio YR (“llovizna” en noruego).

Por supuesto, la precisión de los pronósticos se juega en varios productos: precipitación, temperatura, viento, humedad. Sin embargo, en adelante hablaremos solo de precipitaciones porque es donde hay más en juego y donde acontecen los errores más crasos.

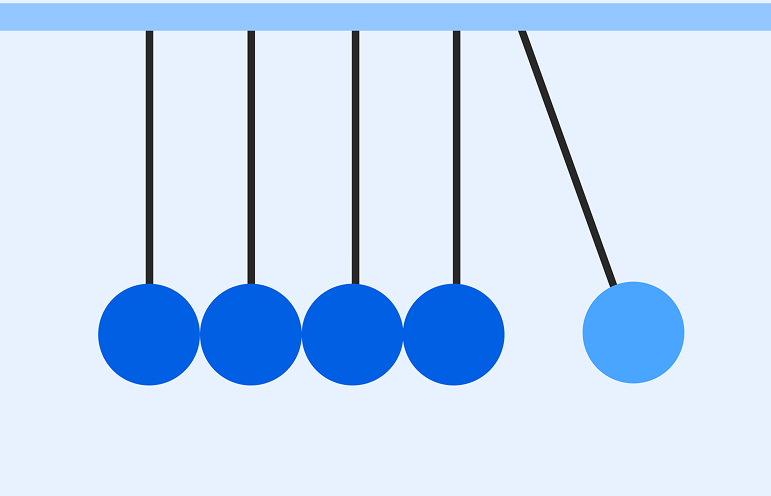

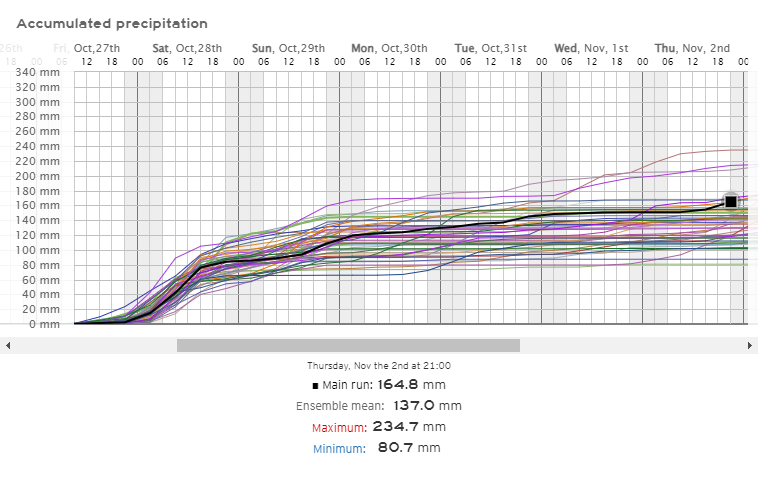

Pues bien, lo habitual es ejecutar un pronóstico principal (main run), de máxima exigencia de cálculo, y junto con ello un conjunto de pronósticos más livianos, cada uno con pequeñas variaciones en las condiciones iniciales. Esta multiplicidad pretende abordar los errores introducidos por el uso de condiciones iniciales imperfectas, amplificados por la naturaleza caótica de la evolución de la atmósfera y las imperfecciones en la formulación del modelo. La idea es que el estado atmosférico estará al menos dentro de la dispersión, y se puede además calcular el promedio de la serie de simulaciones (ensemble mean). Recordará del post acerca de la foto de Outlook que la teoría del caos nació por la asombrosa diferencia en un pronóstico meteorológico al ingresar como condición inicial 0,506 en lugar de 0,506127, origen del artículo ¿El aleteo de una mariposa en Brasil desencadena un tornado en Texas?

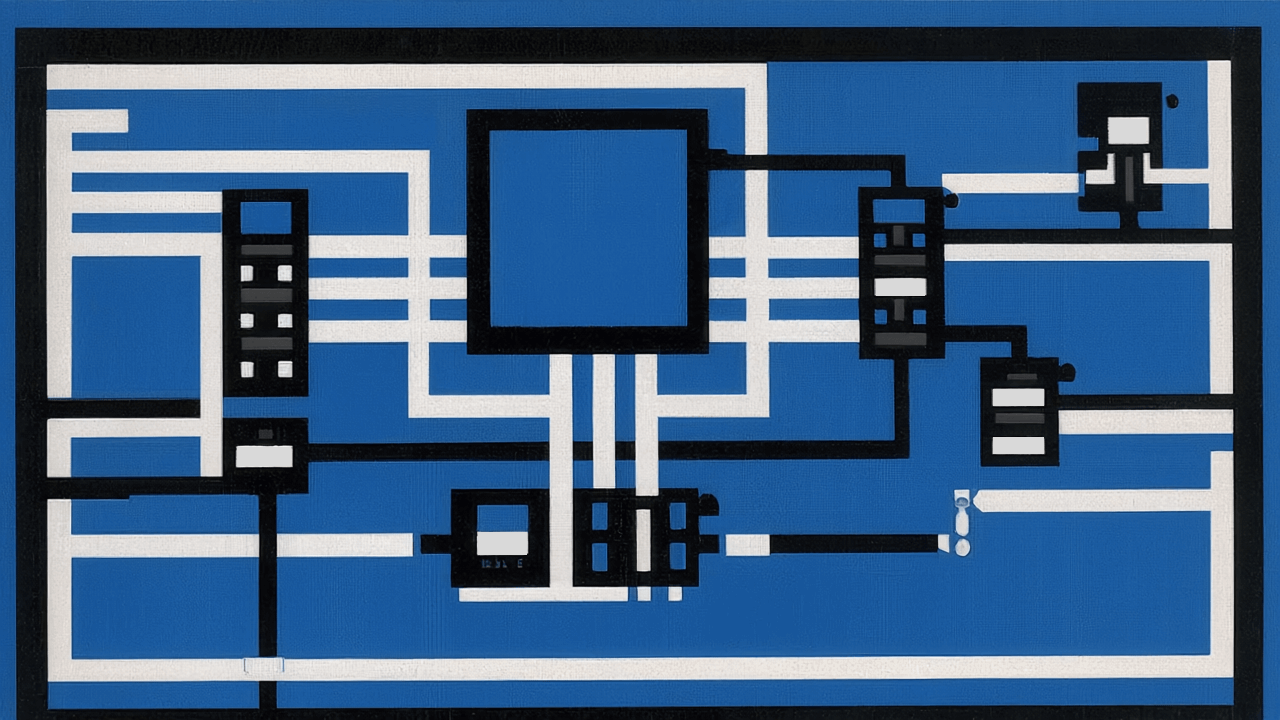

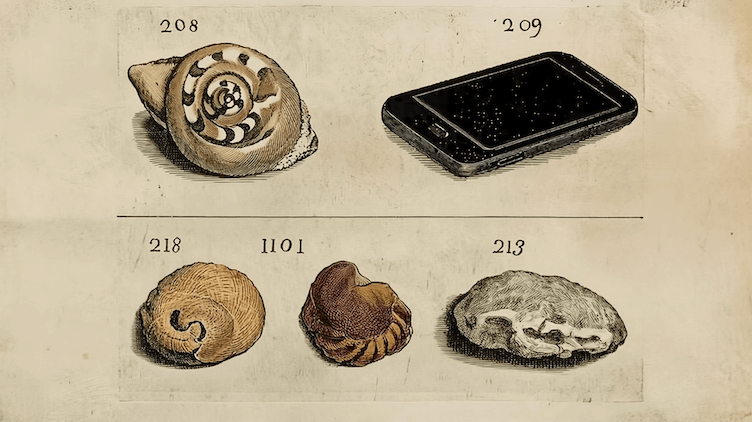

La imagen siguiente muestra la acumulación de precipitaciones según ECMWF para Lonquimay hasta el 2 de noviembre del ‘23 a las 21:00, según la corrida de la medianoche del 24 de octubre (aquí la corrida en el momento en que usted lea esto; guarde la URL si aspira a graduarse de la pobreza de las app por defecto de su teléfono para convertirse en un aficionado pro). El main run arroja 164,8 mm, y el ensemble mean (el promedio de todas las corridas secundarias) 137,0 mm. El rango va desde 80,7 a 234,7, lo que indica que casi casi con seguridad estará al menos dentro de ese rango.

Esto arroja el GFS

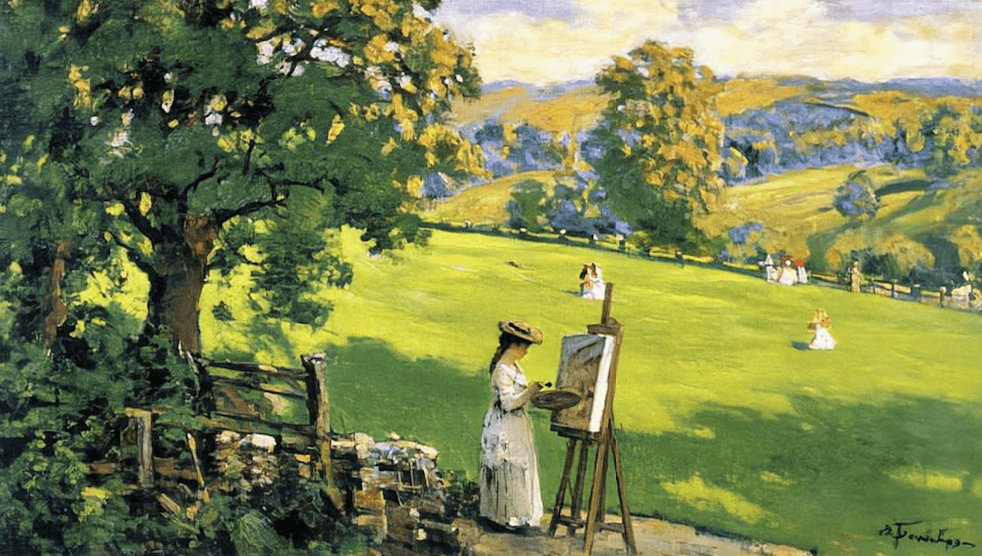

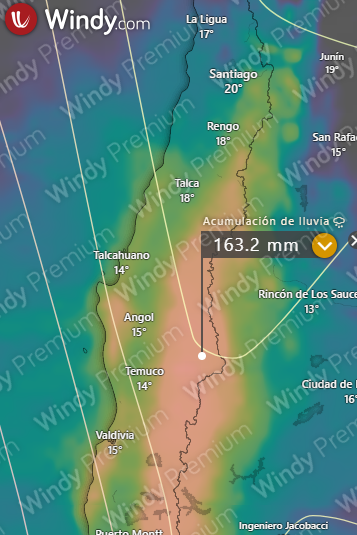

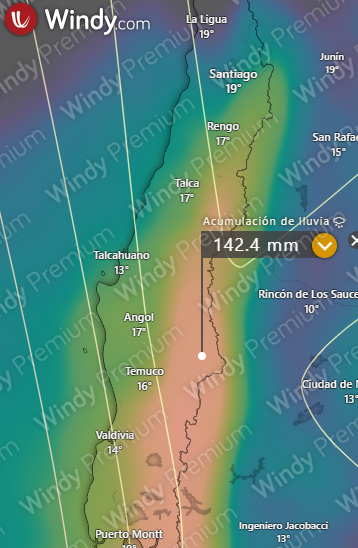

Eso es solo en un punto. Para apreciar una mirada espacial de cómo se espera que pegue esta tormenta en todo su rango de acción, no hay mejor visualizador que la precipitación acumulada en los siguiente diez días de Windy.

El europeo, con el pin en Lonquimay:

El gringo, con el pin en el mismo lugar:

No sabemos exactamente cuánto caerá, pero de que este sábado hay mambo, hay mambo.

Esta visualización permite apreciar que Santiago, dada su posición geográfica específica en la latitud 33,4, a menudo está muy cerca de la frontera norte de los sistemas frontales. Por eso con frecuencia a uno se le hincha el corazón con un pronóstico de diluvio y apenas horas después en el mismísimo servicio meteorológico aparece una garúa miserable. Suele ser que la trayectoria del frente se mueve unos pocos kilómetros hacia el sur, y no que el frente mismo se chingue (aunque eso también puede ocurrir, desde luego).

¿De dónde viene toda esta magia?

Desde agosto del ‘23 GFS utiliza como base dos supercomputadoras gemelas, una en Virginia y otra en Arizona, que ofrecen la friolera de 14,5 petaflops por segundo cada una, o 29 en total. Es decir, juntas procesan 29.000.000.000.000.000 cálculos por segundo. A esto se suman supercomputadoras de la NOAA en Virginia Occidental, Tennessee, Mississippi y Colorado, que suman otros 20 petaflops. Así, la predicción se sustenta en un conjunto de 49 petaflops. Para que se haga una idea, si esto fuera un solo supercomputador sería, a octubre del ‘23, el 12° más potente del mundo

Los europeos, por su lado, instalaron su bestia en Bolonia, y anda por los 30 petaflops, el 16° más poderoso que usted pueda encontrar. Es el tipo de hardware que demanda procesar datos de alrededor de 90 instrumentos satelitales y de otro tipo, que escupen 800 millones de observaciones y 300 terabytes cada día.

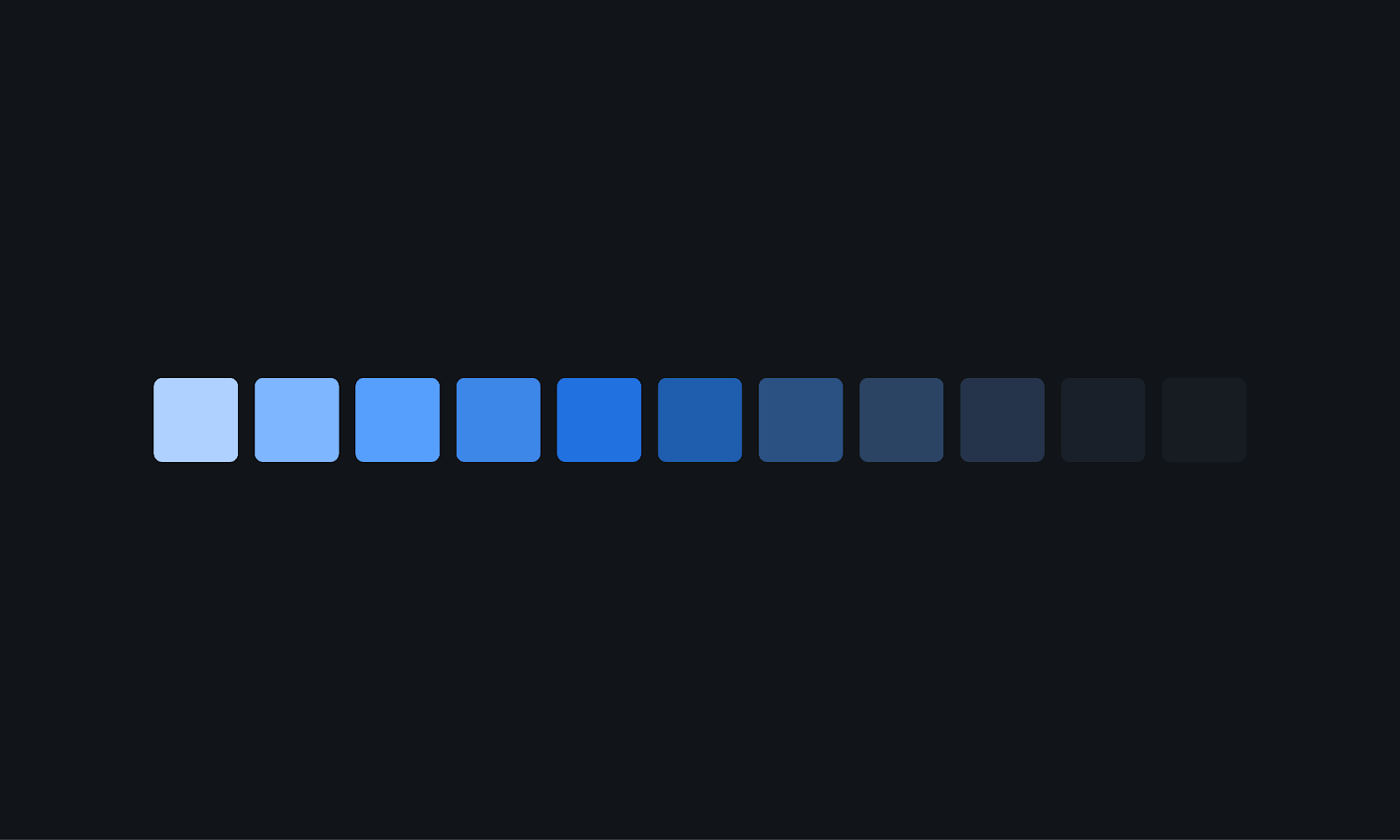

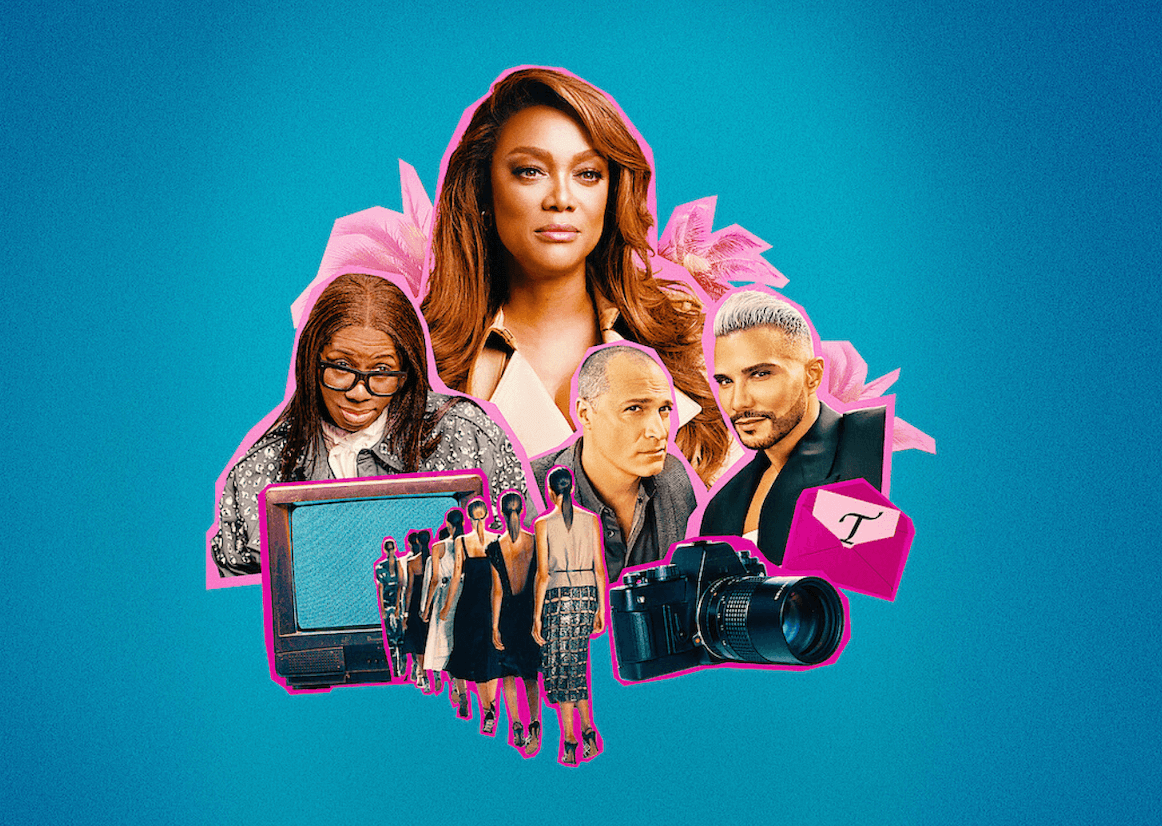

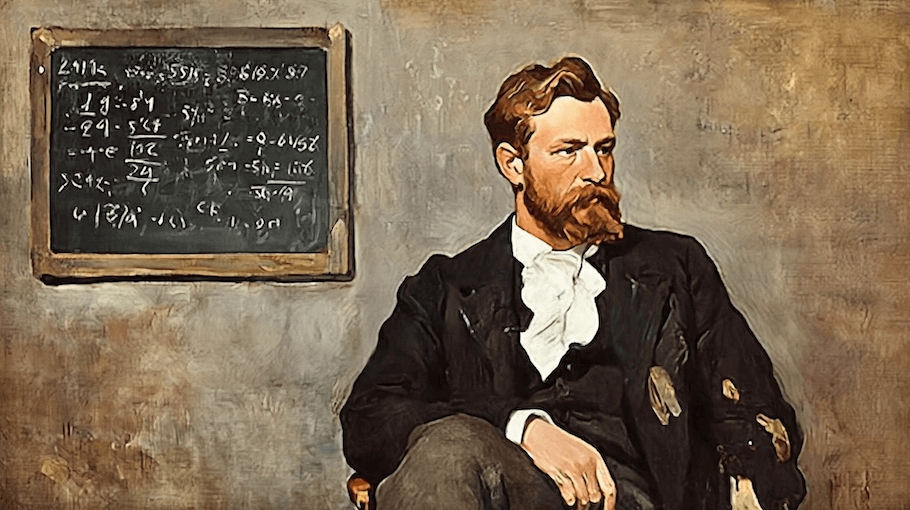

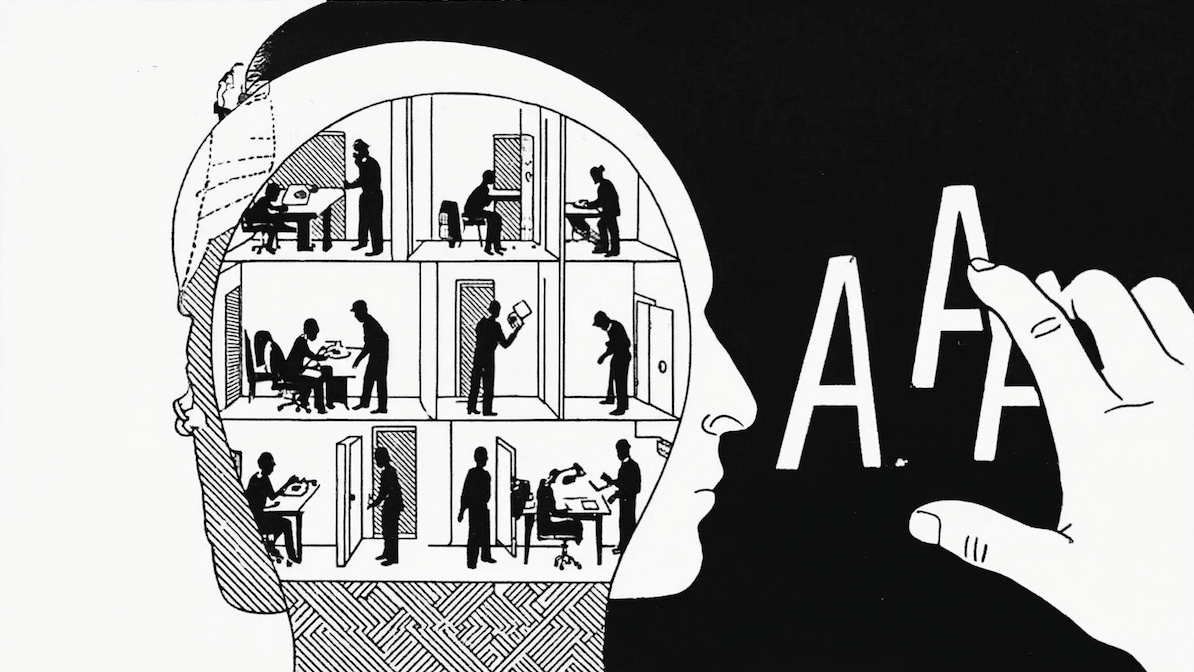

Por supuesto, el poder computacional no lo es todo.¿Qué modelo es más preciso? Aaaaah, ese es el Boca-River de la meteorología. Los expertos llevan 38 años discutiéndolo. La siguiente imagen muestra el coeficiente de correlación de anomalías para ambos modelos desde 2007 a 2022. Esto es, una cuantificación de la distancia entre lo proyectado y lo verificado. Para efectos de esta sencilla columnita no científica, baste decir que entre más cerca de 1 menor es la diferencia entre pronosticado y verificado (explicación detallada si esta cobarde renuncia a la complejidad matemática no lo satisface).

Dos cosas saltan a la vista:

- La primera, es que los sistemas van ganando precisión con el tiempo, a medida que se refinan los modelos y se gana potencia computacional (las cifras de petaflops de arriba son solo la foto del momento). A modo de aproximación muy gruesa, cada década avanzamos un día en el pronóstico. Es decir, un pronóstico a 5 días en el futuro en 2023 goza de una precisión parecida a uno de 4 días en 2013.

- La segunda, es que hasta ahora el europeo ha sido sistemáticamente más preciso que el gringo.

Ahora, estos modelos están pensados y calibrados para el hemisferio norte, donde vive la inmensa mayoría de la humanidad. ¿Qué ocurre a nivel local? Pues bien, Tamara Venegas de la Dirección Meteorológica de Chile efectuó una comparación sistemática. Al igual que el caso del coeficiente de correlación de anomalías subyace matemática más o menos compleja y no vamos a entrar a picar ahí. Para efectos de esta columnita baste decir que:

- La línea roja indica el monto de sobre o subestimación de lluvia. 0 indica que pronóstico de 0 mm en circunstancias que llovió, 1=acierto perfecto y hacia arriba sky is the limit of errors.

- La línea azul indica el Índice Comparable de Amenaza. Esto es, un cuantificador de aciertos, en que 0 indica idéntica capacidad predictiva a la de chimpancés borrachos arrojando dardos, y 1 la bola de cristal perfecta (aquí si esta cobarde renuncia a la complejidad matemática no lo satisface).

Notará primero la marcada tendencia a sobreestimar la lluvia (líneas rojas casi siempre mayores a 1), fenómeno que todos hemos experimentado en esas frecuentes fantasías pluviométricas que juegan con nuestras expectativas y que, una vez defraudadas, nos obligan a llorar bajo la lluvia en posición fetal.

Bajos valores de ETS indican muchas falsas alarmas. Lo peor es cuando se trata de eventos breves de precipitación. Entre Chillán y Puerto Montt andan harto mejorcito que en los extremos norte y sur, y las localidades costeras andan mejor que las del interior. En el norte grande, la capacidad de ambos de pronosticar eventos de precipitación es en esencia nula, aunque la extrema aridez de esa zona la vuelven una vara irrelevante, tal como no podemos esperar que una regla escolar sea precisa para medir bacterias.

¿Y cuál es el resultado del duelo? El promedio de ETS es ligeramente mejor para GFS (0,38) que para ECMWF (0,37). En el caso de la sobre o subestimación del monto, GFS falla en un promedio de 40,2%, siempre hacia arriba salvo en el caso de La Serena y Valparaíso. ECMWF, en cambio, falla en un promedio de 100,3%, aunque esa cifra está ensuciada por Arica y Antofagasta, lugares tan secos que una sobreestimación de 500% por ciento no significa nada (pronosticar 1mm cuando caen 0,2 mm). Considerado desde La Serena hacia el sur el sesgo baja a 76,3%, en todos y cada uno de los casos pronosticando MÁS de lo que cae, y con esa misma vara GFS baja a 30,5%. Así que, por estos lares, los gringos dan cancha, tiro y lado.

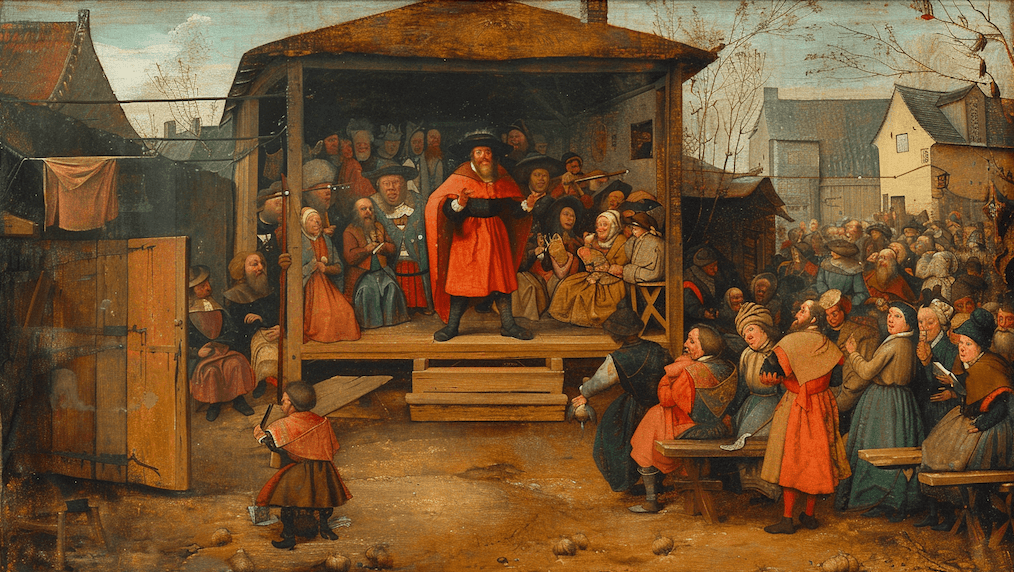

Dicho todo lo anterior, mi experiencia anecdótica sin datos duros de respaldo es que la mejor manera de prevenir este desatado sesgo húmedo es con el pronóstico de Meteochile, notoriamente menos optimista cuando se trata de precipitación. Los muchachos allí consideran los modelos ultrasofisticados como insumo, y luego corrigen sus demasías con sus años de circo analizando imágenes. Los meteorólogos de la televisión también gozan de la opción de utilizar lo que sea que escupan los modelos y sobre eso aplicar filtros humanos para morigerar las fallas que se saben ocurren en esta latitud particular.

Los computadores (aún) no tienen la última palabra.