Me preocupé por el efecto de la AI por primera vez en 2016. Ese fue el año donde se popularizaron las Generative adversarial Networks (GANS), un método que permitía generar imágenes de objetos y caras nuevas a partir de un conjunto de entrenamiento. El método produjo mucho entusiasmo en la comunidad y fue cuando por primera vez los investigadores empezaron a bromear con el hecho de que los avances estaban ocurriendo tan rápido que en algún momento los mismos artículos científicos serían escritos por IA. Era un chiste que se recibía con una risa un poco nerviosa, pero reconociendo que no estábamos ni cerca de que sucediera realmente.

Entre el 2016 y el 2022 hubo efectivamente varios avances, pero para muchos (incluyéndome) había una impresión de que el campo de la IA estaba estancado, de que el conjunto de tecnologías Deep Learning había llegado a su tope y que por lo tanto podíamos pensar que mucho de lo que se decía era puro hype. Fue en ese entonces cuando el Profesor de Berkeley Michael I. Jordan, autor de trabajos fundacionales en los aspectos estadísticos del Machine Learning, escribió en 2019 el artículo “AI: The revolution hasn’t happened yet” en donde trataba de bajarle los humos al campo diciendo, por ejemplo, que sería más apropiado llamar a la IA una “ingeniería centrada en datos”, y que no deberíamos preocuparnos de las fantasías apocalípticas sino más bien sobre los riesgos reales de las IA en la sociedad.

En el último año los avances y la adopción de estas tecnologías han sido tan vertiginosos que me ha hecho revisar mi postura escéptica de hace algunos años. No sé qué pensará Michael I. Jordan, pero yo creo que la revolución está sucediendo ahora mismo. Incluso con las infinitas críticas que podamos hacerle a ChatGPT (como su potencial para inventar falsedades o no reconocer sus errores), el punto acá es que el progreso está ocurriendo demasiado rápido y eso significa que podemos anticipar que muchas de las fallas que vemos hoy serán pronto solucionadas, aunque seguramente aparecerán nuevas.

Al mismo tiempo, al ser tan rápido el progreso perdemos la capacidad de predecir qué nuevas capacidades estarán disponibles y cómo ellas nos afectarán para bien o para mal. Como científico, me veo cada vez más limitado para comprender estos vertiginosos cambios: las técnicas matemáticas que antes me permitían entender los fundamentos de la IA ya no parecen tan útiles. Hace algunos años podía replicar experimentos en un computador. Hoy en día eso es posible solo en los grandes laboratorios del sector privado (OpenAI, Google, Microsoft, etc.).

Por mucho que la discusión sobre la inteligencia artificial esté cubierta por un halo de ciencia ficción y a veces de fatalismo, se trata de un debate político donde se están tomando posiciones y generando facciones muy rápidamente. Y más aún, esas posiciones políticas no cuadran del todo con las visiones tradicionales de derecha e izquierda. Mi motivación para escribir este artículo es exponer de qué se trata este debate (y sí, plantear una opinión). Lo hago porque el impacto de estas tecnologías es potencialmente muy grande y, por lo tanto, es mejor estar al tanto que mantenerse aislado.

Hace algunas semanas salió publicada una carta, firmada por reconocidas figuras del mundo académico, tecnológico y empresarial, que pedían pausar por seis meses las investigaciones en este campo. Aquí te explico por qué lo piden, quiénes lo piden, los principales argumentos y por qué decidí firmar la carta.

Primero, los hechos

El mayor hito reciente de la IA fue el lanzamiento de ChatGPT en Noviembre 2022, que generó una viralización masiva (en contra de las expectativas de OpenAI, sus creadores) y una permanente discusión sobre sus alcances y riesgos. ChatGPT es un chatbot que se construye sobre Large Language Model (LLM); específicamente GPT-3.5 (la versión estándar), un algoritmo que se alimenta de las inmensas cantidades de contenido generado en la internet para aprender una representación lingüística del mundo (esto con muchos matices filosóficos que omito para no alargar la discusión innecesariamente).

Más recientemente, el 14 de marzo de 2023, se liberó GPT 4, el más sofisticado de los modelos hasta ahora. Esta versión mejora sustancialmente a las anteriores y además permite multimodalidad: es decir, puede hacer sentido no solo de texto sino que también, por ejemplo, puede leer imágenes.

Para que te hagas una idea: GPT 4 pasó satisfactoriamente exámenes de diversas disciplinas (derecho, estadísticas, psicología, etc.), que para humanos requerirían años de preparación universitaria. Y lo hace sin que se le haya enseñado explícitamente el contenido, sino que por alguna razón es capaz de aprender cosas no del todo obvias sin que se le haya entrenado en la materia.

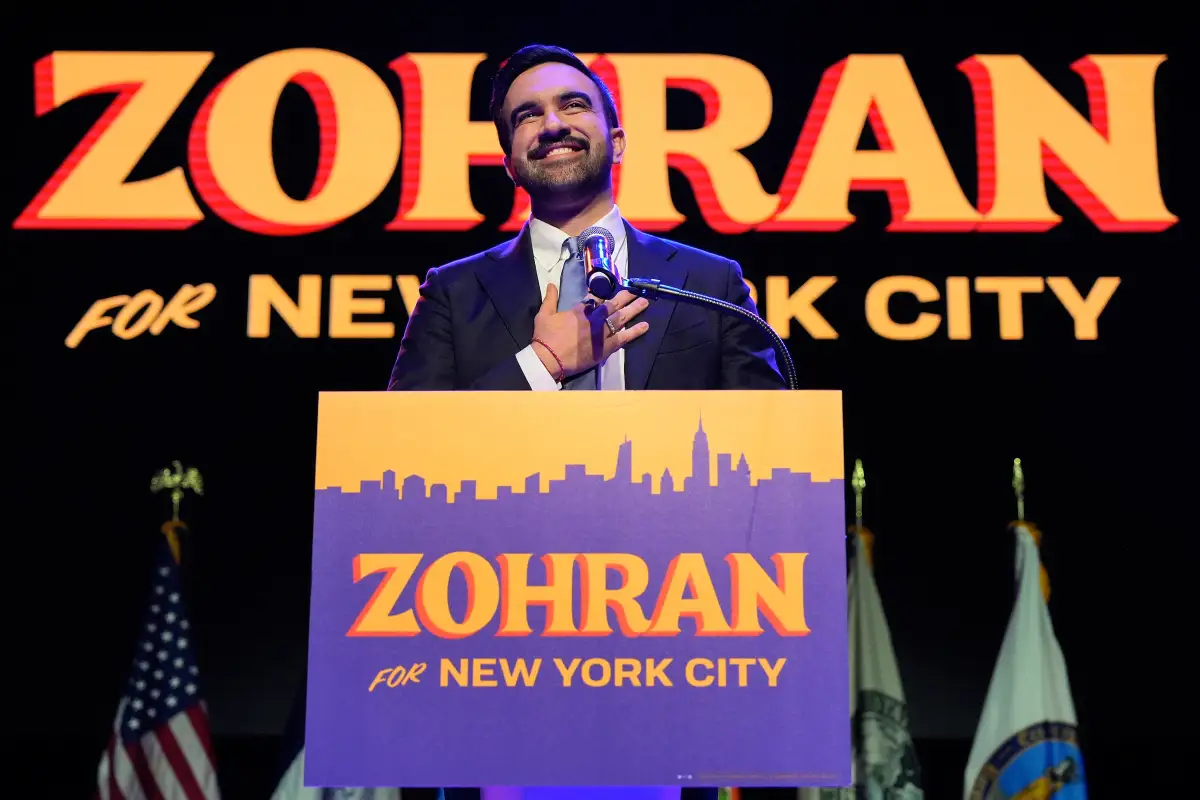

El moratorio del ‘Future of Life Institute’: detengan los experimentos de IA gigantes por 6 meses

El lanzamiento de GPT 4 y lo impresionante de sus resultados (esta vez no solo en el público general, sino entre académicos y expertos en AI) generó inmediatamente una gran discusión. El mejor ejemplo sobre la magnitud del debate es la carta abierta escrita por el ‘Future of Life Institute’ y firmada por figuras claves en IA como Yoshua Bengio y Stuart Rusell, junto con líderes corporativos como Elon Musk y Steve Wozniak, donde señalan lo riesgoso que puede ser que compañías como OpenAI sigan mejorando estos modelos sin producir al mismo tiempo la capacidad para mitigar los riesgos que conlleva la tecnología.

Este ‘moratorio’ todavía está produciendo reacciones: un clivaje donde se articulan las distintas posiciones en el espectro político. Y este espectro resulta muy poco intuitivo, de manera que dos personas pueden tener visiones muy similares políticamente, pero aún así estar en desacuerdo respecto a la carta, o viceversa. De hecho hay gente que ya plantea la existencia de ejes en el espectro político sobre la base de algunas posturas claves: ser de izquierda o derecha no explica mucho si estás a favor o en contra de las inteligencias artificiales.

Al mismo tiempo, hemos visto una argumentación deficiente y poco productiva basada en personas más que en ideas: no estoy de acuerdo porque X está de acuerdo.

La discusión, como puedes ver, no es fácil de entender. Por eso quiero contarte cuáles son estos ejes sobre los que se articula el debate, cuáles son los argumentos básicos y quiénes (y por qué) mantienen alguna posición.

¿Por qué el moratorio generó una reacción negativa?

La mayor crítica al moratorio es la que se le hace constantemente a la institución que lo publicó, el Futuro of Life Institute, FLI. En simple: se lo asocia a prácticas como el altruismo efectivo (EA, effective altruism) que a su vez se asocia a personas como Sam Bankman-Fried, el protagonista del escándalo reciente de las criptomonedas. Lo mismo sucede con Elon Musk: su firma es razón de sobra para algunas personas para rechazarla. En otras palabras, más allá del contenido de la carta, para muchos los firmantes y de dónde viene la idea ya son razón suficiente para rechazarla.

Una segunda crítica es sobre los aspectos prácticos, de que es sencillamente ridículo pensar que se puede pausar la investigación durante 6 meses y que de hecho es dañino (como dice Andrew Ng) porque significa frenar forzosamente resultados que pueden mejorar nuestra calidad de vida (por ejemplo, a través de las aplicaciones en medicina).

1/The call for a 6 month moratorium on making AI progress beyond GPT-4 is a terrible idea.

— Andrew Ng (@AndrewYNg) March 29, 2023

I'm seeing many new applications in education, healthcare, food, ... that'll help many people. Improving GPT-4 will help. Lets balance the huge value AI is creating vs. realistic risks.

Asimismo, hay quienes critican que la firma a la carta puede venir sospechosamente de agentes que se estén quedando atrás y se beneficiarían de la pausa para ponerse al día. Y si esos agentes son estados entonces se puede convertir en una razón de disputa geopolítica.

Andrew is right, a moratorium on AI progress is a terrible idea. It is unenforceable, and would be a gift to bad actors and hostile nations who will accelerate their efforts while ethical researchers are forced to pause. https://t.co/3roZqRoSWu

— Pete Skomoroch (@peteskomoroch) March 30, 2023

Hay una tercera línea de críticas que voy a elaborar más porque es donde finalmente se generan las divisiones. Esta crítica aparece cuando se entiende mejor el ethos del FLI y su visión. El FLI adscribe al pensamiento ‘largoplacista’ (longtermism), es decir, el objetivo político del FLI es pelear por garantizar la supervivencia del ser humano en el largo plazo: de ahí que también investiguen temas como energía nuclear y cambio climático.

En la carta esto se ve en la manera grandilocuente en que se expresa la preocupación, hablando de la posibilidad de “perder el control de la civilización” y de la existencia de “mentes digitales no-humanas que posiblemente se hagan más inteligentes que nosotros y nos reemplacen”.

Como explica este artículo, el problema con el largoplacismo es que sus preocupaciones son demasiado abstractas, y que esconde por omisión riesgos y problemas más urgentes. Incluso, esos problemas urgentes vienen gestándose hace casi una década, desde que aparecieron los primeros sistemas de inteligencia artificial. Como dice la lingüista Emily Bender, cuando priorizamos problemas hipotéticos del futuro, estamos perpetuando injusticias sociales del presente.

Además, el largoplacismo está fuertemente asociado a ciertos cultos seculares hiper racionalistas como el TESCREAL (transhumanism, extropianism, singularitarianism, cosmism, rationalism, effective altruism, and longtermism), que plantean que nos acercamos a un momento de simbiosis entre el ser humano y las máquinas (lo que otros han llamado singularidad). El problema que muchos ven en estos cultos es una narrativa eugenésica solapada: el transhumanismo sería la única manera de existir en el futuro.

Y es debido a esta dualidad que muchas personas se hayan opuesto al moratorio a pesar de estar de acuerdo sustancialmente con muchos de sus puntos. Por ejemplo, las reconocidas investigadoras Timnit Gebru, Emily Bender, Margaret Mitchell, Melanie Mitchell y otras tantas quienes tildaron la carta como “horrible”, a pesar de que la misma cita como una de las mayores preocupaciones lo que Gebru y su colegas manifestaron originalmente en el artículo de los Stochastic Parrots. La tesis central del artículo es que los LLMs tienen la tendencia a escupir contenido hegemónico de la internet, que nos recuerda uno de los problemas más básicos de GPT que todavía no podemos resolver: cómo diferenciar contenido generado por humanos versus una Inteligencia Artificial.

Since we've been looking for more things to do, @emilymbender @mmitchell_ai @mcmillan_majora and I wrote a statement about the horrible "letter" on the AI apocalypse, the very first citation of which, was our #StochasticParrots paper. https://t.co/6kFtBcXhZj pic.twitter.com/sntp5YICpC

— @timnitGebru@dair-community.social on Mastodon (@timnitGebru) March 31, 2023

Entonces, nos encontramos frente a un asunto complejo donde, a pesar de haber concordancia, las oposiciones finales están más bien mediadas por las retóricas y las motivaciones que se leen entre líneas. Mi opinión es que por muy válida que sea la crítica al largoplacismo, esta también sobre-simplifica algunos conceptos que sí son genuinamente importantes.

Intentaré hacer una distinción más fina entre las distintas motivaciones para estar de acuerdo o no con los puntos de esta carta. Hay dos corrientes de argumentos principales, las basadas en el AI alignment y las basadas en los aspectos políticos y sociales de la IA. Voy a describir ambas a continuación.

Qué es el AI alignment

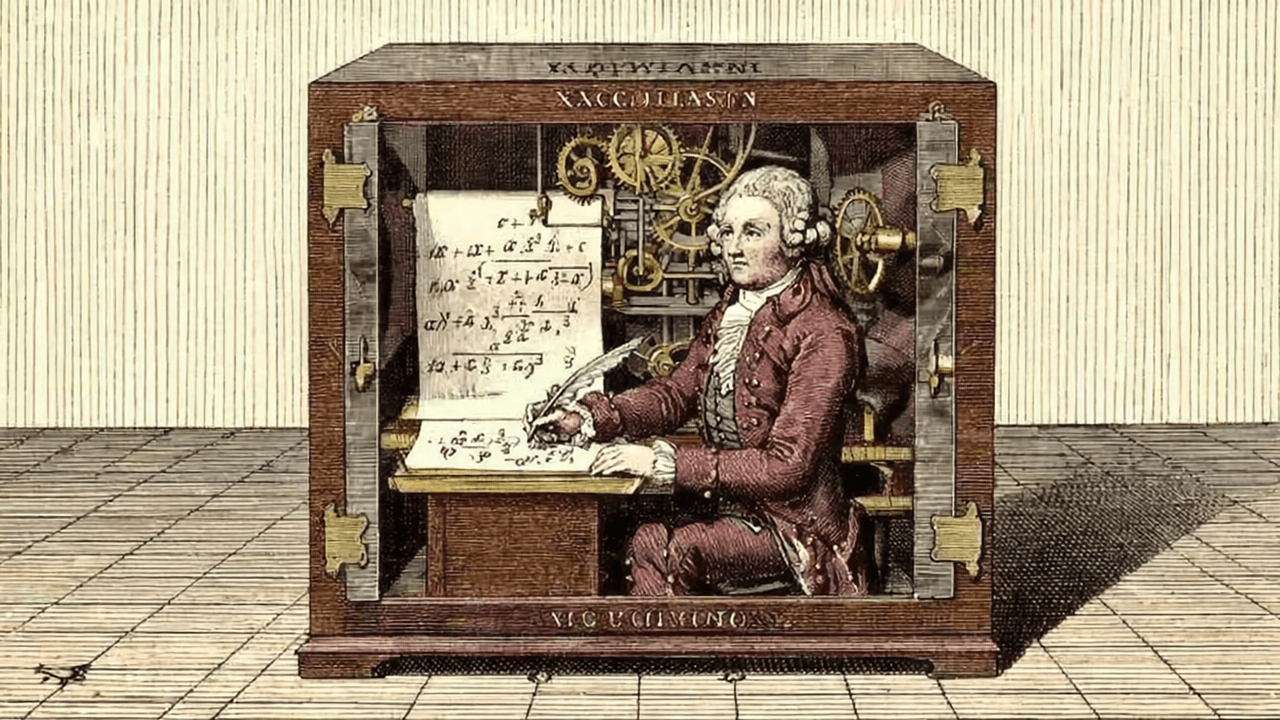

El problema del AI alignment fue planteado originalmente por Norbert Wiener en un artículo de Science de 1960. Su preocupación era, esencialmente, cómo nos aseguramos de que el propósito de un agente artificial sea el que queremos darle. En su sentido más extremo se trata de evitar la fantasía catastrofista de Skynet, o de que una IA sea capaz de revelarse contra su creador.

A pesar de que las visiones más extremas tienden a ser rechazadas y desestimadas por ser algo más bien cercano a una religión apocalíptica, las versiones menos plagadas de hype y sensacionalismo son genuinamente relevantes porque se preocupan de que los agentes creados sean confiables, calibrados y controlables.

Por eso es que el tema se ha popularizado en la investigación académica. Por ejemplo, el prominente investigador y Profesor David Duvenaud del Vector Institute de Toronto anunció recientemente que, debido a su creciente preocupación, cambió radicalmente el tema principal de su investigación, originalmente en temas de modelos generativos, para volcarse completamente al problema de la alineación y la reducción de riesgos.

Este tipo de preocupaciones se hacen cada vez más relevantes en la medida que se discute el grado en que los agentes de inteligencia artificial contemporáneos son o se acercan al ideal de inteligencia artificial general (Artificial General Inteligene: AGI), también llamado superinteligencia artificial.

Este es un debate abierto donde hay todo un espectro de posiciones, desde las más escépticas (como la de Chomsky), que plantean que no hay nada especial en los avances recientes, hasta las más crédulas (y usualmente más catastrofistas), que plantean que actualmente se están produciendo in-silico (100% hechas por un computador) entidades más inteligentes que nosotros y que esencialmente ya estamos a su merced. En este lado del espectro la opinión más visible es la de Eliezer Yudkowsky, fundador del sitio web de debate y divulgación LessWrong, y del Machine Intelligence Research Institute (MIRI), un think tank asociado a personas como Peter Thiel y Ray Kurzweil. Yudkowsky luego de la publicación del moratorio escribió una columna de opinión para la revista Time pidiendo deshacerse ahora ya de todas las herramientas avanzadas de IA, debido al peligro inminente que representarían no en el futuro, sino hoy mismo.

Entre estos dos extremos se encuentran la mayoría de las visiones más moderadas que expresan distintos grados de optimismo o pesimismo sobre una AGI no alineada, y si en primer término es posible crear una AGI y que, de ser posible, cuál es el momento en el que deberíamos preocuparnos.

Por ejemplo, Geoffrey Hinton (para muchos reconocido como el mayor responsable intelectual de las técnicas computacionales que dieron paso a lo que hoy entendemos como IA) dijo en una reciente entrevista para CBS que era importante preguntarse cómo controlar estos agentes, y que no le parecía inconcebible la posibilidad de que la IA arrase con todos los seres humanos (plantear una posibilidad es distinto a plantear una certeza: harto menos catastrofista que algunos de sus colegas).

A nivel de expertos existe evidencia de estas posturas moderadas: una encuesta reciente mostró que casi la mitad de los participantes (elegidos de entre los autores de artículos de NeuRIPS e ICML, dos de las conferencias más importantes en IA) manifestaron creer que existía una probabilidad mayor a 10% de que la humanidad fuese extinguida por una IA. Hay que reconocer, en todo caso, que las encuestas pueden tener sesgos y que algunos autores de la encuesta están afiliados a MIRI, institución más bien asociada a una visión extrema.

Las preocupaciones sociales: mercados laborales, concentración del poder, desigualdad

Además de la discusión sobre la alineación, existe un debate sobre los efectos sociales y políticos de la irrupción de la IA. Algunos de estos aspectos también son mencionados en el moratorio: problemas concretos como la automatización y la pérdida de trabajos, la posibilidad de herramientas más avanzadas de desinformación y las consecuencias de ambas para la economía y el funcionamiento de la democracia.

Otros aspectos no están explícitos en el moratorio pero siguen siendo bien relevantes. Por ejemplo, Yoshua Bengio (otro de los investigadores más influyentes en la inteligencia artificial) hizo un punto sobre ‘actitudes corporativas’ que lo convencieron de firmar el moratorio. Entre otras cosas, porque el advenimiento de ChatGPT significó el inicio de una suerte de carrera armamentista entre corporaciones donde el énfasis es en apurarse en obtener un producto aparentemente impresionante pero en desmedro de los “buenos hábitos de transparencia y ciencia abierta que habían caracterizado a esta rama de la ciencia”.

A pesar de que esta crítica se plantea desde la ciencia, Yoshua está lejos de ser el único: las autoras del artículo de los Stochastic Parrots señalan como otra preocupación la explotación laboral. Y no es mera especulación: hace poco vimos el caso reportado por la revista Time sobre personas en Kenya trabajando por menos de 2 dólares la hora para hacer el contenido de ChatGPT menos tóxico mediante la catalogación y curatoría de contenido ofensivo, y que implican la exposición a ese tipo de contenido como condición laboral. Este ejemplo es uno más de la documentada asimetría de poder entre corporaciones y empleados.

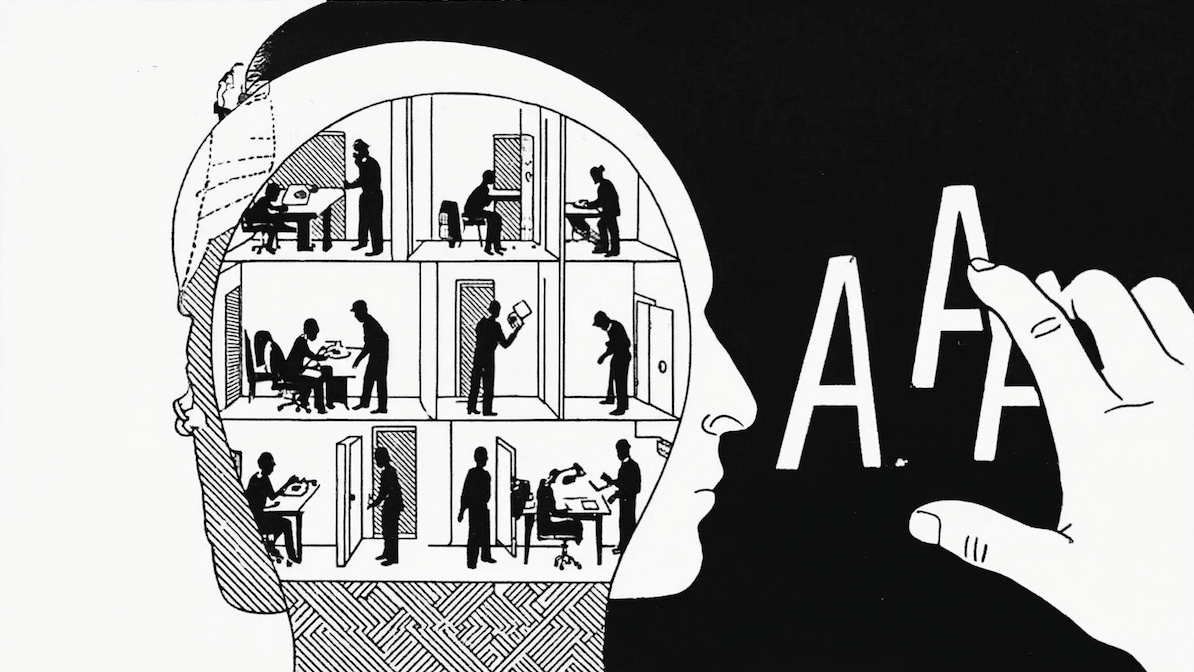

Y es finalmente el hecho de que los avances de la IA estén cada vez más restringidos a las corporaciones lo que genera mayor preocupación en la carencia de marcos regulatorios. El Profesor de Oxford Michael Osborne planteó en una reciente entrevista que no es casual que sea así: “una forma de ver a las corporaciones es como una manera de procesar información y tomar decisiones. Mientras un individuo único está limitado en la cantidad de información que puede tomar, la corporación sortea esa limitación juntando a mucha gente y teniendo estructuras que faciliten el flujo de información”. Las corporaciones son capaces de combinar información global y local sobre los usuarios para maximizar sus ganancias y la IA les sirve para aumentar esa capacidad. En ese sentido, podríamos verla como “una extensión del poder tradicional de las corporaciones”.

Osborne es reconocido en el campo hace años por haber planteado tempranamente (en 2013) la discusión sobre el hecho de que la IA haría redundantes muchos trabajos. Han pasado diez años desde ese hito y el nivel de avance tecnológico ha sido tan vertiginoso que se ha hecho extremadamente difícil predecir cuáles son los trabajos más susceptibles a ser automatizados. Un trabajo reciente de investigadores de Open AI y la Universidad de Pennsylvania acaparó atención al sugerir que (contrario a lo que se hubiese pensado) algunas de las ocupaciones más expuestas al impacto de herramientas como ChatGPT son aquellas que requieren un nivel de entrenamiento académico sustancial, como el de un matemático.

Es ciertamente muy temprano para entender el impacto que estas tecnologías tendrán finalmente, y si el efecto de la exposición será el de dejar a millones de personas sin empleo o bien el de mejorar la calidad de vida al ahorrar las partes más tediosas del trabajo. Esta incertidumbre está generando ansiedades y encausando movimientos políticos, incluso se habla del advenimiento de un neoludismo. El ludismo fue un movimiento reaccionario durante la revolución industrial que se opuso al desarrollo de nuevas tecnologías porque dejaban a mucha gente sin trabajo.

Un ejemplo de cómo se elaboran estas preocupaciones lo da el economista político de izquierda Yanis Varoufakis, que plantea que estamos entrando a un nuevo estadío social denominado tecno feudalismo, caracterizado por el declive de las instituciones capitalistas tradicionales y la emergencia de las grandes corporaciones tecnológicas, cuya riqueza se basa en la economía digital. Si bien esta es una hipótesis controversial y para muchos catastrofista, cabe al menos preguntarse en qué medida puede haber algo de cierto.

Palabras finales

Expuse acá las preocupaciones tanto desde la vereda del largoplacismo como desde las “preocupaciones reales”. Pero puede que incluso la distinción entre ambas no sea tan grande. Podemos pensar quizás que un robot maligno es una metáfora que representa los algoritmos desplegados por humanos sin estándares éticos. Es importante no caer en razonamientos del tipo si Elon Musk está preocupado entonces no es realmente importante, porque nos lleva a negar o subestimar un problema solo porque otra persona antagónica lo cree.

Acá dejo mi ‘declaración de intereses’: creo que la pandemia fue un ejemplo clarísimo de la manera en que consistentemente ignoramos los riesgos reales que tenemos frente a nuestros propios ojos. Recuerdo en marzo de 2020 cuando muchas personas negaban la magnitud del problema porque en ese momento muy poca gente había muerto (ergo, la mortalidad era muy baja para ser preocupante). Para mí, una lección de la pandemia es la necesidad de actuar con precaución en torno a situaciones no del todo conocidas, o cuyos alcances aún no comprendemos.

Nota de edición 13 de Abril 2023: El texto original decía que la carta era de "Future of Humanity Institute". Ya fue corregido por su nombre real, "Future of Life Institute".